在Linux系统性能优化领域,磁盘I/O是最易成为瓶颈的核心环节。无论是数据库高频读写、日志海量存储,还是大数据离线处理,I/O性能直接决定系统的响应速度与业务吞吐量。不少开发者、运维人员在遭遇I/O瓶颈时,常陷入“盲目调参”的误区,却忽视了“先定位、再优化”的核心逻辑。本文基于Linux I/O栈底层原理,从基准测试切入,逐层拆解应用程序、文件系统、磁盘硬件三层优化思路,帮你构建系统化、可落地的I/O性能调优能力。

一、优化前必做:I/O基准测试(明确目标,拒绝盲目调参)

优化的前提是“知其然更知其所以然”——你需要先明确:当前磁盘/文件系统的性能上限是什么?应用的I/O需求与硬件极限存在多大差距?这就要求通过基准测试获取客观数据,为后续优化提供量化依据,避免凭经验、靠感觉调参。

1. 核心测试工具:fio

fio(Flexible I/O Tester)是Linux生态下最主流的I/O基准测试工具,支持随机读/写、顺序读/写等全场景模拟,可自定义块大小、I/O引擎、缓存策略等核心参数,能精准复现不同业务的I/O访问特征。

(1)fio安装

不同Linux发行版的安装命令简洁直观,直接执行即可:

# Ubuntu/Debian系列apt-get install -y fio# CentOS/RHEL系列yum install -y fio

(2)常见场景测试命令

以下命令覆盖日常最典型的4类I/O场景,重要提醒:若直接测试原始磁盘(如/dev/sdb),会直接破坏磁盘原有文件系统,测试前务必备份所有重要数据!

# 1. 随机读(4K小文件,异步I/O,队列深度64,模拟数据库场景)fio -name=randread -direct=1 -iodepth=64 -rw=randread -ioengine=libaio -bs=4k -size=1G -filename=/dev/sdb# 2. 随机写(参数含义同上,仅I/O模式改为随机写)fio -name=randwrite -direct=1 -iodepth=64 -rw=randwrite -ioengine=libaio -bs=4k -size=1G -filename=/dev/sdb# 3. 顺序读(模拟大数据离线处理、文件拷贝场景)fio -name=seqread -direct=1 -iodepth=64 -rw=read -ioengine=libaio -bs=4k -size=1G -filename=/dev/sdb# 4. 顺序写(模拟日志写入、数据备份场景)fio -name=seqwrite -direct=1 -iodepth=64 -rw=write -ioengine=libaio -bs=4k -size=1G -filename=/dev/sdb

(3)关键参数解读

direct:是否跳过系统页缓存(1=跳过,0=使用缓存);测试硬件原生性能时建议设为1,排除缓存干扰

iodepth:异步I/O的最大并发请求数,队列深度直接影响吞吐量(队列过浅无法充分利用硬件资源,过深可能导致延迟飙升)

rw:I/O模式(read/write=顺序读/写,randread/randwrite=随机读/写,rw=randrw=混合读写)

ioengine:I/O引擎(libaio=Linux原生异步I/O,sync=同步I/O,mmap=内存映射I/O)

bs:I/O块大小(默认4K,可根据业务场景调整:数据库用4K/8K,大数据用128K/256K)

filename:测试目标(磁盘路径=测试硬件性能,文件路径=测试文件系统性能)

(4)测试报告核心指标

fio输出报告中,重点关注以下5个核心指标,它们是评估I/O性能的关键量化依据:

slat:I/O提交延迟(从请求发起至内核开始处理的时间,反映请求提交效率)

clat:I/O完成延迟(从请求提交至处理完成的时间,异步I/O场景核心关注指标)

lat:总延迟(从创建I/O请求到完成的全链路时间,近似等于slat+clat)

bw:吞吐量(单位MiB/s或MB/s,反映单位时间内数据传输能力,顺序I/O核心指标)

IOPS:每秒I/O次数(随机I/O场景核心指标,如数据库高频小请求场景)

补充说明:同步I/O场景下,请求提交与处理完成是同一流程,因此clat会显示为0,此时slat即可代表实际的I/O完成延迟。

(5)精准模拟应用I/O模式:blktrace+fio重放

常规测试场景难以完全匹配真实业务的I/O特征(如复杂的读写比例、块大小分布),此时可通过“blktrace记录真实I/O+fioreplay重放”的组合方案,精准复现业务的I/O行为,让测试数据更具参考价值:

# 1. 用blktrace跟踪目标磁盘的真实I/O行为(需指定业务访问的磁盘,如/dev/sdb)blktrace /dev/sdb# 2. 将跟踪日志转换为fio可识别的二进制文件blkparse sdb -d sdb.bin# 3. 用fio重放跟踪日志,获取贴近真实业务的I/O基准数据fio --name=replay --filename=/dev/sdb --direct=1 --read_iolog=sdb.bin

二、分层优化思路:从应用到磁盘的全栈突破

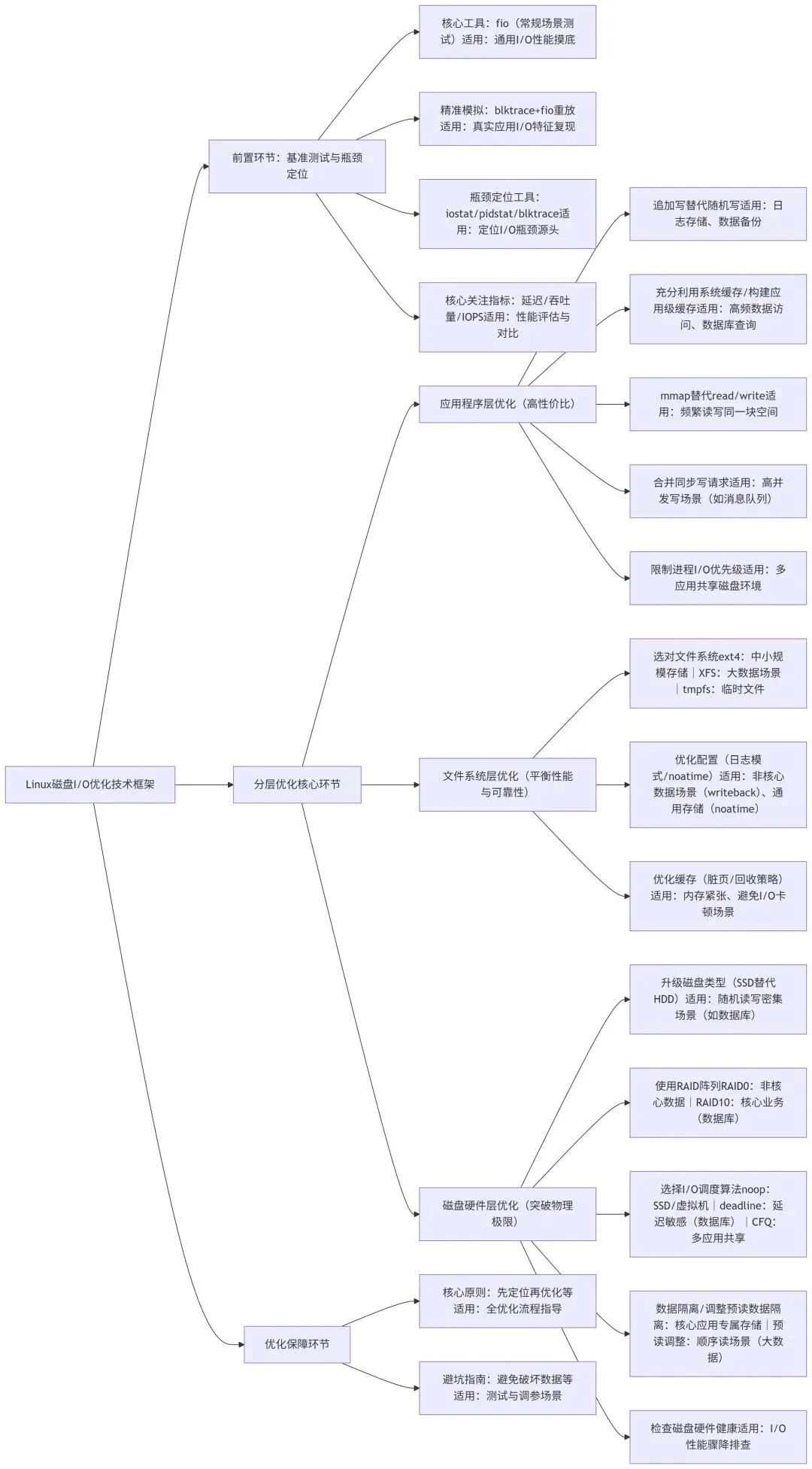

Linux I/O栈自上而下分为应用层、文件系统层、磁盘硬件层,优化需遵循“自上至下”的逻辑——先从应用层减少无效I/O请求,再通过文件系统优化I/O调度效率,最后借助硬件升级突破物理性能极限。整体技术框架如下:

1. 应用程序层优化(最易落地,性价比最高)

应用程序是I/O请求的发起源头,通过优化应用的I/O模式和缓存策略,无需改动底层环境即可大幅提升性能,是性价比最高的优化环节:

用追加写替代随机写:机械硬盘(HDD)的随机写需要频繁移动磁头寻址,性能极低;追加写可让数据连续存储,最大程度减少磁头移动开销,典型适用场景:日志存储、数据备份、消息队列持久化。

充分利用系统缓存:优先使用标准库函数(如fopen、fread、fwrite)而非直接调用系统调用(open、read、write),标准库自带缓冲区机制,可自动合并小I/O请求,减少实际磁盘访问次数。

构建应用级缓存:对于高频访问的热点数据,建议在应用内部实现缓存逻辑,或接入Redis、Memcached等分布式缓存系统。核心优势:可自主控制缓存数据的生命周期和淘汰策略,避免被其他应用抢占系统页缓存(典型案例:MySQL数据库若仅依赖系统缓存,当缓存被清理后,查询延迟可能从0.1s飙升至15s)。

用mmap替代read/write:当需要频繁读写同一块文件空间时,使用mmap(内存映射)替代传统的read/write调用,可将文件直接映射到进程地址空间,减少“用户态-内核态”的数据拷贝环节,显著提升I/O效率。

合并同步写请求:避免使用O_SYNC标志(强制每个写请求同步落盘),建议采用“批量写入+fsync()同步”的方式,将多个小写请求合并为一个大写请求后再同步到磁盘,减少磁盘刷盘次数。

限制进程I/O优先级:多应用共享磁盘资源时,需通过技术手段保障核心应用的I/O资源优先级:一是用cgroups限制非核心应用的IOPS和吞吐量上限;二是若使用CFQ调度器,通过ionice命令调整进程I/O优先级(Realtime>Best-effort>Idle),确保数据库、核心业务等关键应用优先获取I/O资源。

2. 文件系统层优化(平衡性能与可靠性)

文件系统是连接应用与磁盘的中间层,负责磁盘空间管理、I/O请求调度和数据可靠性保障。选择适配场景的文件系统并优化配置,是提升I/O性能的关键环节:

选对文件系统:需根据业务场景选择适配的文件系统,避免“一刀切”选型:

ext4:适用于中小规模存储场景,支持磁盘收缩、日志恢复,兼容性极佳(Ubuntu默认文件系统);

XFS:支持超大规模存储(单文件系统最大16EB),顺序读写吞吐量高,延迟稳定性好,适合大数据离线处理、分布式存储等场景(CentOS 7及以上默认文件系统);

tmpfs:内存文件系统,数据存储在内存中,无实际磁盘I/O,适合存储临时文件、高频访问的缓存数据(如/dev/shm目录,默认大小为物理内存的一半)。

优化文件系统配置:

调整日志模式:ext4、XFS均支持三种日志模式——journal(全日志,可靠性最高,性能最差)、ordered(顺序日志,默认模式)、writeback(回写日志,性能最优,可靠性最低);非核心数据场景(如日志存储)可选用writeback模式提升性能。

添加挂载选项:在/etc/fstab文件或mount命令中添加noatime参数(禁用文件访问时间更新),减少文件元数据的写入次数;若业务无需记录文件修改时间,可额外添加nodiratime参数(禁用目录访问时间更新)。

优化文件系统特性:对于ext4文件系统,可通过tune2fs工具开启ext_attr(扩展属性)、dir_index(目录索引)特性,提升大目录(文件数10万+)的查询效率。

优化文件系统缓存:

调整脏页刷新策略:通过内核参数控制内存脏页量,避免大量脏页集中刷盘导致I/O卡顿——/proc/sys/vm/dirty_background_ratio(后台刷新脏页阈值,默认10%,内存脏页占比达到该值时触发后台刷盘)、/proc/sys/vm/dirty_ratio(强制刷新脏页阈值,默认20%,达到该值时阻塞应用进程强制刷盘),可根据内存大小和业务场景微调。

调整缓存回收倾向:/proc/sys/vm/vfs_cache_pressure参数(默认100)控制内核回收目录项和索引节点缓存的倾向,数值越大越容易回收;内存紧张场景可适当调大(如150),保障应用内存需求;I/O密集场景可调小(如50),保留更多缓存提升I/O效率。

3. 磁盘硬件层优化(突破物理极限)

当应用层、文件系统层优化达到瓶颈后,需通过硬件升级或配置调整突破物理性能限制,这是提升I/O性能的最后一道防线:

升级磁盘类型:用SSD(固态硬盘)替代传统HDD(机械硬盘),SSD无机械磁头和盘片,彻底摆脱寻址延迟限制,随机读写性能可提升10-100倍,是提升I/O性能最直接、最有效的方式,典型适用场景:数据库、高频读写业务。

使用RAID阵列:将多块磁盘组合为RAID阵列,兼顾性能提升与数据可靠性,根据业务需求选择合适级别:

RAID 0:条带化存储,无数据冗余,读写性能随磁盘数量线性提升,适合非核心数据(如临时计算数据);

RAID 10:先镜像(RAID 1)再条带化(RAID 0),兼具高可靠性和高性能,适合数据库、核心业务等对数据安全和性能均有高要求的场景。

选择合适的I/O调度算法:I/O调度算法决定内核如何排序和分发I/O请求,需根据磁盘类型和业务场景选择,通过/sys/block/[磁盘名]/queue/scheduler文件查看当前调度器,直接写入名称即可修改(永久生效需配置内核参数):

noop:简单FIFO队列,无复杂调度逻辑,适合SSD和虚拟机磁盘(无机械寻址开销,调度增益极低);

deadline:按请求完成时间排序,确保每个请求都有明确的完成时限,避免请求饥饿,适合数据库、交易系统等对延迟敏感的场景;

CFQ:完全公平调度器,按进程分配I/O带宽,确保所有应用公平获取资源,适合多应用共享磁盘的通用服务器场景。

数据隔离存储:为I/O压力大的核心应用(如数据库、日志系统、分布式存储)配置独立磁盘或磁盘阵列,避免不同应用争抢I/O资源,减少相互干扰。

调整磁盘预读大小:顺序读场景下,增大预读大小可让内核提前读取后续数据到缓存,减少I/O请求次数,显著提升吞吐量;随机读场景无需调整(预读无效),配置方式如下: `

# 方法1:直接修改内核参数(单位KB,默认128KB,顺序读场景建议调整为8192KB) echo 8192 > /sys/block/sdb/queue/read_ahead_kb

方法2:用blockdev工具(单位512B扇区,数值为read_ahead_kb的2倍)

blockdev --setra 16384 /dev/sdb`

检查磁盘硬件健康:磁盘硬件故障(如坏道、磁头老化、接口松动)会导致I/O性能骤降,需定期排查:通过dmesg命令查看内核输出的磁盘硬件故障日志;用badblocks工具检测磁盘坏道;用smartctl工具查看磁盘S.M.A.R.T信息;用e2fsck(ext4)、xfs_repair(XFS)工具修复文件系统错误(修复前需卸载磁盘)。

三、优化核心原则与避坑指南

1. 核心原则

“先定位,再优化”:优化前必须通过iostat、pidstat、blktrace等工具定位瓶颈源头——是应用发起的I/O请求过多?还是文件系统调度低效?或是磁盘硬件性能不足?避免盲目调参浪费时间。

“减少I/O优先于优化I/O”:磁盘是I/O栈中速度最慢的环节,优先通过缓存、请求合并、数据压缩等方式减少无效I/O请求,再优化现有I/O的执行效率,性价比更高。

“平衡性能与可靠性”:所有优化都需在性能提升与数据可靠性之间找到平衡点,例如:writeback日志模式虽性能优异,但断电可能导致数据丢失;关闭文件系统日志可提升性能,但数据损坏后无法恢复,核心业务需谨慎权衡。

2. 常见坑点

测试时破坏生产数据:用fio直接测试生产环境的磁盘(如/dev/sda系统盘),导致文件系统损坏、业务中断,解决方案:测试前确认目标磁盘无重要数据,或在测试环境搭建同源环境验证。

过度调大磁盘队列长度:盲目增大iodepth参数追求高吞吐量,导致I/O延迟飙升,解决方案:根据磁盘类型调整,HDD队列深度建议64-128,SSD建议32-64,延迟敏感场景需严格控制队列深度。

忽略缓存抢占问题:仅依赖系统页缓存提升性能,未构建应用级缓存,当其他应用占用大量内存时,系统缓存被回收,导致业务性能暴跌,解决方案:核心业务必须实现应用级缓存,关键数据双缓存兜底。

统一配置所有磁盘:对SSD和HDD采用相同的I/O调度器、预读大小等配置,无法发挥硬件优势,解决方案:按磁盘类型差异化配置,SSD用noop调度器+小预读,HDD用deadline/CFQ调度器+大预读。

四、总结

Linux磁盘I/O优化并非“调几个内核参数就能一劳永逸”,而是一套“基准测试-瓶颈定位-分层优化-验证效果”的闭环系统化流程。从应用层的缓存设计、请求合并,到文件系统的选型配置、日志优化,再到硬件层的磁盘升级、RAID阵列搭建,每一层都有明确的优化方向和可落地的实操方案。整个优化过程的核心思路是:

尽可能减少无效磁盘I/O次数,让有限的I/O资源优先服务于核心业务。

最后需要强调:优化没有“银弹”,所有方案都需结合实际业务场景(如HDD/SSD选型、随机/顺序I/O占比、延迟/吞吐量优先级)灵活调整,并通过基准测试验证优化效果。希望本文的分层优化思路和实操指南,能帮你在实际工作中高效解决磁盘I/O性能瓶颈,提升系统稳定性和业务吞吐量!