一行代码将 arXiv 论文翻译成中文版

- 2026-01-31 19:13:47

@苏剑林

1 月 28 日发布于知乎

认识比较久的老读者或许都知道,笔者算是一个比较坚定的「古法编程爱好者」——至今仍不用 IDE、不用代码补全、编辑器只需语法高亮即可。就连科学空间的博文,都是笔者一个个字敲的 HTML 源码(当然这有些历史原因),还有 Cool Papers 的从前端到后端的整站代码,也都是笔者手敲的。

但即便是笔者这样的「老顽固」,也不得不承认:对于某些任务,通过 Code Agent 来完成具有无与伦比的优势——甚至于你想纯手写,都有种无从下手的感觉。

这篇文章就介绍一个经典例子,用一行代码翻译 arXiv 论文。

先说方法

首先在本地部署好 kimi-cli ,配置好使用 kimi-k2.5 ,然后还要装一个 LaTeX 编译环境(笔者用的是 MacTeX),最后从 arXiv 下载论文源码,解压并进入到源码,执行

kimi --print --prompt 「你所在目录是一篇英文论文的 latex 源码,你需要做的是将论文翻译成中文版本,要求所有英文文字内容都翻译成中文,公式不变,表格、图片等只翻译必要的 caption,代码框、算法框也只需翻译必要的注释,而人名不必翻译;将翻译后的新源码保存到当前目录下名为「paper_cn」的新目录中,要注意保持源码的可编译性;翻译完后要仔细检查一遍,看有没有漏翻译的章节和文件;最后,用 xelatex 将翻译结果重新编译成 pdf,返回生成的 pdf 路径。如果翻译内容较多,应当开启多个 subagent 来并行翻译。」

然后就可以等待论文翻译完成了。期间,kimi 会自动分析目录结构,找到要翻译的文件,翻译完成后会尝试编译,根据编译的错误信息进一步调整翻译结果,直到编译成功得到 pdf。如果你连下载源码都想省了,那么可以尝试。、

kimi --print --prompt 「从 arXiv 上下载 id 为 2502.16982 的论文源码,然后解压并将它翻译成中文版本,要求所有英文文字内容都翻译成中文,公式不变,表格、图片等只翻译必要的 caption,代码框、算法框也只需翻译必要的注释,而人名不必翻译;将翻译后的新源码保存到解压目录下名为「paper_cn」的新目录中,要注意保持源码的可编译性;翻译完后要仔细检查一遍,看有没有漏翻译的章节和文件;最后,用 xelatex 将翻译结果重新编译成 pdf,返回生成的 pdf 路径。如果翻译内容较多,应当开启多个 subagent 来并行翻译。」

以 kimi-cli 为例,并不全是为了打广告,而是笔者就只用过 kimi-cli ,这还是因为工作的原因「顺手」测试了一下,而不是主动去寻求的 AI Agent 辅助,足见笔者「老古董」之本质。大家如果有其他用得顺手的 AI agent,也可以自行尝试。

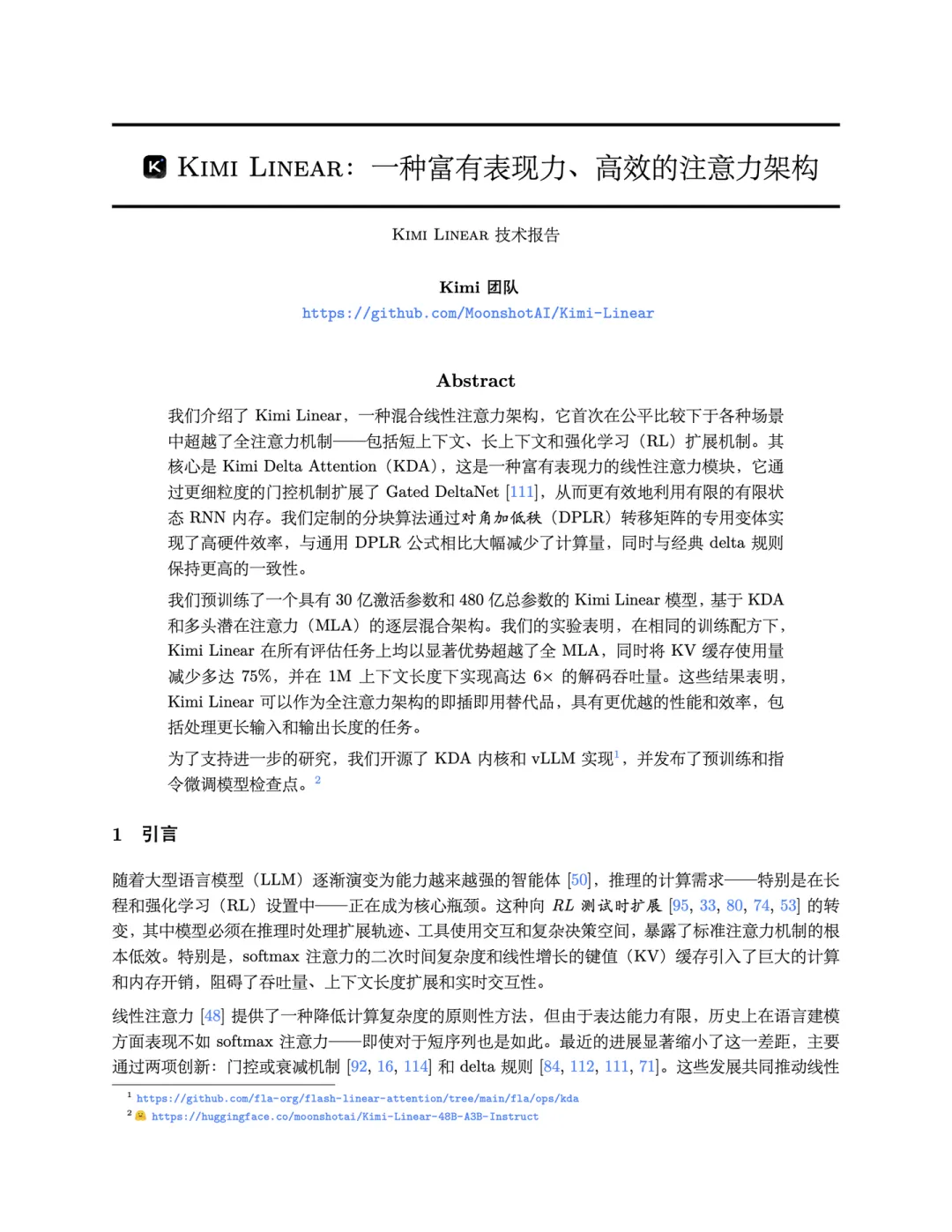

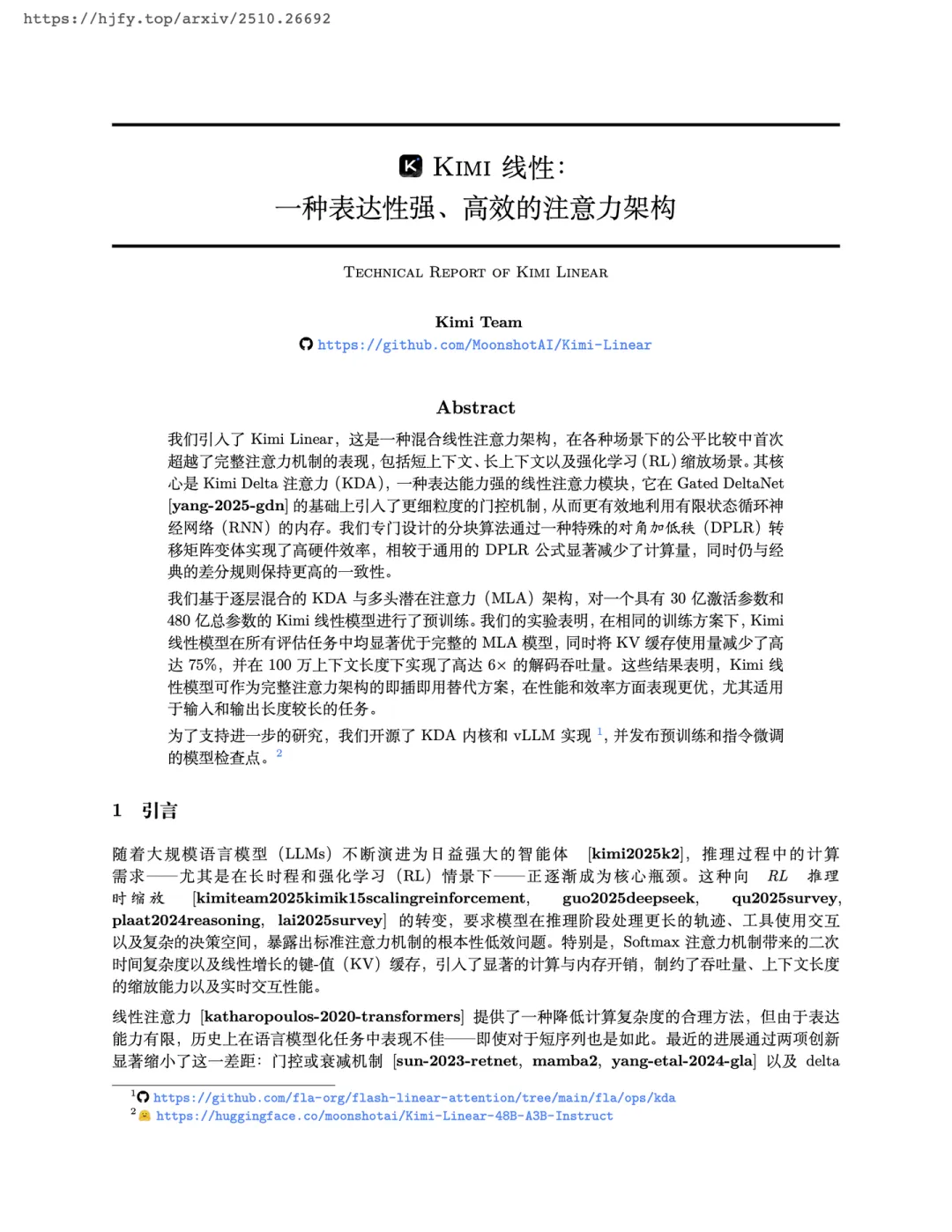

效果对比

市面上已有的论文翻译网站,笔者认为做得最好的是「幻觉翻译(hjfy. top)」:https://hjfy.top

以下是 kimi 和 hjfy 分别对两篇论文进行翻译的结果:

https://kexue.fm/usr/uploads/2026/01/1142758176.pdf

https://kexue.fm/usr/uploads/2026/01/469767516.pdf

https://kexue.fm/usr/uploads/2026/01/1110926489.pdf

https://kexue.fm/usr/uploads/2026/01/3343438015.pdf

大家可以自行对比一下:

多扯几句

关于幻觉翻译的原理,作者曾在他的知乎文章《消耗 3 亿 token,我用大模型翻译了 1 万篇 arXiv 论文》上做过分享。

其实朴素的想法估计大家都能想到,就是从论文的 LaTeX 源码出发(arXiv 论文基本都有提供),抽取需要翻译的段落,逐段进行翻译。

然而,真要去实践的话,我们就会体验到那种「无从下手」的感觉,因为 LaTeX 是一个自由度非常高的语法,甚至于它都不只是一个文档语法,而是隐隐已经成为了一个编程工具,在这个背景下,你要想将「抽取-翻译」人工拆解为有限个步骤,是一件非常困难的事情。如作者所言,他每天仍然针对翻译出错的 bad case 进行修复,这是一个长期的、繁琐的、没完没了的工作。

而这些「不容易人工拆解成可枚举的步骤」的工作,正是 AI Agent 所擅长的!AI 会自动查找和判断要翻译的文件,然后逐一进行翻译,更妙的是,它还会自动去编译,根据错误信息自行调整文档,直到编译通过为止。如果人工写规则,单就处理编译错误信息这一步就有无休止的工作,其本质难度可能不亚于重写一个 LaTeX 编译器,其中艰辛可想而知。

除了自动化外,用 kimi-cli 的另一个好处是翻译质量,相比逐段甚至逐句进行翻译,带有全局的上下文信息 kimi-cli 整体的翻译质量会好上不少。当然,问题也有,那就是大模型的通病——幻觉,具体表现是可能存在漏翻、错翻,漏翻的情况,如果在交互式环境下,是可以反复要求 kimi 检查遗漏之处,直到满意为止,但如果是错翻,那就没什么好办法了。

文章小结

本文给出了用 kimi-cli 翻译 arXiv 论文的一个基本用法,也欢迎大家提供更完善的使用案例。

知友讨论

@吴多益:

666,现在 agent 发展真快啊,一觉醒来发现自己又要被取代了哈哈哈,不过模型幻觉问题还比较严重,尤其是有极为复杂的公式时,模型经常自作主张进行修改,所以我在实现时是直接将这类「不可变」命令都替换成一个简单命令如 \cmd1,翻译完了再替换回来,现在解析问题已经几乎没有了,编译报错还是有 1% 左右,下次我也试试用 kimi cli 帮忙解决一下哈哈哈

作者:

能想像这种方法。但问题是定义不可变也是比较麻烦的,比如一个表格你希望它是不可变的,但表格的caption又希望它应该翻译过来,单这一点就要写不少规则。。

@歪门正道:

大家如果能按照arxiv html能解析的方式写latex就好了,直接在网页端翻译,舒服很多,对照也方便

@强化学徒:

时间和token消耗相比hjfy怎么样

作者:

没算过,归纳成skill我们也在尝试中

阅读更多

速读 OpenAI 翁家翌访谈:为什么 Context 才是人和模型的护城河?🚀 AI 产品扶持计划:

知乎为 AI 产品提供定制宣发支持,了解/报名请戳:知乎「AI 新品非正式发布现场」扶持计划

🚀 知乎 AI 社群:

如果你是泛 AI 爱好者,对 AI 资讯感兴趣,欢迎扫码加入知乎 AI 社群↓,我们将每周送上 AI 周报,不定时发布 AI 活动与 AI 产品测试尝鲜。

知乎AI交流群

让一部分开发者先走起来

🚀 知乎科技账号正式登陆 X:

👉 https://x.com/ZhihuFrontier,聚焦「技术 × 观点」的跨语境对话