AI时代的编程能力两极分化:你在哪一边?

- 2026-02-06 12:05:21

前几天我在调试一个异步爬虫的时候,习惯性地把报错甩给了 Claude。它秒回了一段看起来挺完美的修复代码,我啪一下就粘进去了。结果呢?报错确实没了,但程序运行速度慢得像蜗牛。我盯着那段代码看了半天,愣是没发现它偷偷给我加了个全局锁。

那一刻我突然有点心虚:如果 AI 不在身边,我还能修好这个 bug 吗?

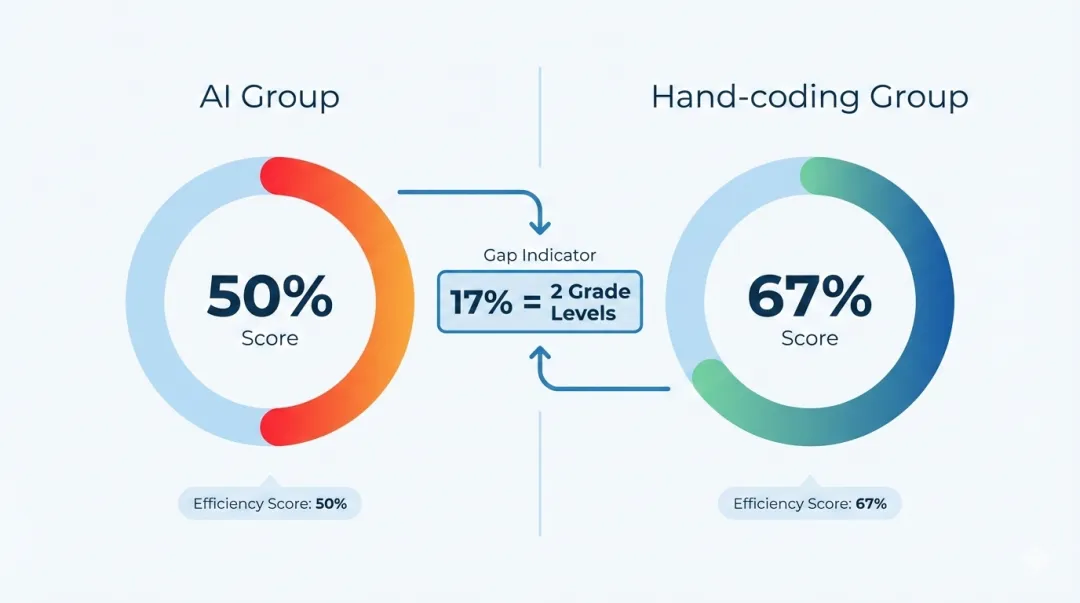

这种“技能焦虑”其实不是我一个人的。最近 Anthropic 专门做了一项研究,找了 52 名资深工程师,让他们学习一个叫 Trio 的 Python 异步库。结果非常扎心:AI 组的测验平均分只有 50%,而全靠手写的对照组拿到了 67%。

这 17% 的差距,在学术上相当于差了整整两个等级。说白了,AI 确实能帮你把活干完,但它也可能在不知不觉中把你“养废”了。

那个 17% 的鸿沟到底是怎么来的?

Anthropic 的这个实验设计得挺有意思。他们把工程师随机分成两组,一组可以用 AI,另一组只能查文档。任务是学习 Trio 库并完成一系列编程挑战。

实验结束后,大家参加了一个“闭卷考试”。结果发现,AI 组在写代码的速度上确实快了一点点,但在理解深度上被手写组甩开了几条街。

最离谱的是调试能力。手写组在遇到 bug 时,能很快定位到是哪个协程没对齐;而 AI 组的同学,很多人盯着报错信息一脸懵逼。我猜是因为他们在写代码的时候,大脑处于“半离线”状态,只负责搬运 AI 的产出,根本没去想底层的逻辑。

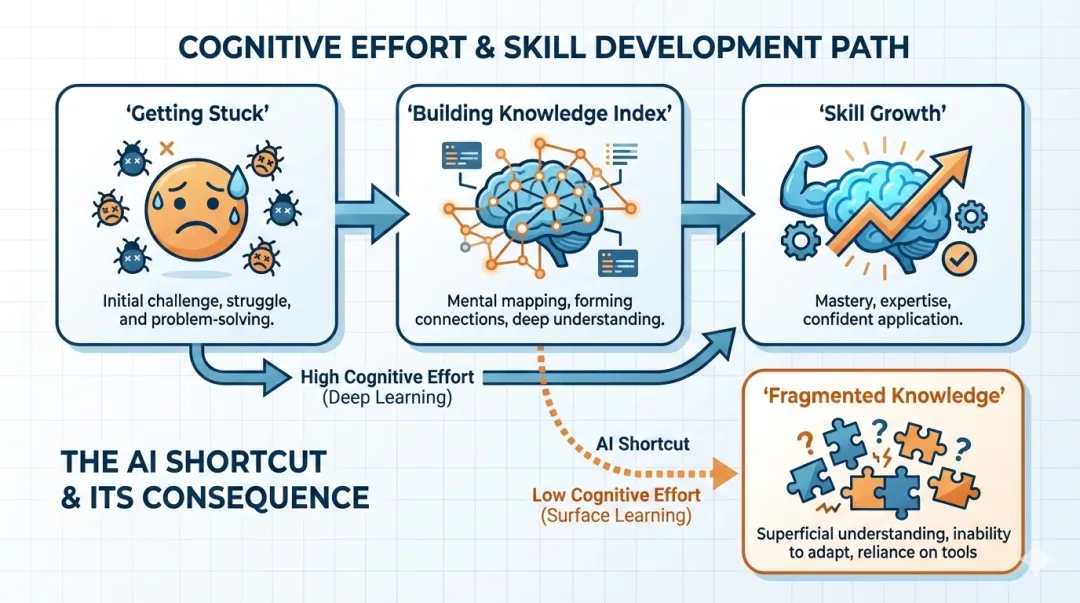

研究员发现,这种差距主要源于“认知努力”的缺失。手写组在被 bug 虐得死去活来的时候,大脑其实在疯狂建立知识索引。而 AI 组因为过程太顺了,大脑觉得“这题我会(AI 会)”,于是就停止了深度思考。

6 种交互模式:你是哪一种?

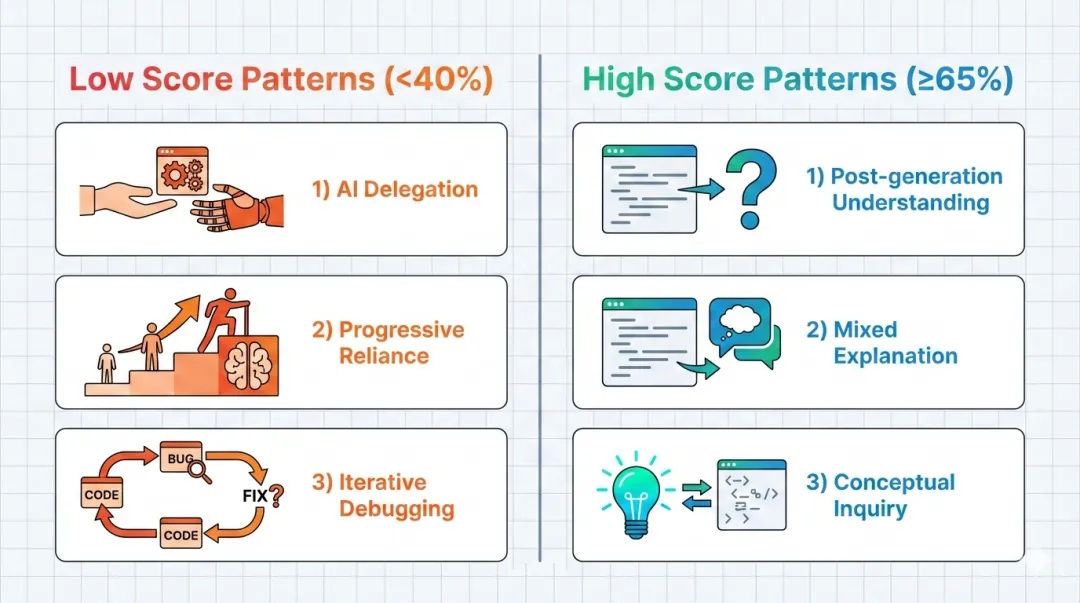

研究人员通过观察发现,同样是调教 AI,不同人的姿势完全不同。他们总结了 6 种模式,直接决定了你是进步还是退步。

先说那些“变废”的低分模式(平均分 < 40%):

AI 委托(AI Delegation):这是最偷懒的。直接把需求扔给 AI,生成了就跑。这种人分数最低,因为他们连代码在干嘛都不知道。 渐进式依赖(Progressive Reliance):刚开始还想自己写,写着写着遇到个坎,就彻底躺平交给 AI 了。 迭代式调试(Iterative Debugging):这种最坑。代码跑不通就喂给 AI 报错,AI 改了再跑,跑不通再喂。整个过程像是在玩“开盲盒”,速度极慢,最后啥也没学会。

再看那些“学会了”的高分模式(平均分 ≥ 65%):

生成后理解(Post-generation Understanding):让 AI 写完,但必须逐行看懂,甚至会反问 AI:“为什么要用这个方法?” 混合解释(Mixed Explanation):要代码的同时,要求 AI 给出详细的逻辑解释。 概念询问(Conceptual Inquiry):这是最高级的。不让 AI 写代码,只问它:“Trio 里的 nursery 概念怎么理解?”然后自己动手写。这种人的分数最高,而且写代码的速度竟然也是最快的。

为什么调试能力成了重灾区?

说实话,我以前觉得 AI 找 bug 挺准的。但研究报告里提到一个细节:AI 组在调试时,往往会陷入一种“局部最优解”的陷阱。

比如 AI 建议你改个变量名修复了当前的报错,但它没告诉你这个改动会破坏整个系统的并发逻辑。手写组因为是一行行抠出来的,他们脑子里有一张完整的“逻辑地图”;而 AI 组脑子里只有一堆碎片。

这就好比你跟着导航开车,虽然能到目的地,但一旦导航断网,你连回家的路都找不着。

别让 AI 成了你的“智力拐杖”

话说回来,我们不可能退回到没有 AI 的时代。关键在于,你怎么把 AI 从“代笔”变成“助教”。

我现在的经验是,遇到新东西,先强迫自己手写 15 分钟。等真的卡住了,再去问 AI 概念,而不是直接要代码。如果非要 AI 生成代码,我也会在心里默念:这段代码现在是我的了,我必须对它的每一行负责。

其实就是那句话:Cognitive effort is important.那些让你感到痛苦、让你抓耳挠腮的时刻,才是你真正变强的时刻。

如果你发现自己最近写代码越来越顺,甚至有点“无脑”了,那可能就是变废的开始。

最后留个问题:你最近一次不靠 AI,独立解决的复杂 bug 是什么?欢迎在评论区聊聊你的“脱敏”经历。

如果您觉得内容对您有帮助,欢迎在看、点赞、分享 ⬇️❤️⬇️

点击下方卡片,关注【前端小石匠】,一起学习,共同进步~

如果您关注前端相关领域,可以扫码添加小编微信进群交流学习~ 🔥近期热文

🔥近期热文