Python GEE | 使用rclone 高效下载 Google Drive 文件:突破文件数限制

- 2026-02-05 01:05:00

点击上方蓝字 关注我们

2026

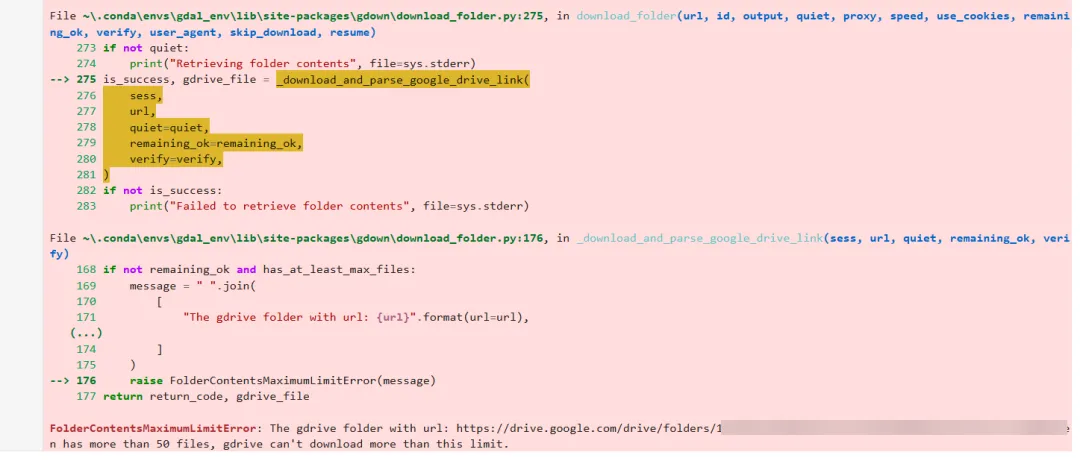

诸位,我们在前文《Python GEE | Google Drive文件下载完全指南:gdown库的工作原理揭秘》提到由于Google Drive在网页端下载时受网络等因素影响较大,且在打包压缩的过程中往往较慢,故在下载Google Drive大文件时可以采用 gdown 来替代网页直接下载,但在今天处理数据的过程中由于下载数据量过大,使用 gdown 时超过了50条文件导致拉取失败,导致网页端或部分接口将无法直接打包下载整个文件夹,相关截图如下:

处理时提示:

FolderContentsMaximumLimitError: The gdrive folder with url:https://drive.google.com/drive/folders/1*************usp=drive_link&hl=en has more than 50 files, gdrive can't download more than this limit.这一限制在科研数据场景中尤为常见,如逐日遥感产品、逐月气象数据或模型批量输出结果,往往包含成百上千个文件。

因此,问题并不在于网络或账号权限,而是 gdown 本身对文件夹下载方式的限制,故针对这一问题rclone 提供了一种稳定、高效、可扩展的解决方案。

Part.01

rclone 是什么?

rclone 是一个开源的命令行工具,可用于在本地计算机与多种云存储服务之间进行高效数据传输,包括 Google Drive、OneDrive、S3、FTP 等。它支持断点续传、自动跳过已存在文件、并行下载以及脚本化调用,尤其适合以下场景:

遥感影像、气象栅格等高频、多文件数据下载

模型逐日、逐月输出结果的批量获取

云端与本地科研计算环境的数据同步

长期科研数据的稳定备份与管理

与网页端、gdown等下载方式相比,rclone 不受文件数量限制,且在数据规模增大时优势愈发明显。

Part.02

正确配置指南(Windows)

这里需要向诸位说明的是,rclone 并非系统自带工具,需要手动下载安装。

Step 1:下载与解压

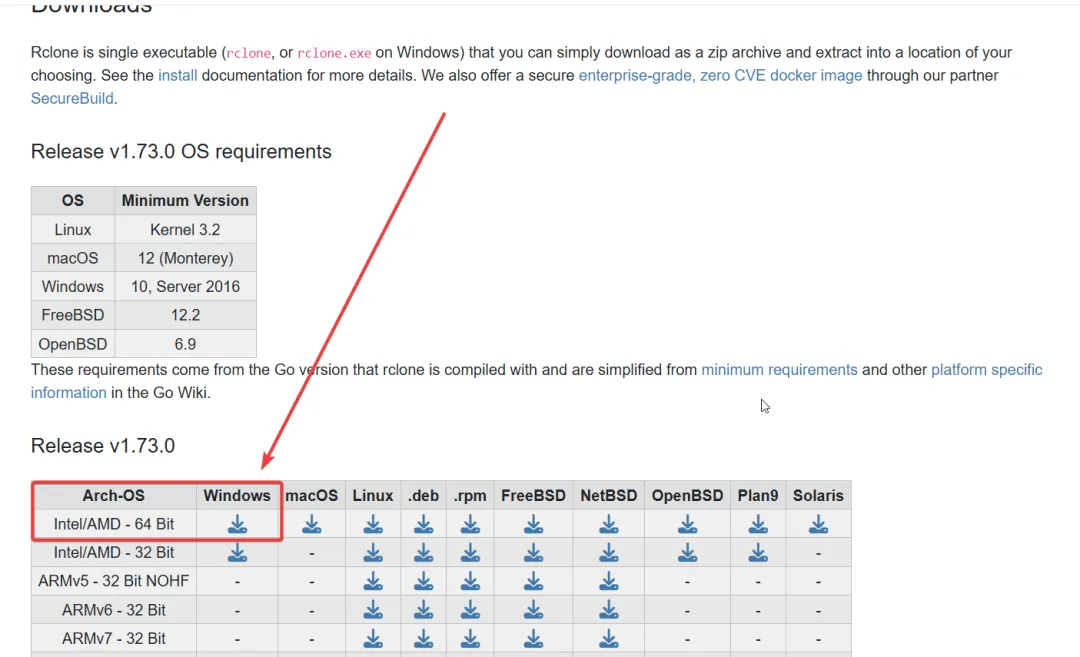

打开官网https://rclone.org/downloads/,在下载页面中,选择 Windows 平台最常见的版本,这里以rclone-v1.73.0为例,这里我们选择64位版本下载,具体如下图:

下载完成后解压,你会看到一个文件rclone.exe。

Step 2:最稳妥的使用方式

这里我将介绍两种使用方式,诸位任选其一即可。

方案A:直接在 rclone.exe 所在目录中使用,假设将 rclone 解压至:D:\APP\rclone,则该目录下存在:D:\APP\rclone\rclone.exe,故只需打开命令提示符(CMD),依次输入:

D:cd D:\APP\rclonerclone config

该方式无需配置环境变量,适合初次接触 rclone 的用户。

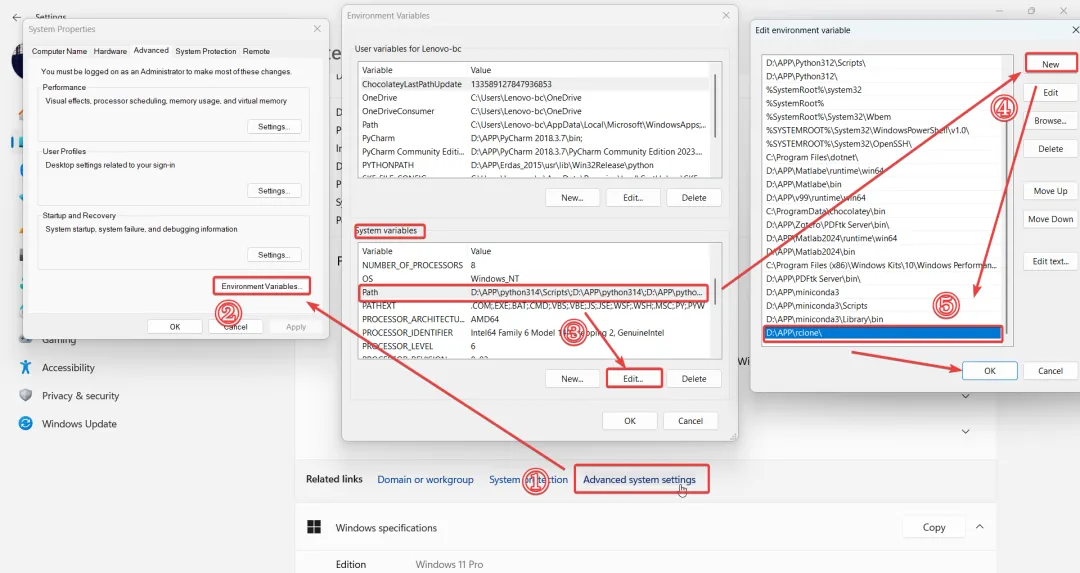

方案B:假设将 rclone 解压至:D:\APP\rclone,则该目录下存在:D:\APP\rclone\rclone.exe,而后我们需要配置一些环境变量,如下操作:此电脑 → 右键 → 属性 → 高级系统设置→ 环境变量,具体步骤如下图所示:

新建系统变量位D:\APP\rclone(这里路径需根据自己存放位置所进行选择),而后点击ok保存配置,关闭所有 CMD 窗口,重新打开 CMD。

Step 3:测试是否成功及使用

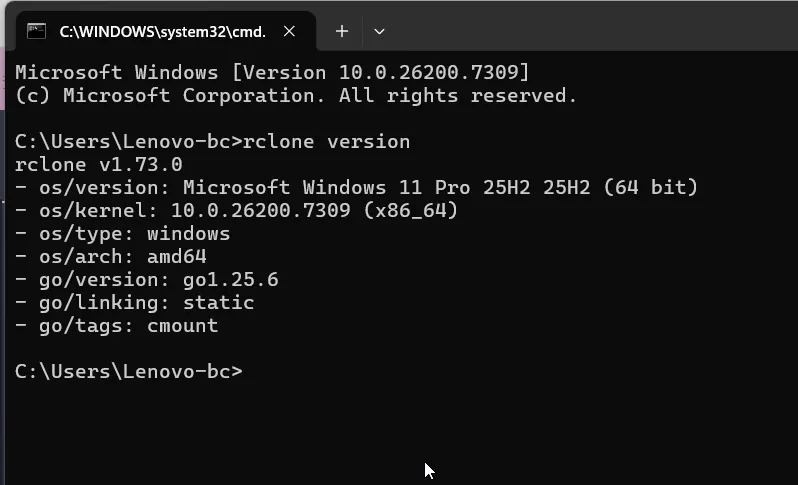

在新打开的CMD窗口输入:

rclone version若显示下图版本号即为配置成功:

PS:接下来的操作内容我们可以使用科学上网,以保证授权及拉取文件时不会受网络影响。

而后我们输入以下命令并回车执行:

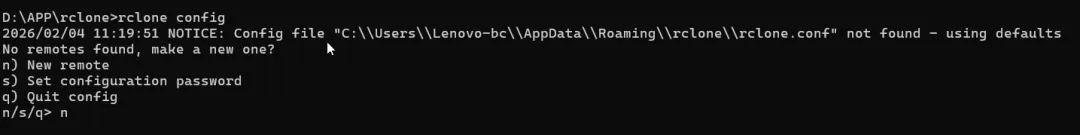

rclone config我们便可以看到如下页面,我们输入n而后新建一个remote,这里我将名称设置为了GoogleDriveDownloda:

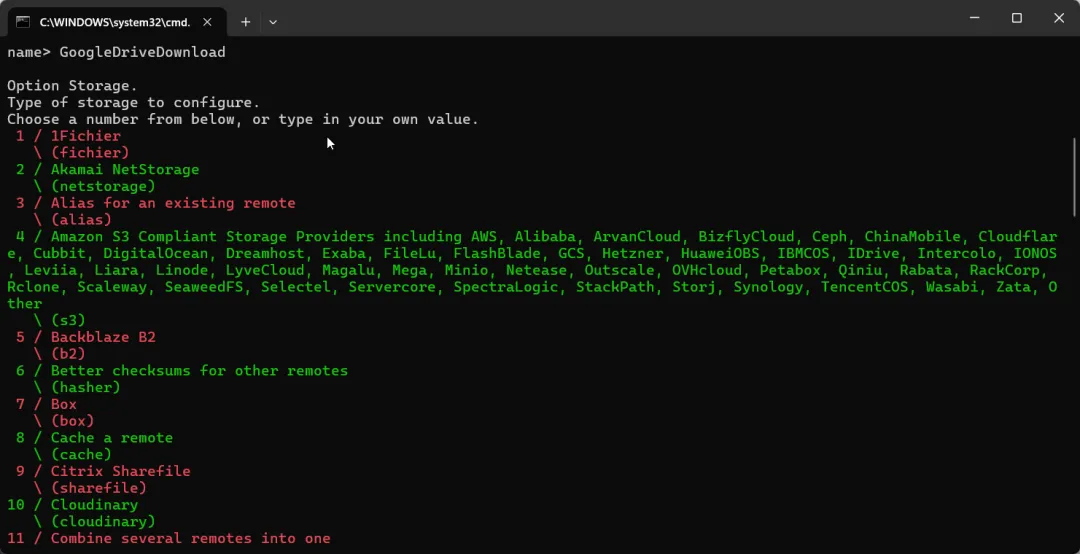

新建完成之后我们便会看到如下页面,我们找到Google Drive,这里是24,我们便输入24,紧接着client_id、client_secret 直接回车:

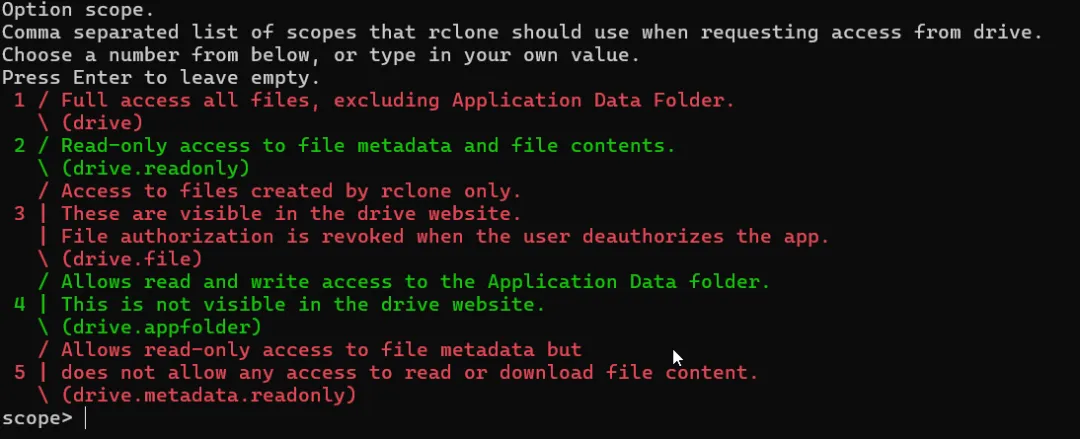

如下页面时我们输入1即可:

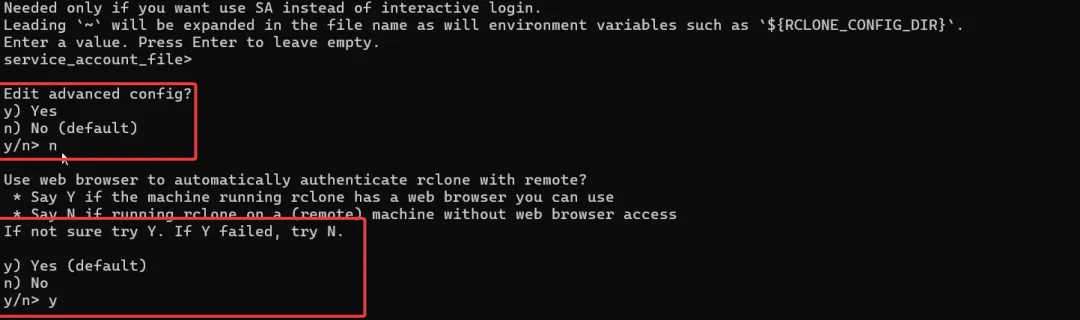

接下来我们回车,根据我下图内容输入即可:

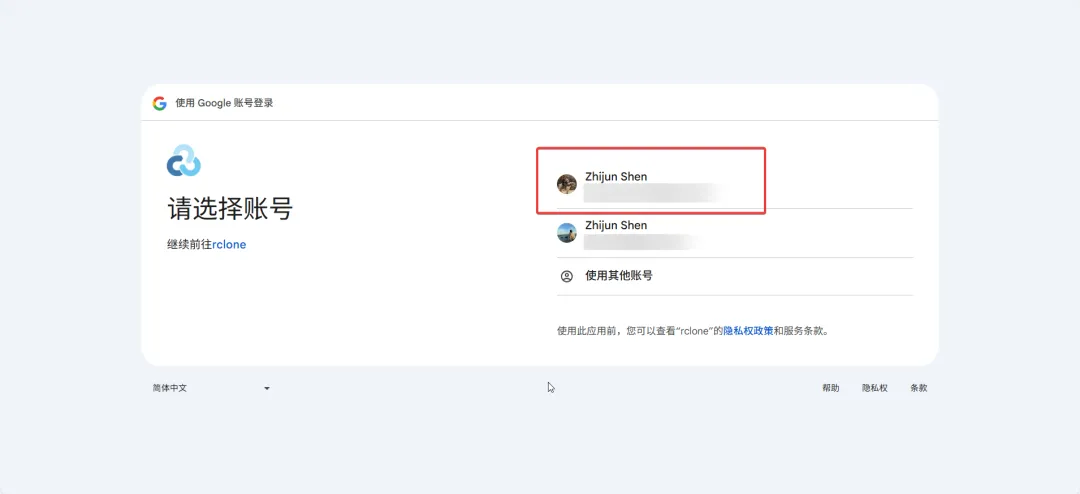

便会弹窗跳转到Google Drive授权页面,如下图,选择对应的Google账号登录授权继续即可:

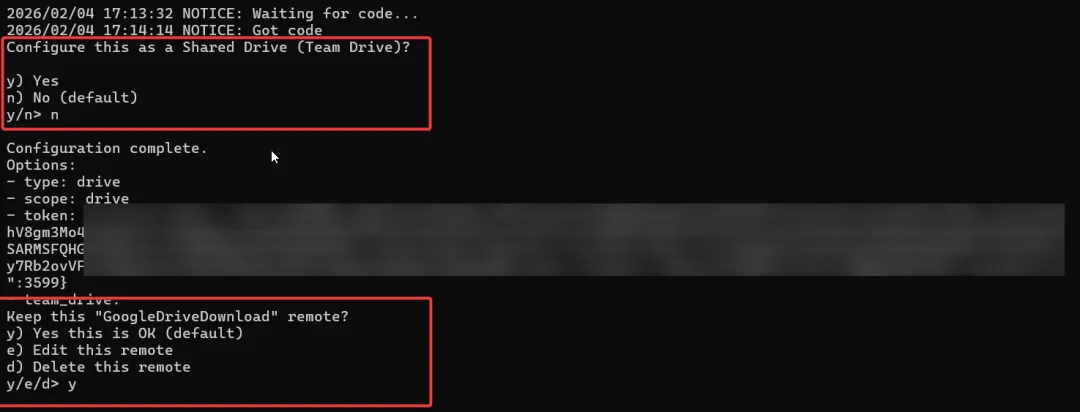

仍旧按我下图的内容输入即可:

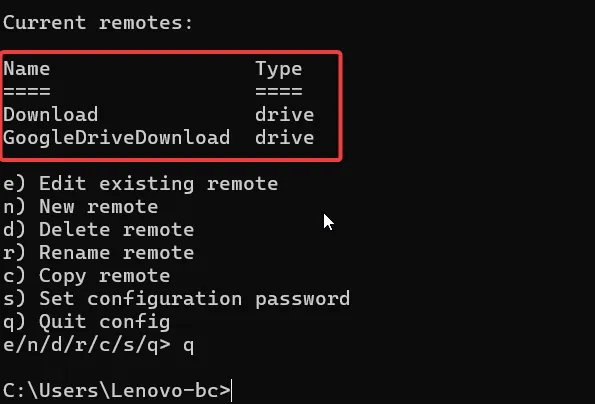

而后诸位便可以看到下图新建的remote,继而输入q即可退出配置环境页面:

至此我们的配置便已完成。

Part.03

正确使用指南(Windows)

诸位,工欲善其事必先利其器,接下来我们便可以使用rclone将Google Drive中文件拉取到本地。

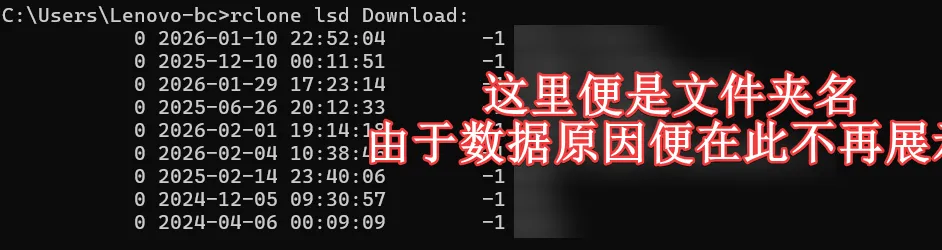

在这里我们可以先介绍一些实用内容,我们在CMD页面输入:

rclone lsd Download:便可以查看 Drive 根目录文件夹。具体如下图所示:

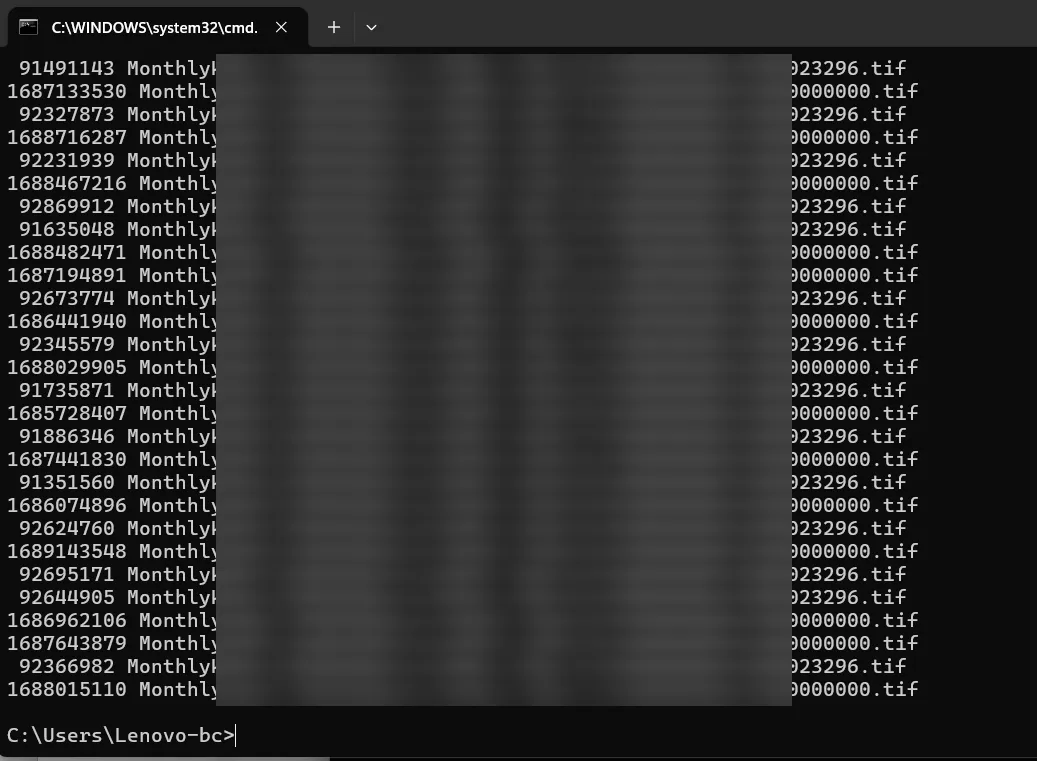

也可以使用如下命令查看查看 Drive 文件列表,具体如图所示,即可列出全部文件:

rclone ls Download:

接下来假设我们要将某个文件夹里的所有内容拉取到本地,我们使用rclone copy即可,例如:

我们的Google Drive 中存在一个包含大量文件的文件夹:DailyNDVI

我们目标是将其完整下载到本地路径:I:\NDVIDaily

即可在CMD中使用以下命令:

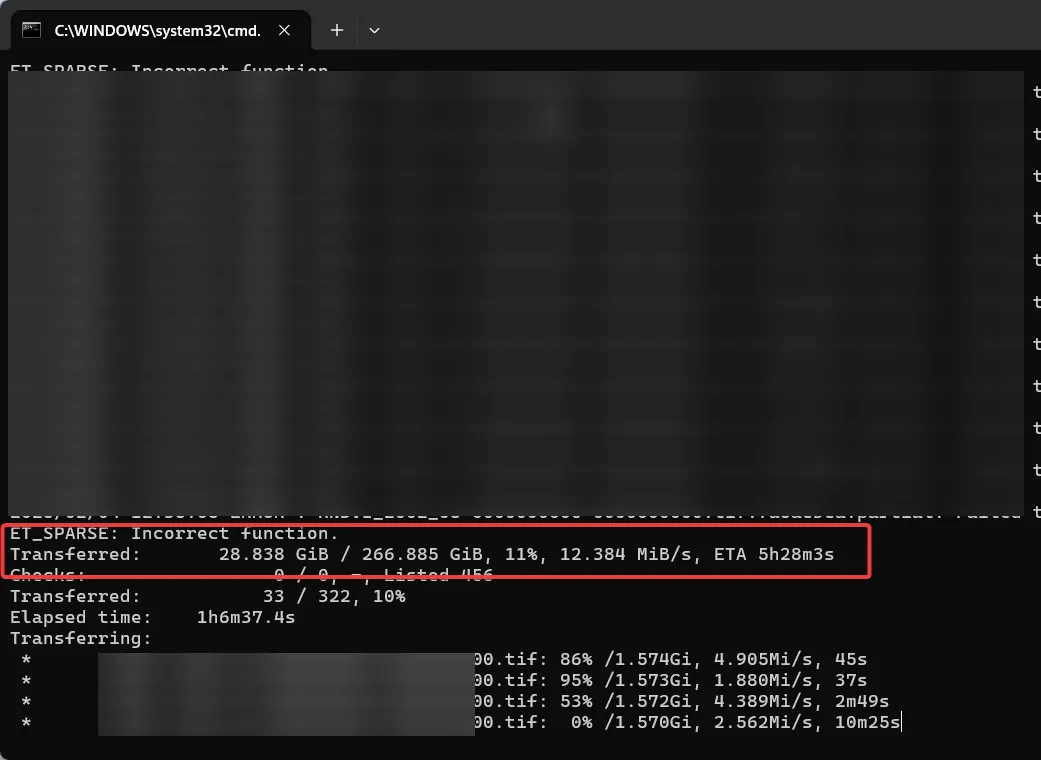

rclone copy "Download:/DailyNDVI" "I:\NDVIDaily" --progress--progress是为了实时显示进度条,该命令会递归下载文件夹内的所有文件和子目录。

具体我们可以看到,实测速率超过10Mb/s:

好了诸位,我们接下来讲一些注意事项:

1)优先使用 rclone copy不会删除本地已有文件,适合科研数据下载和归档

2)谨慎使用 rclone syncsync 会删除本地多余文件,更适合自动化备份

3)支持断点续传下载中断后重新执行命令即可,已完成文件会自动跳过

4)个人用户无需自建 Google API client_id自建client_id较为繁琐,使用默认配置即可满足大多数数据下载需求

当 gdown 因为文件数量限制而频繁报错时,问题往往不在于网络,也不在于操作系统,而是我们还停留在网页端下载这一并不适合研究数据的方式上。像 rclone 这样的工具,本质上并不复杂,但一旦用对了场景,就能在数据获取、管理和复现性上带来非常明显的提升。

如果你在阅读过程中也有类似的感受——原来下载数据这一步,其实可以更稳定、更可控,也更友好,那么欢迎点个关注。后续会持续分享一些偏实用、偏脚本、偏解决具体数据痛点的小工具和用法,例如:

如何用脚本稳定接管 Google Drive、OneDrive 等云端数据源的批量下载

如何把零散的一次性命令,整理成可复用、可迁移的小工具

在不引入复杂框架的前提下,提高批量数据处理与传输的稳定性

不同系统、不同网络环境下,减少踩坑、提高成功率的实战经验

那些看起来不起眼,却能在日常科研中持续节省时间的工具习惯,很多工具和脚本的起点,其实都源自一个很朴素的问题:

这一步,真的还需要每次都手动来一遍吗?

如果你在数据管理过程中也遇到过类似的数据下载、整理或自动化问题,欢迎留言交流,或通过邮箱联系: shenzhijun2024@hotmail.com

你的一个具体困扰,很可能就是下一篇实用工具分享的灵感来源。