当Windows用户还在被强制推送Copilot的时候,Linux世界已经悄然打开了一扇通往AI自由的大门

图1:Newelle - Linux桌面上的开源AI革命先锋

图1:Newelle - Linux桌面上的开源AI革命先锋

Linux桌面的AI觉醒时刻

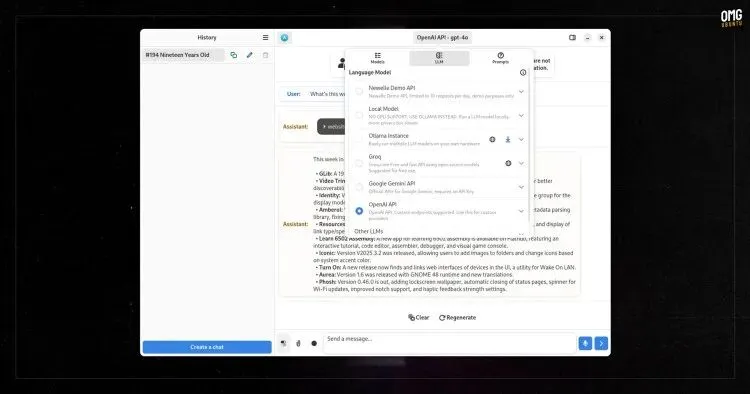

就在2026年1月9日,一个看似平常却意义深远的技术更新在开源社区引发了涟漪:GNOME的第三方AI助手应用Newelle宣布支持Anthropic的Model Context Protocol(MCP)服务器。这个消息对很多人来说可能只是又一次技术升级,但对于Linux用户、开源开发者和技术独立创业者来说,这标志着开源AI生态的一次重大突破。

为什么这么说?让我们先看看背景。在去年8月,Newelle刚刚发布1.0版本的时候,它还只是一个"能用"的AI聊天界面——支持ChatGPT、Gemini、Claude等云端大模型,也支持通过Ollama运行本地模型。这听起来不错,但和市面上很多AI助手相比并没有太大差异。然而,这次加入MCP服务器支持,Newelle一下子从一个简单的聊天工具,升级成了可以连接"成千上万"应用和数据源的AI枢纽。

说到MCP,很多人可能还不太熟悉。这是Anthropic在2024年11月开源的一个协议标准,设计初衷是让AI系统能以统一的方式访问各种外部数据、工具和系统。可以把它理解为AI世界的"USB-C"——一个统一的接口标准,让不同的AI应用能够无缝对接各种数据源和工具,而不需要每次都重新开发专用的连接器。

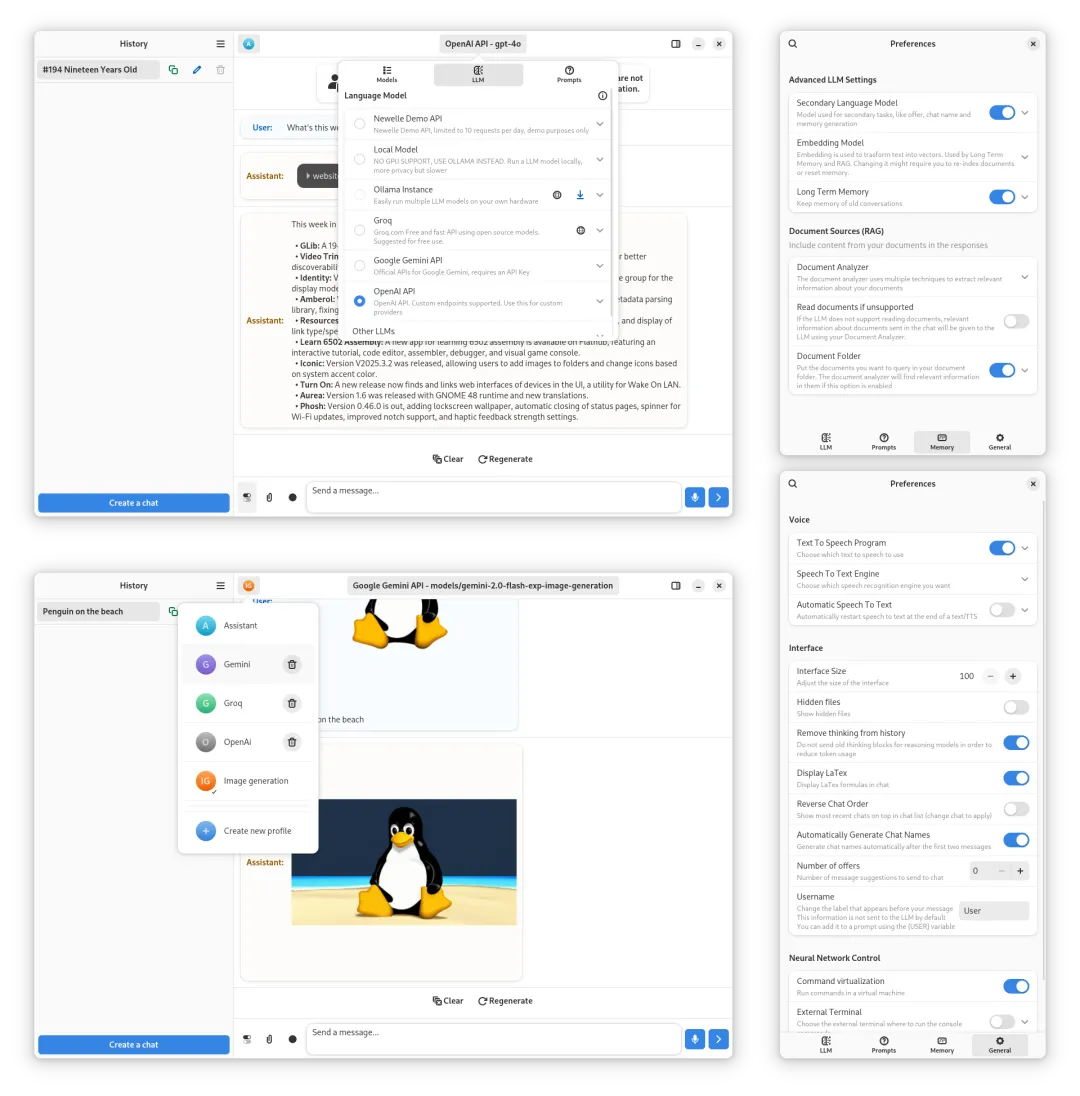

图2:Newelle的现代化GTK4界面,展示了与多个AI模型的交互能力和丰富的扩展系统

图2:Newelle的现代化GTK4界面,展示了与多个AI模型的交互能力和丰富的扩展系统

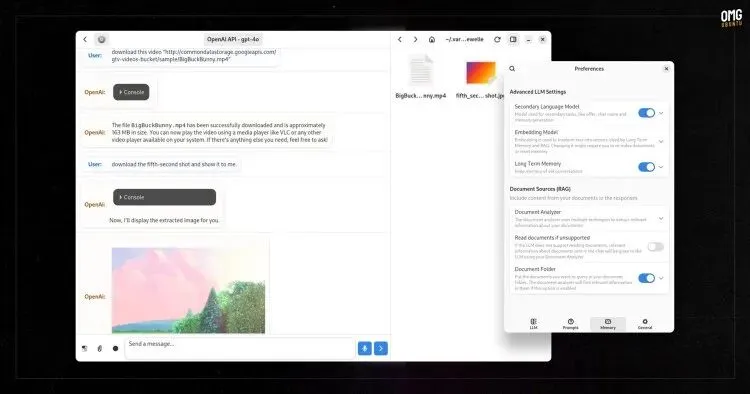

MCP集成:从聊天工具到生产力平台

Newelle加入MCP支持后能做什么?根据官方说明,这意味着它现在可以"连接和整合外部数据、工具和系统,获取实时上下文"。听起来有点抽象,咱们用具体例子来说明。

假设你是一个独立开发者,在用Linux做日常开发工作。以前用AI助手,你可能只能问问代码怎么写、让它解释某个技术概念。但现在有了MCP支持,Newelle理论上可以:

直接访问你的日历,查看今天的会议安排和待办事项;读取你的项目文档和代码仓库,基于实际项目上下文给建议;连接你的开发工具链,自动化一些重复性任务;甚至可以调用各种Web服务的API,帮你完成跨系统的操作。

这背后的关键在于MCP生态系统。目前GitHub上已经有数百个开源的MCP服务器实现,涵盖文件系统访问、数据库查询、Web搜索、日历管理、任务追踪等各个方面。而且这个生态还在快速增长中。Newelle通过支持MCP,等于一下子获得了接入这整个生态的能力。

更有意思的是,Newelle在这次更新中还加入了"Tools"功能,让开发者可以更容易地为它添加新工具。结合MCP的标准化接口,这意味着Linux开发者现在有了一个既灵活又标准化的AI工具平台。你可以根据自己的工作流需求,选择和配置不同的MCP服务器,打造完全个性化的AI助手。

图3:MCP协议的核心概念——将AI与各种数据源和工具连接起来的标准化桥梁

图3:MCP协议的核心概念——将AI与各种数据源和工具连接起来的标准化桥梁

开源的优势:自由、隐私与可控性

说到这里,你可能会问:Windows和macOS上不是也有AI助手吗?Windows有Copilot,macOS有Siri和各种第三方工具,为什么Newelle的MCP支持这么值得关注?

这就要说到开源和闭源生态的根本区别了。微软的Copilot确实功能强大,但它是"强制推送"的——你不想用也得在系统里看到它的图标,而且它的数据处理过程完全是黑盒,你无法知道你的信息是怎么被使用的。苹果的Siri虽然在隐私保护方面做得不错,但同样是封闭生态,你只能用苹果允许你用的功能。

相比之下,Linux上的AI集成是"完全选择性的"。Newelle需要你手动安装和配置,不会自己蹦出来;你可以选择使用云端模型(OpenAI、Anthropic、Google),也可以完全使用本地模型(通过Ollama),数据不出你的机器;更重要的是,整个系统是开源的。Newelle的代码在GitHub上完全公开(GPL-3.0许可证),任何人都可以审查、修改和定制。如果你担心隐私问题,可以自己检查代码;如果某个功能不符合你的需求,可以fork一个版本自己改。

这种透明度和可控性,对独立开发者和技术创业者来说特别重要。你知道你的代码、你的商业秘密不会在你不知情的情况下被发送到某个云端服务器;你可以根据具体项目需求定制AI工具的行为,而不是被迫适应某个大公司设计的工作流。

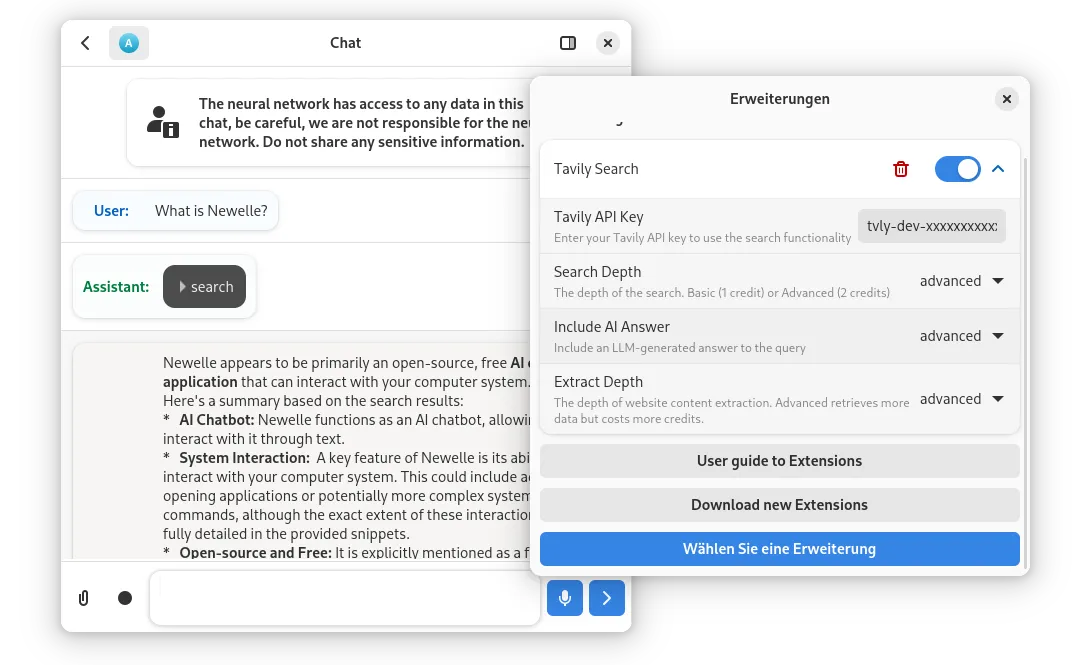

图4:Newelle的扩展系统界面,展示了Tavily搜索等多种可配置的AI工具

图4:Newelle的扩展系统界面,展示了Tavily搜索等多种可配置的AI工具

GNOME MCP Server:更深层的桌面集成

除了Newelle这个第三方应用,开源社区还有一个更底层的项目值得关注:gnome-mcp-server。这是一个用Rust编写的MCP服务器,专门设计用来让AI系统访问和控制GNOME桌面环境。

这个项目的功能列表非常有意思。它允许AI访问:

你的日历事件(可配置查看多久之前和之后的安排);你的任务列表和待办事项;你的联系人信息;以及控制桌面的各种功能,比如发送通知、启动应用、打开文件和URL、管理壁纸、控制音量和媒体播放、截图、窗口管理、甚至调整系统设置(WiFi、蓝牙、夜间模式、深色主题等)。

想象一下这样的场景:你正在写代码,突然想起要确认一下明天的会议时间。以前你可能需要打开日历应用,切换窗口,找到对应日期。现在你可以直接在AI助手里问"明天上午有什么安排",AI通过gnome-mcp-server直接查询你的GNOME日历,给你答案,然后你继续写代码,整个过程可能只需要几秒钟。

或者你在准备一个演示文稿,需要快速调整系统设置——关掉通知、切换到深色模式、把音量调到静音。以前你需要点开设置面板,一个个调整。现在你可以对AI说"进入演示模式",让它通过MCP服务器一次性帮你完成所有设置。

更重要的是,gnome-mcp-server支持三个层级的配置文件:当前目录的./gnome-mcp-config.json、用户级的~/.config/gnome-mcp/config.json、以及系统级的/etc/gnome-mcp/config.json。这意味着你可以为不同的项目、不同的用户、甚至整个系统设置不同的AI访问权限。比如在工作项目里,你可能允许AI访问日历和任务,但在个人项目里,你可能只允许它控制窗口和截图。

图5:Newelle的聊天界面展示了与多个AI模型的无缝切换能力

图5:Newelle的聊天界面展示了与多个AI模型的无缝切换能力

对开源开发者和独立创业者的实际价值

说了这么多技术细节,咱们回到最实际的问题:这些对你有什么用?

如果你是一个开源开发者,Newelle + MCP的组合给你提供了一个完全开放的AI工具链。你可以:

本地化部署:通过Ollama运行本地大模型,配合本地的MCP服务器,打造一个完全不依赖云端的AI工作环境。对于处理敏感数据或在网络受限环境下工作的开发者来说,这非常有价值。

定制化工作流:根据自己的开发习惯,选择和配置不同的MCP服务器。比如连接GitHub的MCP服务器来管理代码仓库,连接PostgreSQL的MCP服务器来查询数据库,连接Jira的MCP服务器来跟踪任务,然后让AI助手在这些系统之间协调工作。

学习和贡献:Newelle和gnome-mcp-server的代码都是开源的,你可以通过阅读它们的实现来学习MCP协议,甚至贡献你自己的改进。这对提升技术能力和在开源社区建立影响力都很有帮助。

如果你是一个独立创业者或数字游民,这套工具链的价值在于:

成本优势:Newelle本身是免费的,MCP服务器也多数是开源的。你可以先用本地模型测试和开发,等到真正需要云端模型的强大能力时再付费使用。相比订阅多个商业AI服务,这能省下不少钱。

隐私保护:如果你的业务涉及客户数据或商业机密,使用开源的本地AI工具可以大大降低数据泄露风险。你不需要担心某个云端服务的隐私政策变更,或者数据被用于训练其他公司的模型。

可移植性:Linux + 开源工具的组合,意味着你的工作环境可以很容易地在不同机器之间迁移。在咖啡馆用笔记本工作?在Airbnb用台式机?在联合办公空间用别人的电脑?只要装上Linux,克隆你的配置文件,就能快速恢复整个工作环境。

图6:Newelle的详细设置界面,展示了丰富的自定义选项和扩展管理功能

图6:Newelle的详细设置界面,展示了丰富的自定义选项和扩展管理功能

如何在Linux上配置和使用

好了,理论说得够多了,咱们来点实际的。如果你想在自己的Linux机器上试试Newelle,步骤其实很简单。

第一步:安装Newelle

最简单的方法是通过Flathub安装。在终端运行:

flatpak install flathub io.github.qwersyk.Newelle

如果你的系统还没有配置Flathub,需要先添加Flathub仓库。具体步骤可以参考Flathub的官方文档。

第二步:配置AI模型

首次启动Newelle时,它会提示你配置AI模型。你有几个选择:

使用云端模型:如果你有OpenAI、Anthropic或Google的API密钥,可以在设置里输入。Newelle支持这些主流的云端AI服务。

使用本地模型:如果你想保护隐私或离线工作,可以先安装Ollama(一个开源的本地大模型运行工具),然后在Newelle里选择连接到本地的Ollama实例。

使用演示模型:Newelle提供了一个免费的演示模型,但限制为每天10次对话。适合初次尝试,但不适合日常使用。

第三步:探索MCP服务器

这是最有趣的部分。要让Newelle使用MCP服务器,你需要:

选择你需要的MCP服务器:GitHub上有一个awesome-mcp-servers列表,收集了各种开源的MCP服务器实现。比如文件系统访问、GitHub集成、Google Drive、Slack等等。

配置MCP服务器:大多数MCP服务器都有详细的README,说明如何安装和配置。通常你需要克隆代码,安装依赖,然后运行服务器。

在Newelle里连接MCP服务器:在Newelle的扩展设置里,你可以添加新的MCP服务器连接。输入服务器的地址和端口,Newelle就能开始使用它提供的工具和数据了。

第四步:个性化定制

Newelle支持很多自定义选项。你可以:

设置快捷键(比如快速打开mini窗口模式);配置语音功能(语音转文字和文字转语音);安装各种扩展(比如图像生成、文档分析等);调整界面主题和字体大小。

这些设置都在Newelle的Preferences菜单里,花点时间探索一下,你会发现很多提升效率的小功能。

图7:MCP协议的核心理念——连接AI与关键上下文的标准化桥梁

图7:MCP协议的核心理念——连接AI与关键上下文的标准化桥梁

开源AI生态的未来展望

Newelle加入MCP支持,只是Linux桌面AI革命的一个开始。如果我们把视野放宽一点,会发现整个开源AI生态正在经历一次重要的转型。

过去,Linux上的AI工具往往是"技术演示"级别的——能用,但体验和功能都不如商业产品。但现在情况在改变。Newelle的1.0版本已经相当成熟,界面是现代化的GTK4 + libadwaita设计,功能涵盖语音聊天、终端命令执行、文档分析、网页搜索等等,完全可以作为日常工具使用。

更重要的是,开源社区正在形成一个"标准化"的AI生态。MCP协议的出现,让不同的AI应用和数据源之间可以无缝对接,避免了以前那种"每个工具都要重新实现一遍连接器"的混乱局面。这种标准化对开源生态特别重要,因为它让小团队和个人开发者也能参与进来——你不需要从零开始构建整个AI系统,只需要实现一个MCP服务器,就能被所有支持MCP的客户端使用。

从更宏观的角度看,Linux桌面的AI集成体现了一种"自下而上"的创新模式。没有哪个大公司在推动这个进程,也没有强制性的产品路线图。一切都是开发者根据实际需求,用开源的方式逐步构建起来的。这种模式虽然发展得慢一些,但往往更符合真实用户的需求,也更尊重用户的选择权。

对于独立开发者和技术创业者来说,这个趋势意味着什么?意味着你现在有机会在一个相对平等的竞技场上创新。Windows和macOS上的AI工具虽然成熟,但门槛也高——要么你接受大公司的规则,要么你需要巨额投资来开发自己的生态。而在Linux + 开源的世界里,你可以站在现有工具的肩膀上,用很小的成本快速试验新想法。

比如说,你可以基于Newelle和MCP,为特定行业(比如数据分析、内容创作、客户服务)开发专门的AI工作流。你不需要从头开发AI模型,也不需要重新实现桌面集成,只需要选择合适的MCP服务器,编写一些配置和脚本,就能打造一个针对特定场景高度优化的AI助手。如果这个方案有价值,你可以把它开源出来,让更多人受益,同时也建立自己在社区的声誉。或者你可以基于这个方案提供付费的定制服务或培训。

给Linux用户的实用建议

如果你现在就想尝试Newelle和MCP,这里有几个实用建议:

从本地模型开始:虽然云端模型很强大,但我建议先试试本地模型(通过Ollama)。这样你可以在不花钱的情况下熟悉工具,而且数据完全在本地,不用担心隐私问题。等你真正需要GPT-4或Claude的能力时,再考虑使用云端API。

选择适合你工作流的MCP服务器:不要贪多,一开始选2-3个你真正需要的MCP服务器就够了。比如如果你经常需要查阅文档,可以试试文件系统相关的MCP服务器;如果你的工作涉及很多Web搜索,可以试试搜索相关的服务器。等熟悉了再逐步添加更多。

参与社区讨论:Newelle的开发者在GitHub上很活跃,社区也在形成。如果你遇到问题或有功能建议,不妨去GitHub Issues里看看,或者发起一个讨论。开源项目的一个好处就是开发者和用户之间的距离很近,你的反馈真的有可能影响工具的发展方向。

关注GNOME的AI集成计划:除了Newelle这样的第三方应用,GNOME项目本身也在考虑更深层的AI集成。Red Hat之前宣布计划在Fedora和GNOME中加入AI功能,虽然具体细节还不清楚,但这意味着未来Linux桌面的AI能力可能会更加原生和完善。

别忘了安全性:虽然开源工具通常比较安全,但你仍然需要注意。如果你使用云端API,确保API密钥的安全存储;如果你连接MCP服务器到敏感数据源(比如公司的数据库),仔细检查服务器的权限配置,避免过度授权。

最后,如果你觉得Newelle或MCP这个方向有意思,不妨试着贡献代码或文档。开源项目永远欢迎新的贡献者,哪怕只是修正一个小bug或改进一段文档,都能帮助整个社区发展得更好。而且从个人发展的角度,参与知名开源项目是建立技术声誉和职业网络的绝佳途径。

结语:开源的AI未来,由你定义

Newelle加入MCP支持,标志着Linux桌面AI生态迈出了重要一步。这不仅仅是一个技术更新,更是一种理念的体现——AI工具应该是开放的、可控的、尊重用户选择的。

在Windows和macOS用户还在被动接受大公司设计的AI功能时,Linux用户已经可以根据自己的需求,自由地组合和定制AI工具。这种自由不是凭空而来的,而是建立在开源社区多年积累的基础之上——从Linux内核到GNOME桌面,从Python到Rust,从Ollama到MCP,每一个环节都是开源协作的成果。

对于独立开发者、技术创业者和数字游民来说,这个开放的AI生态提供了独特的机会。你不需要巨额投资或大团队,就能利用最前沿的AI技术来提升工作效率、开发创新产品、或者探索新的商业模式。你所需要的,只是一台运行Linux的电脑,一些时间来学习和试验,以及对开源理念的认同。

Linux桌面的AI革命才刚刚开始。Newelle和MCP只是第一波,未来还会有更多工具、更多可能性涌现。而这个未来怎么发展,很大程度上取决于像你这样的用户和开发者——你的需求、你的贡献、你的创新。

所以,准备好加入这场革命了吗?去试试Newelle,探索MCP的可能性,然后告诉社区你的体验和想法。Linux桌面的AI未来,由你定义。

免责声明:本文由AI基于真实新闻来源和公开技术文档生成,内容仅供参考。技术细节和功能可能随软件更新而变化,建议访问官方GitHub仓库和文档获取最新信息。

信息来源:

- AI Assistant App For GNOME Adds MCP Server Support - Phoronix[1]

- Newelle GitHub Repository[2]

- GNOME MCP Server GitHub Repository[3]

- Model Context Protocol Documentation[4]

- Anthropic MCP Announcement[5]

- Newelle 1.0 Release - OMG! Ubuntu[6]

- GNOME's Newelle AI Assistant - XDA Developers[7]

更新时间:2026年1月10日

引用链接

[1]AI Assistant App For GNOME Adds MCP Server Support - Phoronix: https://www.phoronix.com/news/GNOME-AI-Newelle-MCP-Server

[2]Newelle GitHub Repository: https://github.com/qwersyk/Newelle

[3]GNOME MCP Server GitHub Repository: https://github.com/bilelmoussaoui/gnome-mcp-server

[4]Model Context Protocol Documentation: https://modelcontextprotocol.io/docs/learn/architecture

[5]Anthropic MCP Announcement: https://www.anthropic.com/news/model-context-protocol

[6]Newelle 1.0 Release - OMG! Ubuntu: https://www.omgubuntu.co.uk/2025/08/newelle-ai-assistant-ubuntu-linux-desktop

[7]GNOME's Newelle AI Assistant - XDA Developers: https://www.xda-developers.com/linuxs-gnome-based-ai-assistant-released/