✦Redis 之父 antirez 上周发了篇博客,标题很直接:别被反 AI 的炒作蒙蔽了。

他说,用 Claude Code 改 linenoise 库支持 UTF-8、修 Redis 测试的瞬态故障、写一个纯 C 的 BERT 推理库——原本要几周的活,现在几小时搞定。"自己写代码已经不再明智,除非是为了娱乐。"

通俗易懂的说:AI 编程已经从"能用"变成了"不用就是傻"。

Salvatore Sanfilippo,(antirez 是他的网名)是Redis的作者和早期核心贡献者,是定义过一代基础设施的人。

无独有偶,Google的工程师Jaana Dogan在X上发了一条推文Claude Code,一个小时生成了他们团队折腾一年才搞出来的东西。

✦但问题来了

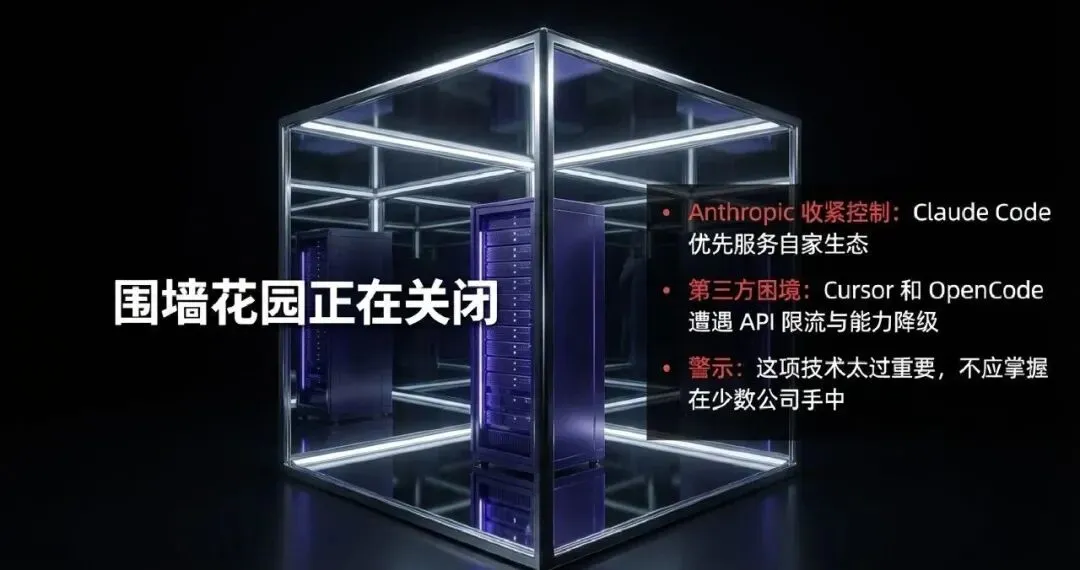

就在 AI 编程工具越来越香的时候,Anthropic 开始收紧口子了。

最近几个月,Claude 对第三方工具的态度越来越微妙。Cursor、OpenCode 这些依赖 Claude API 的编程工具,陆续遇到了各种限制——要么是 rate limit 收紧,要么是某些能力被"优化"掉了。

Anthropic 的逻辑很清楚:Claude Code 是亲儿子,第三方工具?你们自己看着办吧。

恰如 antirez 在文章里说的那句话:

"这项技术太过重要,不应掌握在少数公司手中。"

讽刺的是,他用来举例的工具,正是那个正在走向封闭的 Claude。

✦但还有一个选择:DeepSeek-V4

最近 DeepSeek 干了件有意思的事。

R1 论文发布快一年了,团队突然往里塞了 64 页新内容。没有任何预告,还是网友自己发现的。

信息密度这么高的材料,居然只是拿来给一篇旧论文"打补丁"。要知道,大多数期刊论文发完就算数了,后续要补也顶多是个勘误说明。

这些技术细节,是原本就有只是当时不方便公开,还是团队为了解答大家的疑问索性写了份"说明书"?不管答案是哪个,如此细致的工程披露,又把 R1 的可复现性往前推了一大步。

但从时间点来看,更耐人寻味。

DeepSeek 给 R1 收尾了,说明他们可能已经做出了更前沿的东西。

这个新闻消息主要来源于 The Information。

该媒体长期被视为高可信度的信息源之一。

它最新爆料就称:DeepSeek 预计将在未来几周发布下一代模型 DeepSeek-V4,并将重点强化代码能力;

而且重点是在公司内部基准测试中

V4 在编码任务上的表现已超过 Anthropic 的 Claude 以及 OpenAI 的 GPT 系列现有模型

这也是我凌晨 1 点爬起来写这篇文章的原因——要知道 DeepSeek 每一次发论文,都在推动整个行业往前走一大步。

不妨让我们把视角拉回 2025 年,看看 DeepSeek 在过去一年里到底干了些什么。

✦2025,DeepSeek 炸翻了整个 AI 圈

就在硅谷巨头忙着建护城河的时候,DeepSeek 在干嘛?

疯狂发论文、开源模型、把整个行业的价格体系打穿。

1 月:R1 发布,"开源 o1 时刻"

DeepSeek-R1 一出,直接把 OpenAI 的 o1 拉下神坛。

这玩意儿用纯强化学习训练,没喂任何人类标注的思维链数据,模型自己学会了"自言自语"——分步推理、自我验证、发现错误还会回溯修正。

更离谱的是蒸馏模型。R1-Distill-Qwen-32B 在数学任务上直接干翻了 o1-mini。一个 32B 的模型,消费级显卡就能跑。

英伟达股价当天跌了 17%。

2 月:登上 Nature,学术界认证

DeepSeek-R1 的论文被 Nature 正式收录。

这是第一篇由中国 AI 初创公司主导、经同行评审发表在 Nature 上的大模型论文。学术界用最高规格的认可告诉所有人:这条技术路线是对的。

黄仁勋说"省了 100 倍成本",到底省在哪?

老黄在各种场合反复提 DeepSeek,说它帮全球 AI 行业省了 100 倍成本。

这话听着夸张,但拆开看还真不是吹的:

MLA(多头潜在注意力):把 KV Cache 压缩了 93%。原本 128K 上下文要吃掉几百 GB 显存,现在塞进单卡没问题。显存省了,卡就省了,钱就省了。

MoE + 细粒度专家:671B 总参数,但每个 token 只激活 37B。你买的是 671B 的智商,付的是 37B 的电费。

FP8 混合精度训练:业界第一个大规模用 FP8 训千亿模型的。计算速度翻倍,显存占用减半。

GRPO 算法:强化学习不需要 Critic 模型了,显存直接省一半,训练还更稳。

这些技术叠加起来,DeepSeek-V3 的训练成本是 560 万美元。GPT-4?保守估计 1 亿美元起。

同样的智能水平,成本差了 20 倍。如果算上推理侧的优化,100 倍真不夸张。

✦封锁越来越紧,但门没关死

2025 年的 AI 圈,封闭化已经是明牌了:

- • OpenAI 限制中国、香港地区访问 ChatGPT

对于很多开发者来说,连模型都用不上了。

但 DeepSeek 把另一扇门踹开了。

权重开源、本地部署、Ollama 一键跑。你的数据不出本地,你的模型不看任何人脸色。

这才是真正的"AI 民主化"。

✦DeepSeek 和 Claude,其实很像

说个有意思的事:DeepSeek 和 Anthropic 其实都是技术和概念的先行者。

Anthropic 搞出了什么?MCP(Model Context Protocol)、Skill、Claude Code、Computer Use。每一个都是在定义 AI 应用的新范式。

“DeepSeek 搞出了什么?MLA、DeepSeekMoE、GRPO、DSA(稀疏注意力)。这些工作分别从注意力机制、MoE 结构与强化学习优化等方向提出了有影响力的改进,推动了大模型底层架构与训练范式的演进

区别在于:Anthropic 越来越强闭源,模型收的越来越紧,DeepSeek 的创新是开源的。

这就是为什么我觉得 DeepSeek 可能真的会改变格局——它在用开源的方式,做 Anthropic 级别的创新。

✦V4 会带来什么?

结合 DeepSeek 之前的节奏:

- • V2 搞定了 MLA 和 MoE,推理成本砍了一个数量级

- • V3 搞定了 FP8 训练,训练成本砍了一个数量级

- • R1 搞定了纯 RL 推理,让小模型也能"思考"

- • V3.2 搞定了 DSA,大多数公开基础测试已经超越了 GPT-5 这是没有工具调用的.如果把工具调用纳入系统设计,并配合系统性的后训练与评测闭环迭代,理论上以持续做出比 GPT-5 更强的模型

每一篇论文都是实打实的技术突破,每一次发布都让行业重新定价。

V4 如果真的在长上下文代码生成上突破,Claude 在编程领域的护城河就真的危险了。

想想看:一个开源的、本地可跑的、能处理整个代码仓库的模型。

谁还需要看谁的脸色?

✦为什么 DeepSeek 值得关注

antirez 还提到一个有意思的观察:

"开源模型,尤其是中国开发的模型,仍在与封闭实验室的前沿模型竞争。"

他说的就是 DeepSeek。

你不用看任何公司的脸色。模型在你自己的机器上,数据不出本地,想怎么用怎么用。

假如DeepSeek V4的工程与编程能力确实和爆料一样那么优秀

那么最先被击穿的,将是应用与软件开发的门槛。

SaaS、内部系统、定制化开发,将不再高度依赖庞大的初级工程师团队。能力被模型吸收,效率被系统放大。

中国软件产品从构想到落地的周期,会进一步压缩

并且它代表的高效模型路径,使端侧部署第一次具备现实可行性

✦写在最后

antirez 说得对:AI 编程的乐趣从未消逝,只是换了一种形式。

但他可能没想到,他最依赖的工具正在关上大门。

好在,门外还有人在造新的钥匙。

而且这把钥匙,可能比原来那扇门还好使。

✦

✦我是木乔,致力于把 AI 调教成"全自动打工仔"的开发者和产品经理。

关注我,一起探索让 AI 更懂你的方式。

✦引用来源

| | |

|---|

| Don't fall into the anti-AI hype | https://antirez.com/news/158 |

| | https://www.nature.com/articles/s41586-025-09422-z |

| | https://arxiv.org/abs/2412.19437 |

| | https://arxiv.org/abs/2501.12948 |

| | https://modelcontextprotocol.io |