[IEEE Trans论文代码]- 打破割裂!深度强化学习统一新能源竞价与储能套利 / 误差补偿策略

- 2026-02-03 11:04:53

Deep Reinforcement Learning Based Real-Time Renewable Energy Bidding With Battery Control

基于深度强化学习的实时新能源竞价与储能控制策略

【1】问题背景

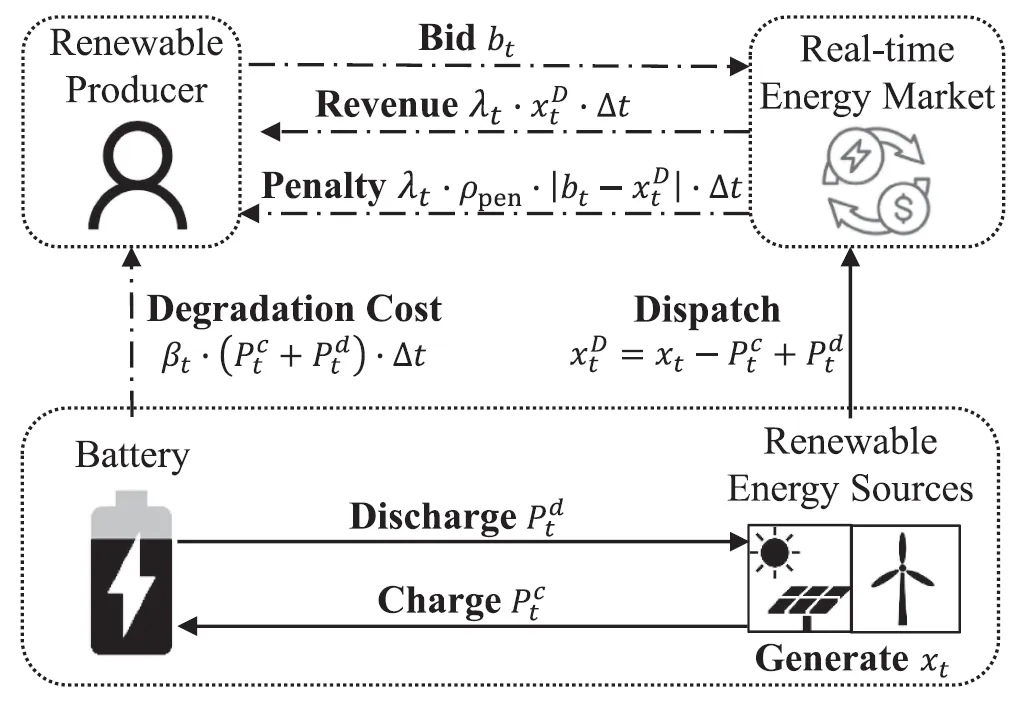

竞价与储能控制割裂:传统研究将二者分开优化,忽略协同效应,难以最大化新能源运营商总利润。

双重不确定性挑战:风光出力波动大、实时电价随机,传统方法难以精准建模,导致偏差惩罚高或套利收益低。

计算效率瓶颈:随机优化等传统方法需大量场景模拟,每时段计算耗时数分钟,无法满足实时市场竞价时效要求。

储能利用不充分:现有策略仅单一关注误差补偿或能量套利,未充分发挥储能的双向赋能潜力。

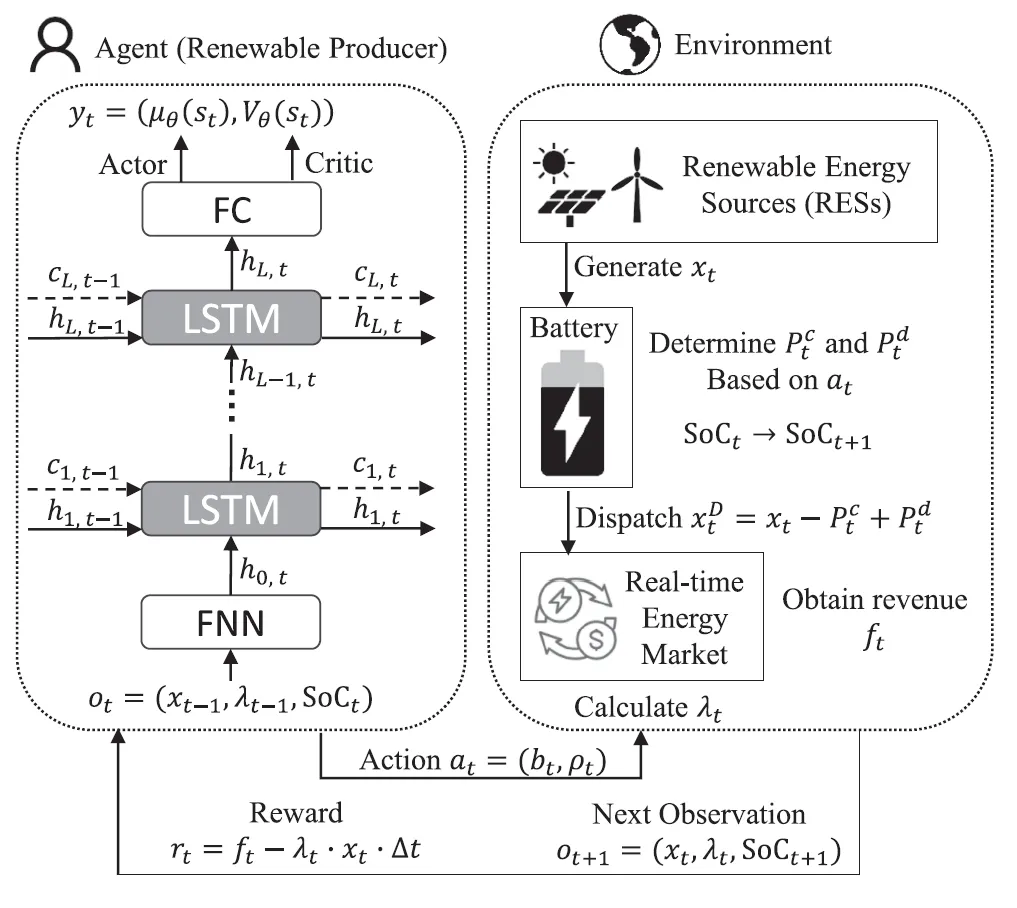

【2】方法与技术路线概述以 “感知 - 决策 - 反馈” 的 DRL 闭环为核心,构建 DeepBid 统一框架:

状态感知:采集历史风光出力、电价及当前电池 SoC 作为观测输入;

决策输出:通过 LSTM 网络 + PPO 算法,同步生成竞价金额与储能充放电缩放因子;

反馈优化:以 “收益 - 惩罚 - 储能损耗” 为奖励函数,持续优化时序决策策略,实现长期利润最大化。

【3】创新亮点

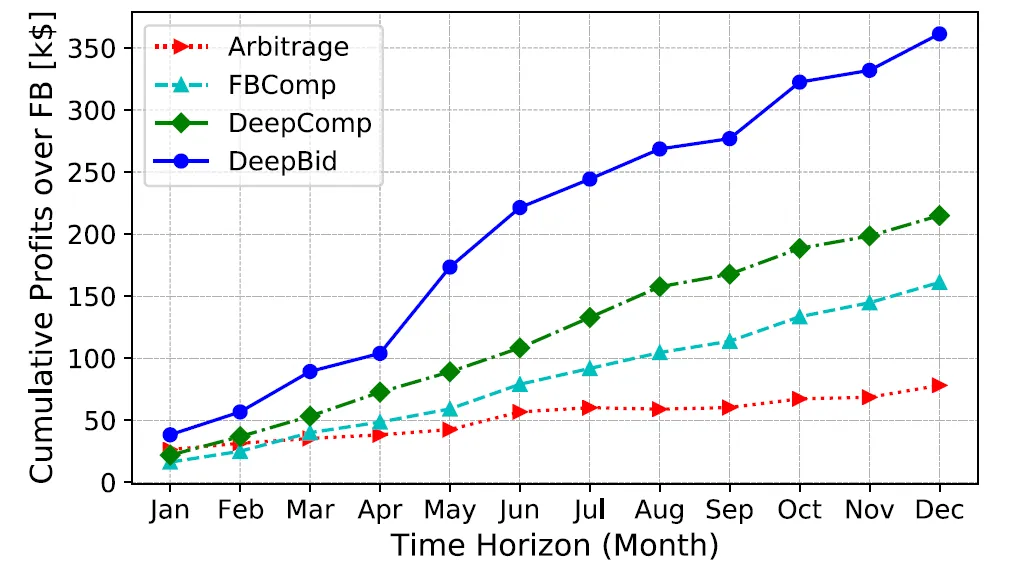

统一双目标框架:首次将新能源竞价与储能的误差补偿、能量套利功能深度融合,而非简单叠加,实现 “低惩罚 + 高收益” 双赢。

误差可补偿竞价策略:突破 “以预测值直接竞价” 的传统模式,结合电池 SoC 动态调整竞价金额 —— 储能充足时允许超竞价,储能不足时适度低竞价。

高效 DRL 实现:采用 PPO 算法 + LSTM 网络,无需预设不确定性分布,计算速度较传统随机优化快 760 倍,满足实时市场时效要求。

【4】学术评论与分析

【分析评论】优点:

实用性强:聚焦实时电力市场实际需求,模型输入输出与业务流程高度契合,易落地;

性能均衡:同时解决偏差惩罚与收益提升两大核心诉求,较单一目标策略更具行业价值;

计算高效:离线训练、在线快速决策,完美匹配实时市场竞价的时间窗口要求。

【分析评论】局限性与改进空间:

假设新能源运营商为 “价格接受者”,未考虑其对市场价格的影响,不适用于大型新能源基地;

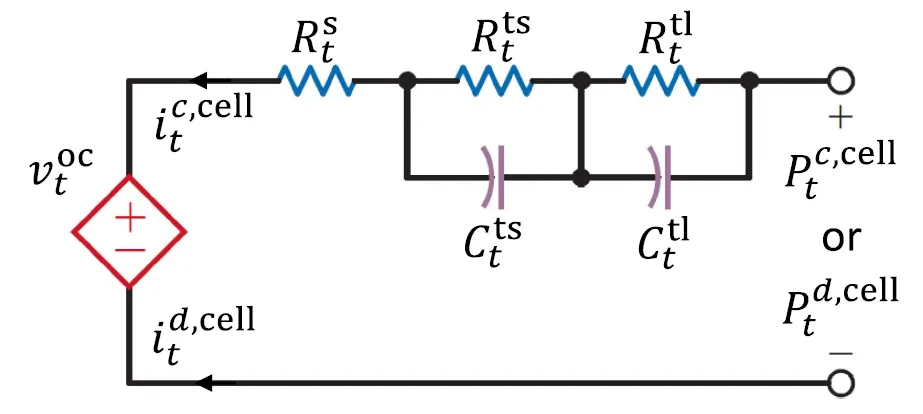

未充分考虑电池容量衰减的动态变化,长期运行下可能影响策略优化精度;

未涉及日前市场与实时市场的联动竞价,策略适用场景可进一步拓展。

【5】配图说明

【6】总结

核心内容提炼

应用前景

学术:为新能源与储能协同优化提供 DRL 应用范式,丰富电力市场智能决策研究;

行业:可直接应用于分布式光伏、风电项目,提升运营商在实时市场的盈利能力;

政策:为电力市场偏差考核机制优化、储能参与市场规则设计提供技术支撑。

优缺点总结

未来改进方向

理论:引入多智能体 DRL,考虑新能源运营商的价格制定权,拓展至日前 - 实时联动竞价;

工程:融入电池动态衰减模型,优化长期运行策略;增加需求响应等灵活资源协同;

应用:适配不同国家电力市场规则,提升模型的通用性与落地性。

参考文献

Jaeik Jeong, Seung Wan Kim, Hongseok Kim. Deep Reinforcement Learning Based Real-Time Renewable Energy Bidding With Battery Control [J]. IEEE TRANSACTIONS ON ENERGY MARKETS, POLICY, AND REGULATION, 2023, 1 (2):85-96.

【开源代码】请关注微信公众号:能电代码研享社,后台(非留言区)回复:第7篇

本文内容基于论文原文提炼,部分表述借助AI生成,仅供学术交流参考,具体技术细节请以原文为准。实际工程应用中,需结合具体场景验证算法可行性。若涉及侵权或内容错误,请联系删除。

合作信息欢迎业务合作交流,联系邮箱:power_journal_code@163.com

更多一区TOP高水平论文代码解读,请关注微信公众号:能电代码研享社

第6篇[1 区Trans论文代码]-光伏+储能参与容量市场:风险感知策略怎么优化?

第5期[一区论文代码]-日前 vs 实时市场:储能参与模式如何优化脱碳经济性?

第4篇[一区论文代码]-对抗储能不确定性!PPO算法解锁弃风弃光+ 混合储能调度新方案

第3篇[一区论文代码]-储能套利遇瓶颈?变充放电效率+ 电价不确定怎么破?解析SDP法1秒求解

第2篇[一区论文代码]-6 种电池技术 + 4 大应用场景!住宅PV 储能系统盈利指南

第1篇[一区论文代码]-储能套利还在靠规则?Rainbow深度强化学习给微电网一个更“聪明”的选择