1.15-1|通过人类经验增强代码智能体治理;数字伴侣生命周期理解与记忆测试基准;依赖感知的推理轨迹记忆;智能体工具使用置信

智能体记忆与推理优化:通过人类经验增强代码智能体治理;数字伴侣生命周期理解与记忆测试基准;依赖感知的推理轨迹记忆;代码智能体工具使用置信度校准

MemGovern: Enhancing Code Agents through Learning from Governed Human Experiences

2026-01-11|UCAS, NUS, ECNU, FDU, XDU, UBC, HKUST(GZ), PKU, RUC, QuantaAlpha|🔺59

http://arxiv.org/abs/2601.06789v2

https://huggingface.co/papers/2601.06789

https://github.com/QuantaAlpha/MemGovern

研究背景与意义

研究背景

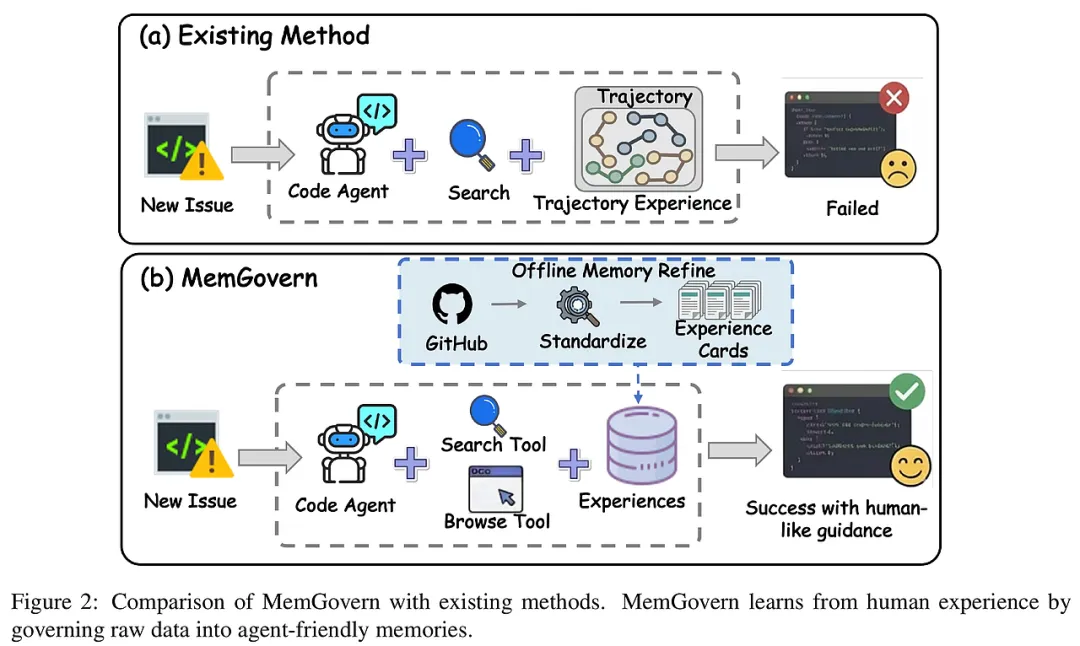

随着大型语言模型(LLMs)在代码理解与生成领域的突破,自动化软件工程代理(Code Agents)正逐步改变编程范式。自动修复GitHub上的真实世界Bug成为评估代码代理能力的重要基准。然而,现有代理普遍存在“闭环世界”限制,即只能基于局部上下文尝试修复,忽视了GitHub等平台上丰富的历史人类经验。

问题与挑战

GitHub上的问题跟踪数据庞大但极度非结构化和碎片化,包含大量社交互动和过程性交流,掩盖了技术核心信息。同时,跨项目术语、模块组织和编码风格差异巨大,阻碍了修复知识的标准化传递。这些因素使得跨仓库经验难以被代理有效利用,成为当前自动修复技术的瓶颈。

研究意义与目标

本研究旨在打破“闭环世界”限制,通过构建一个名为MemGovern的经验治理框架,将原始GitHub数据转化为结构化、代理友好的经验记忆,赋能代码代理利用历史人类调试智慧,提升自动修复的准确率和效率。

研究方法与创新

经验治理框架设计

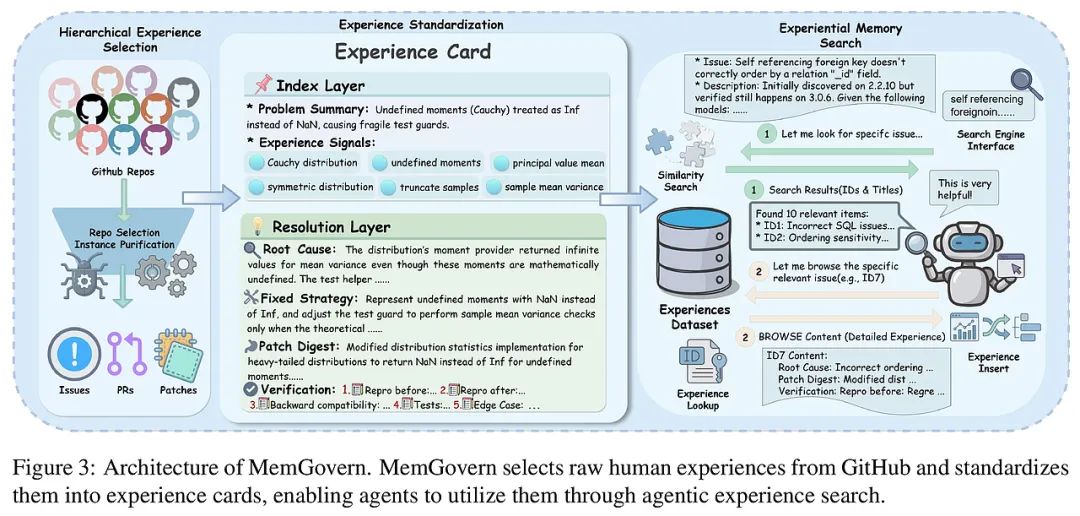

MemGovern通过三阶段治理流程实现经验的高质量标准化:(1)经验筛选:基于仓库活跃度和维护强度筛选优质仓库,确保数据来源权威;同时在实例层面筛除无效或噪声过多的Issue-PR-Patch三元组,保证经验完整性和技术含量;(2)经验标准化:定义统一的修复经验协议,将冗长杂乱的讨论压缩并拆分为两层——索引层(问题摘要与诊断信号)和解决层(根因分析、修复策略与补丁摘要),实现检索语义与修复逻辑的解耦;(3)质量控制:引入基于清单的质量评估机制,利用LLM结构化评分及多轮反馈修正,确保经验卡片的准确性和可靠性。

- 搜索(Searching):通过索引层语义相似度进行快速过滤,获得候选经验卡;

- 浏览(Browsing):深入访问解决层,精准提取修复逻辑,避免信息过载。

基于此,设计渐进式代理搜索策略,使代理能够动态调整检索与浏览行为,模仿人类工程师的多轮假设验证过程,实现广度与深度的平衡探索。

- 模块化与兼容性

MemGovern作为插件式模块,可无缝集成至现有代码代理框架(如SWE-Agent),实现经验记忆的即插即用,便于实际部署和推广。

实验设计与结果分析

实验设置

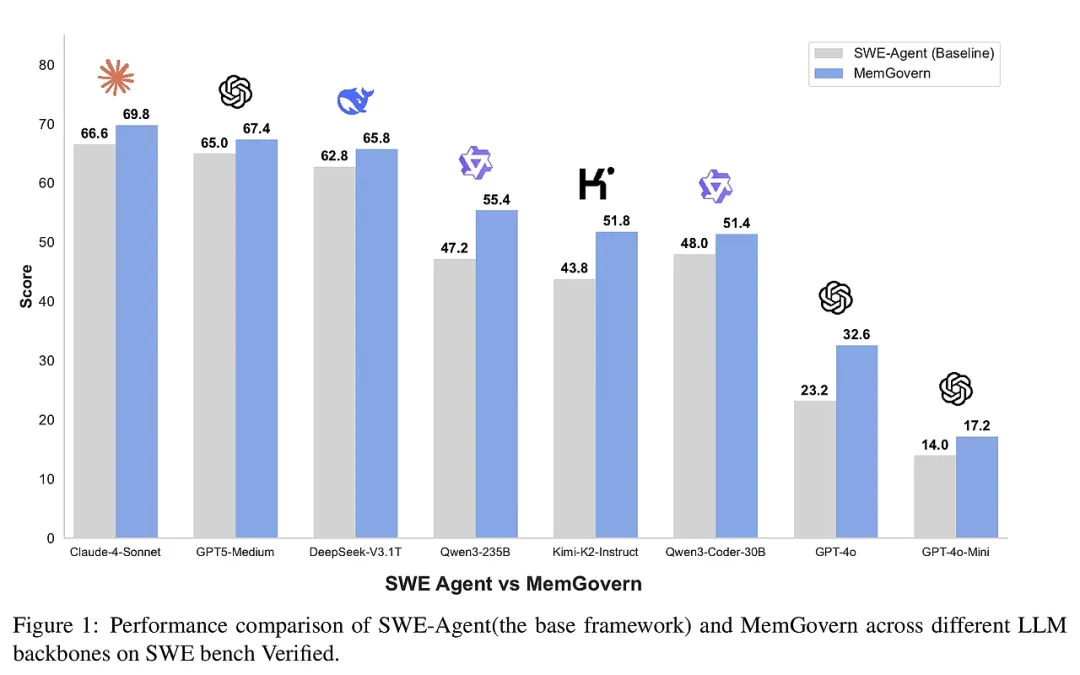

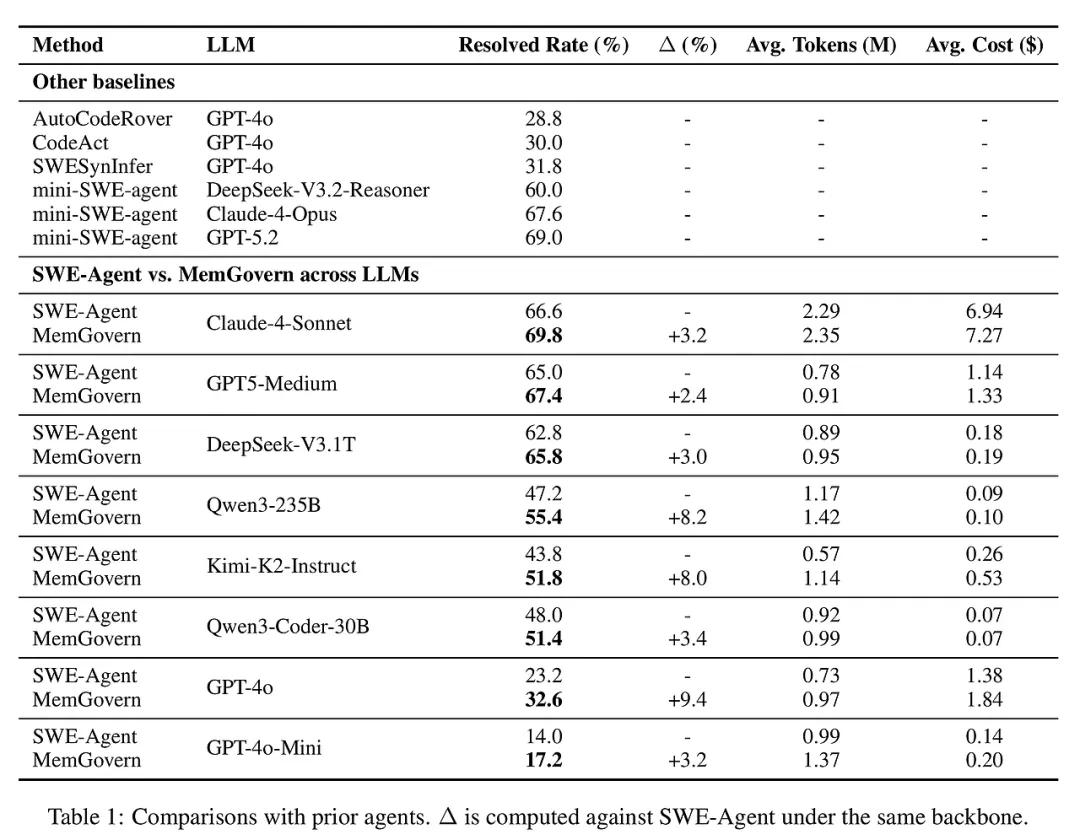

采用SWE-bench Verified基准,包含500个真实GitHub功能性Bug修复任务。对比MemGovern与多款强基线模型(包括SWE-Agent、AutoCodeRover、CodeAct等)在七种不同LLM骨干上的表现。

主要结果

MemGovern在所有模型上均实现性能提升,平均Bug修复成功率提升约4.65%。提升在性能较弱模型上更显著,表明其对模型能力的增强具有普适性。虽然引入经验记忆增加了少量令牌开销,但性能收益远超成本。

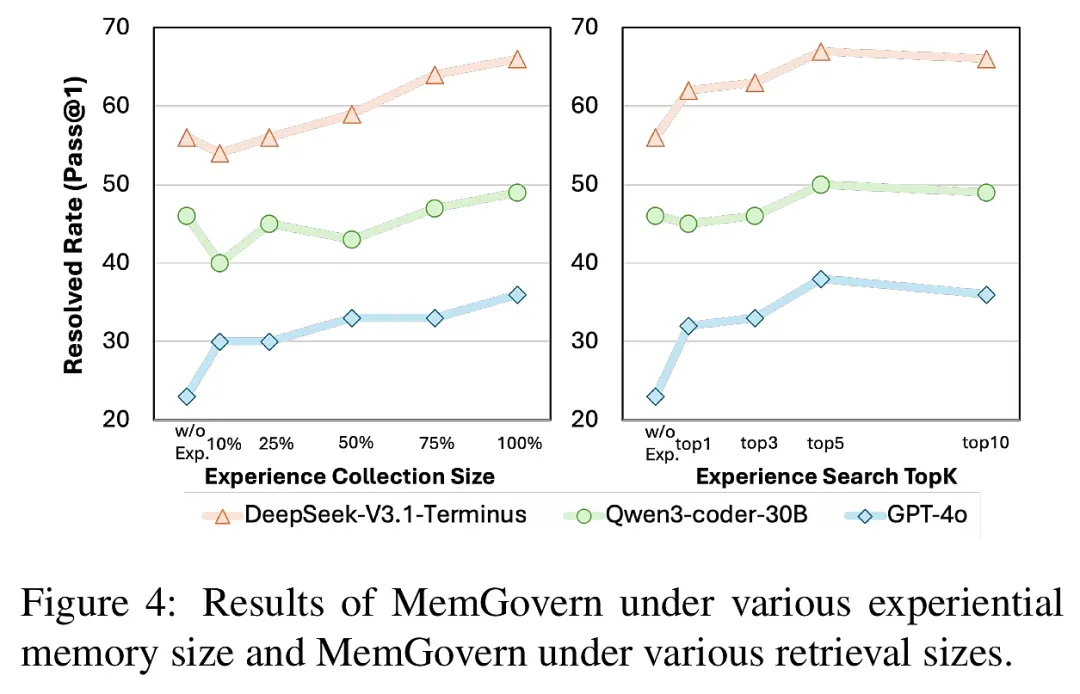

- 经验规模影响:经验记忆规模越大,性能持续提升,验证了大规模经验积累的必要性。

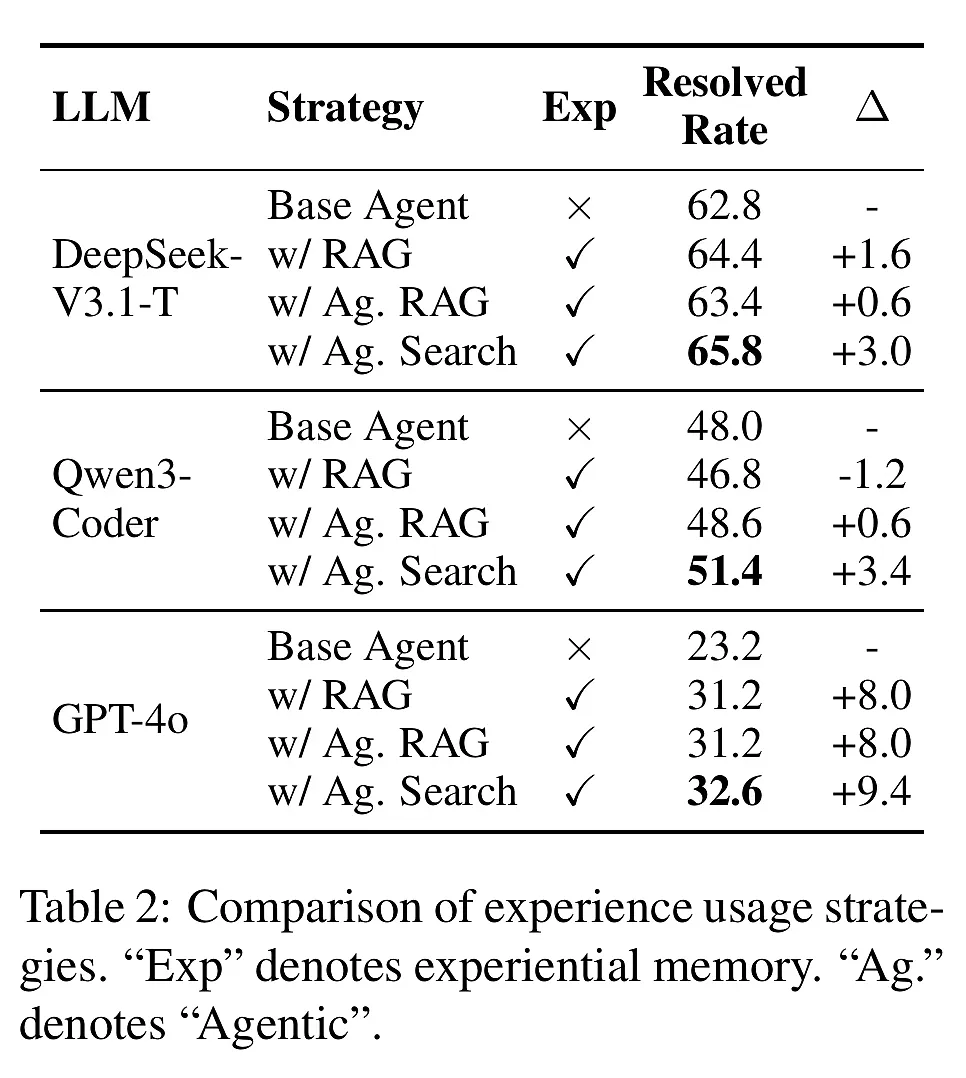

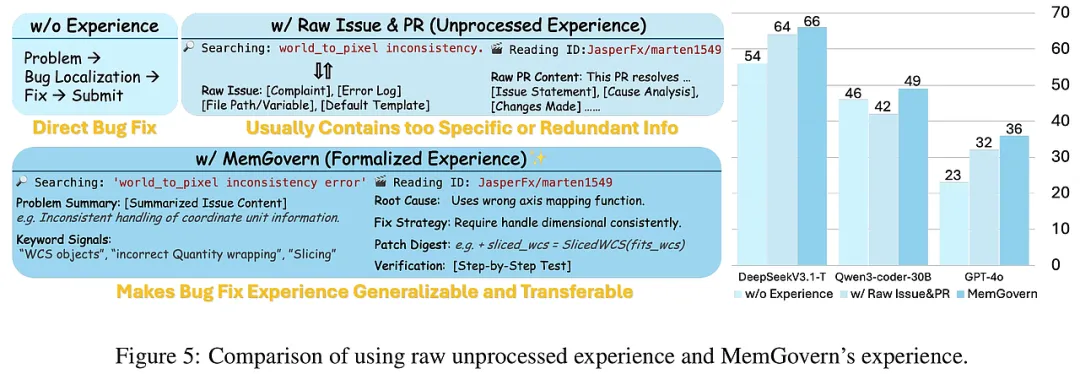

- 经验质量影响:与未治理的原始PR和补丁数据相比,标准化且经质量控制的经验卡片带来更稳定且显著的性能提升,体现治理流程的核心价值。

- 搜索策略优越性:渐进式代理搜索优于传统单次检索注入(RAG)和适应性RAG,因其有效分离候选发现与证据利用,减少噪声干扰,提高修复质量。

- 检索候选数影响:适度增加检索Top-K候选数提升性能,过大则边际效益递减,且不会导致性能下降,显示系统鲁棒性。

- 仓库筛选策略有效性:结合星标、Issue和PR活跃度的综合评分方法筛选仓库,获得的经验更具可复用性和技术价值。

- 行为分析与案例研究

MemGovern显著减少无效探索行为,促进代理聚焦于根因分析和验证测试,提升修复效率和正确性。案例展示中,MemGovern避免了基线的表面修补,实施了语义正确的修复,体现了经验记忆对复杂问题的指导作用。

结论与展望

总结贡献

本文提出MemGovern框架,通过经验治理和代理式搜索,成功将GitHub海量非结构化调试经验转化为结构化、可检索且高质量的经验记忆,显著提升了自动化软件工程代理的Bug修复能力。实验验证了其跨模型、跨任务的广泛适用性和优越性能。

局限性

经验搜索引入了额外的令牌消耗,增加了运行成本。当前经验压缩和记忆管理策略尚待优化,以进一步提升效率。

未来展望

后续工作将探索更高效的经验压缩与选择机制,优化记忆访问策略,扩展经验治理框架至更多软件工程任务,推动自动化代码修复技术向更智能、更实用的方向发展。

KnowMe-Bench: Benchmarking Person Understanding for Lifelong Digital Companions

2026-01-08|UCAS, QuantaAlpha, PKU, THU, CITYU-DG, HAINNU, UTHealth, NUS|🔺46

http://arxiv.org/abs/2601.04745v1

https://huggingface.co/papers/2601.04745

https://github.com/QuantaAlpha/KnowMeBench

研究背景与意义

问题定义与现状

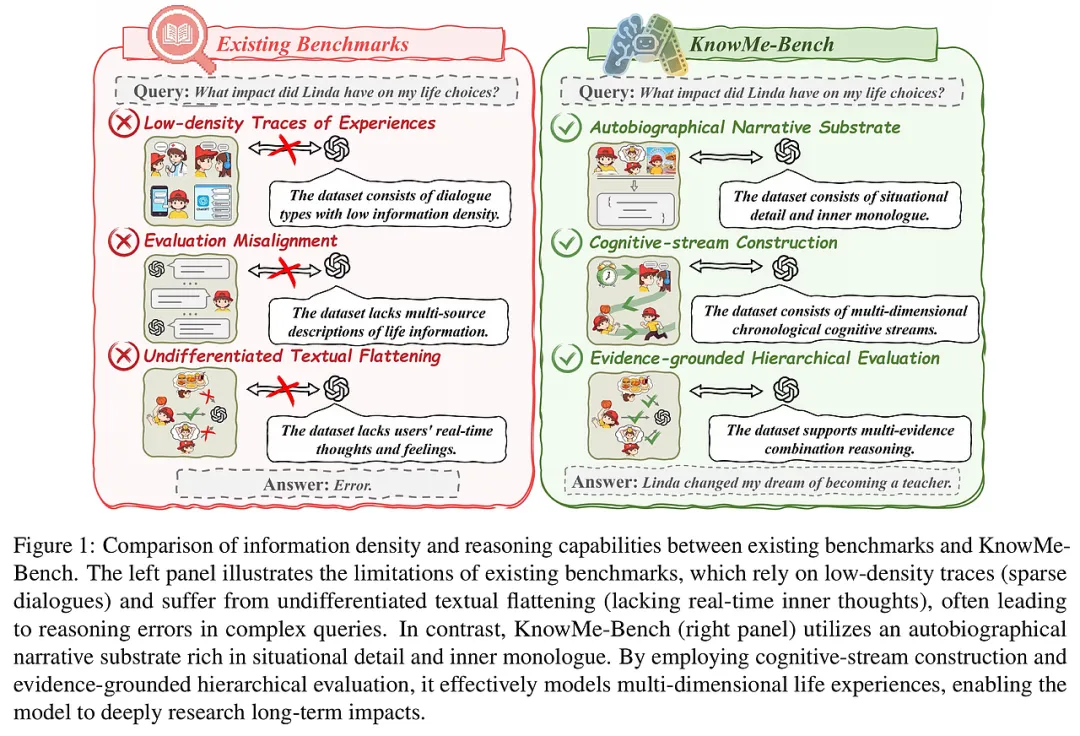

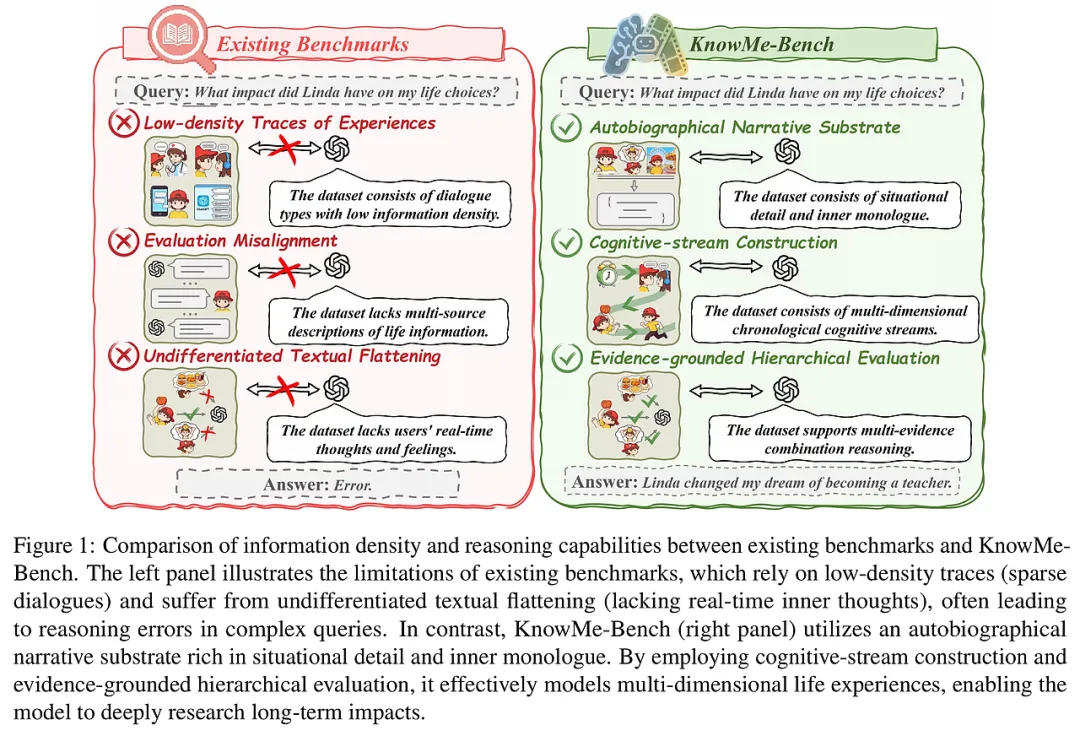

目前,人工智能领域中构建能够长期理解用户的数字伴侣是一个重要目标。这类系统需要跨越长时间跨度,持续维护对用户个性、上下文和行为的理解。然而,现有的长时记忆评测多依赖于多轮对话或合成用户历史,主要聚焦于检索性能,难以真正反映对“人”的深层理解。

- 评测目标错位:多数基准测试侧重事实检索,而非推理用户内在动机、价值观及行为原则。

- 数据基础不匹配:现有数据多为稀疏、扁平化的对话文本,缺乏高密度、结构化的内心独白和情境细节,无法支持长期、因果和心理层面的推理。

研究目标

本文旨在提出一个以自传式叙事文本为数据基础的全新评测框架——KnowMe-Bench,通过高密度、多模态的认知流重建和层级化、证据链驱动的评估,推动数字伴侣领域从简单检索向深度人模型推理转变。

研究方法与创新

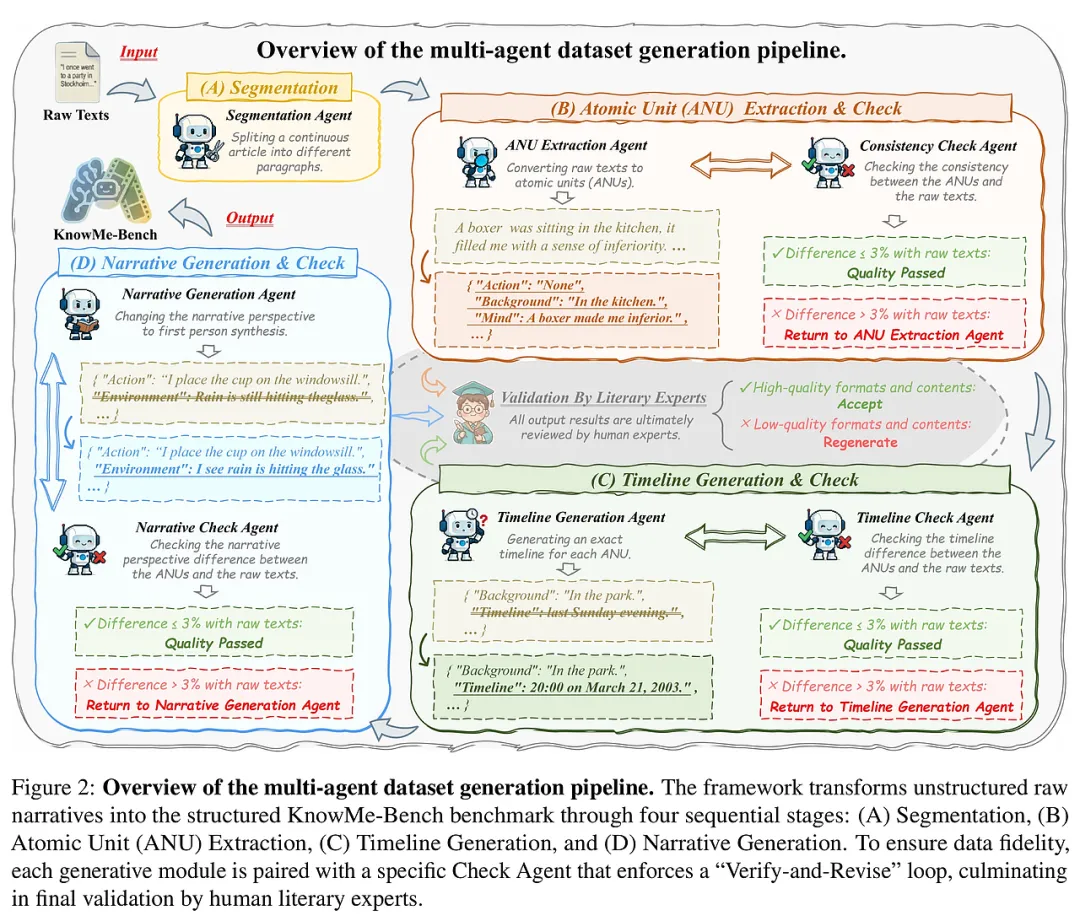

- 自传叙事数据底层(解决数据稀疏问题):采用长篇自传叙事,融合外部事件与内心独白,形成高密度、多维度的经验记录。

- 认知流重建与记忆重定位:通过时间戳和地理信息,结合堆栈状态机模型,处理非线性时间结构(如闪回),拆分为五大认知原子单元(行动、对话、环境、背景、心理),恢复事件的时序与因果关系。

- 多阶段多代理生成与验证流水线:采用“验证-修正”循环,结合自动语义差异度量和人类专家审核,确保数据的真实性与一致性。

- 心理层:行为内在动机推理、专业心理分析,强调对潜台词和心理状态的深度洞察。

- 严格的评分机制:引入基于GPT-4的“LLM作为评委”协议,结合详细评分维度和人类专家校验,确保评测的客观性和信度。

- 高密度多模态认知流结构:区别于传统扁平文本,精细划分并显式标注多种认知维度,提升对复杂内心活动的捕捉能力。

- 闪回感知的时间重排机制:通过堆栈状态机,智能识别并校正非线性叙事,避免记忆混淆和状态覆盖。

- 证据链驱动的深层推理评估:对推理任务要求提供明确的证据支持,杜绝无根据的自由发挥,促进模型生成可审计、可信的解释。

- 多代理协同生成与严格审核流程:结合自动化与人工审核,保障数据质量,解决生成式方法中常见的幻觉与信息丢失问题。

实验设计与结果分析

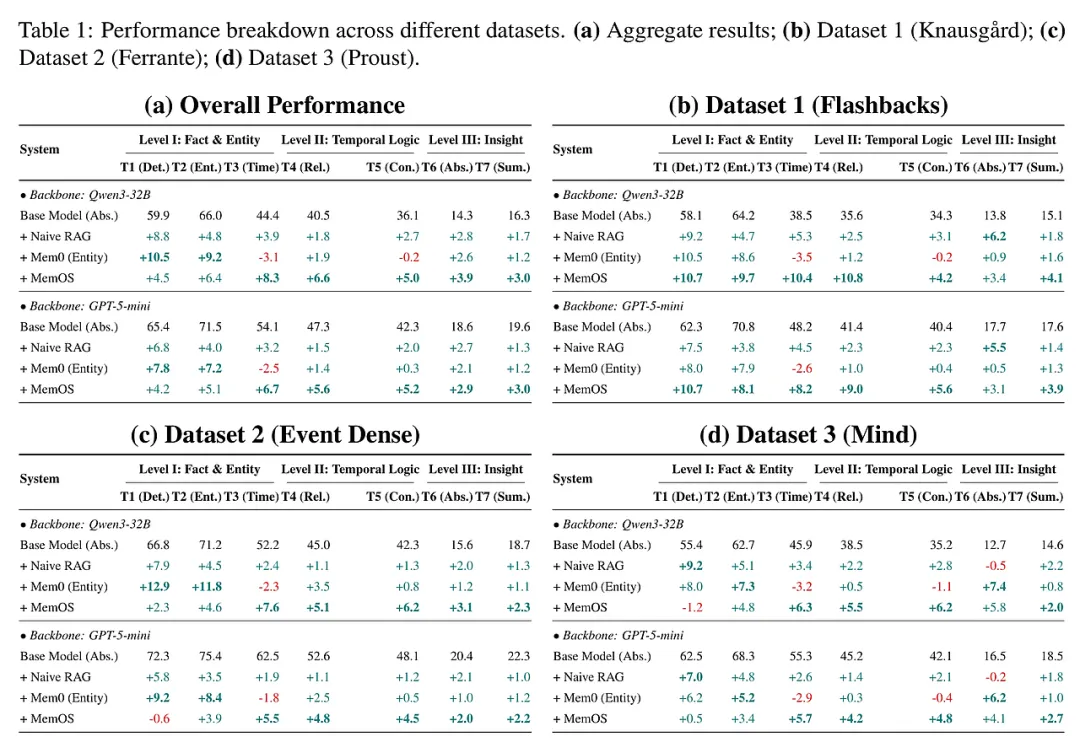

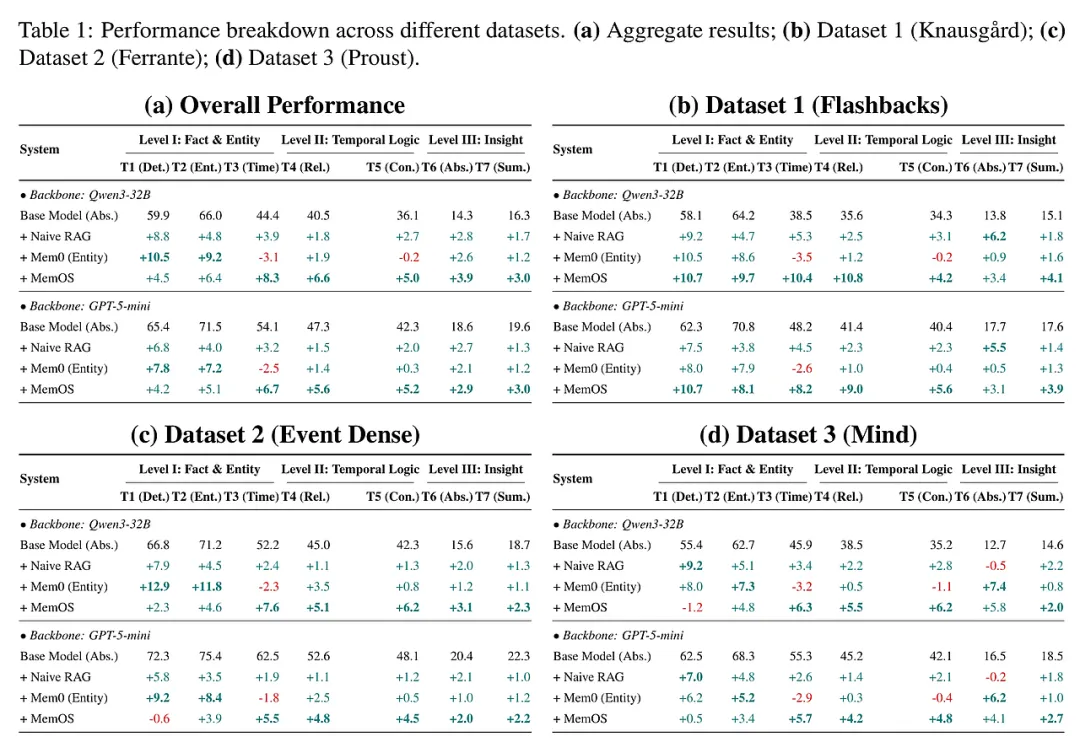

- 使用KnowMe-Bench全量数据(4.7M tokens),涵盖三类自传体文本:闪回密集型(Knausgård)、事件驱动型(Ferrante)、心理深度型(Proust)。

- 评测任务覆盖7个子任务,分属事实、逻辑和心理三个层级。

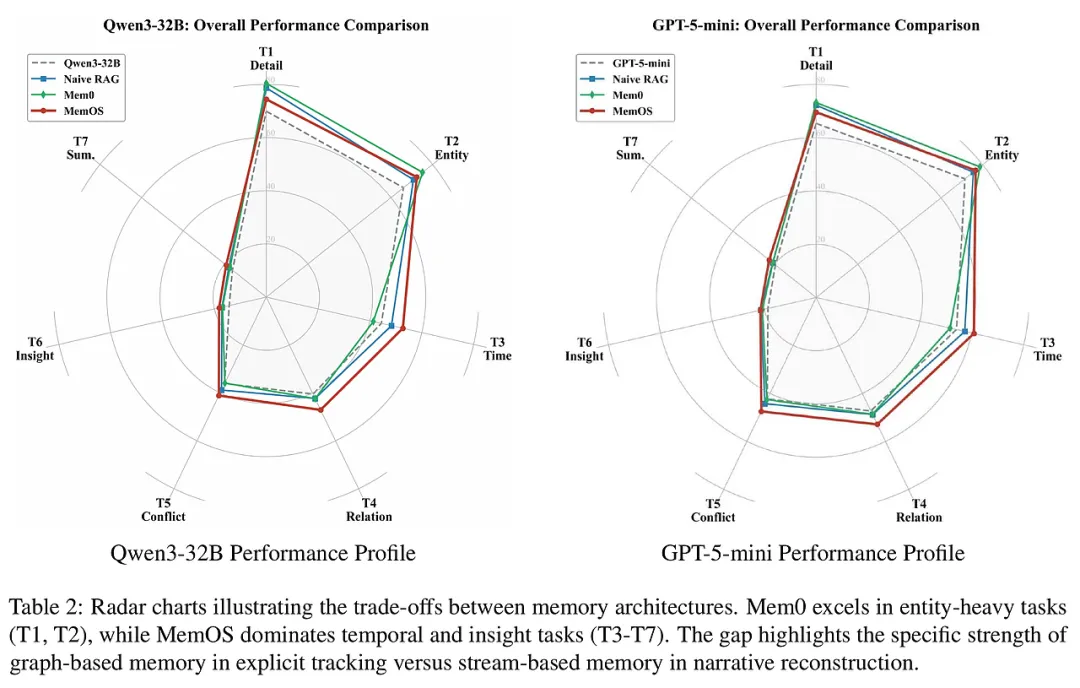

- 对比系统包括基础模型(Qwen3-32B、GPT-5-mini)、标准检索增强(NaiveRAG)、实体记忆跟踪(Mem0)、流式认知架构(MemOS)。

- 事实层面:实体记忆系统Mem0显著提升实体一致性和事实提取准确率,尤其在事件驱动数据集表现优异。

- 逻辑层面:流式认知系统MemOS在时间推理和事件逻辑排序任务中表现突出,尤其擅长处理闪回等非线性时间结构。

- 心理层面:所有系统在深层心理分析任务中表现较弱,最高得分远低于事实任务,表明当前技术在理解内在动机和复杂心理状态方面仍有巨大提升空间。

- 更新悖论揭示:实体记忆系统在处理闪回时易出现状态覆盖错误,而流式系统则有效避免,强调了时间顺序完整性的重要性。

- 检索与理解的矛盾:检索增强虽然提升事实准确性,但在心理推理任务中可能引入语境污染,反而带来性能下降。

- 模型规模与架构影响:更强基础模型对记忆模块依赖降低,但在复杂推理任务中依然受限。

- 结构化记忆系统在面对对抗性查询时表现更稳健,减少幻觉生成,保障交互安全。

结论与展望

- 提出并实现了一个基于高密度自传叙事的长期人模型推理评测基准——KnowMe-Bench。

- 创新性地构建了闪回感知的认知流重建技术,提升了对复杂时间结构的理解能力。

- 设计了三级证据链驱动的层级化评测体系,实现了对人格理解从事实到心理深度的全面量化。

- 通过广泛实验揭示当前长时记忆系统在非线性时间处理和深层心理推理上的关键短板。

- 评测依赖于严格的多代理生成与人工审核,成本较高,限制了大规模快速迭代。

- 深层心理推理任务得分低,提示现有语言模型及记忆机制尚未能有效捕捉复杂的人格内涵。

- 未来研究可探索更精细的认知架构设计、跨模态融合及强化学习策略,提升对用户内在动机和价值观的动态建模能力。

- 推动从单纯检索向认知推理和情感共情的转型,是实现真正终身数字伴侣的关键。

本研究为数字伴侣领域提供了坚实的评测工具和理论基础,期待激发社区更多关注认知层面的人格理解,助力开发更具同理心和深度推理能力的智能系统。

MemoBrain: Executive Memory as an Agentic Brain for Reasoning

2026-01-12|BAAI, RUC|🔺31

http://arxiv.org/abs/2601.08079v1

https://huggingface.co/papers/2601.08079

https://github.com/qhjqhj00/MemoBrain

研究背景与意义

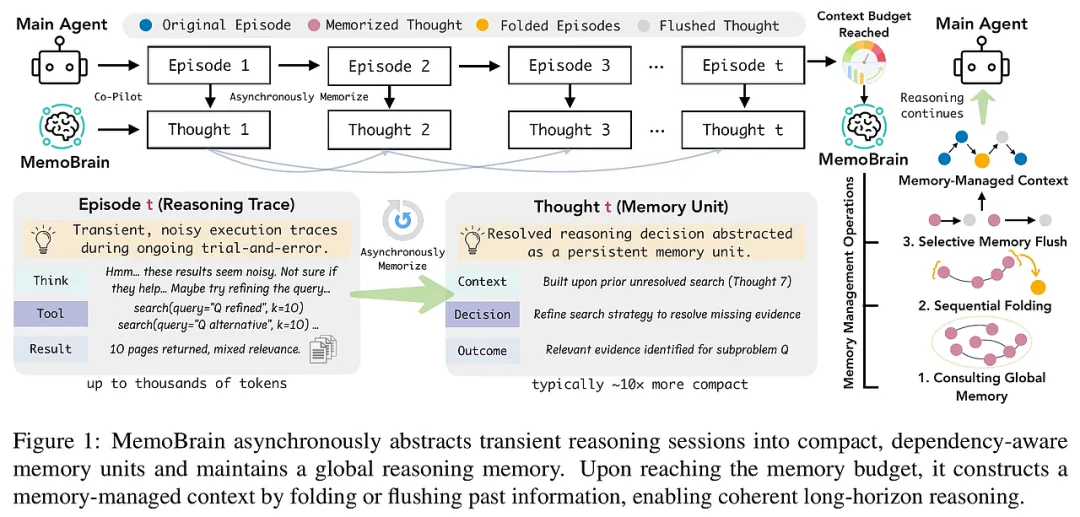

当前,基于大语言模型(LLMs)的工具增强智能体在复杂推理任务中展现出强大能力,但其推理过程通常是长时序的,涉及大量中间推理步骤和工具调用产生的临时信息,导致有限的上下文容量迅速被占满,进而引发认知过载和任务对齐下降。传统的记忆机制多聚焦于跨任务的长期信息积累,或被动地压缩上下文,难以满足复杂推理中对信息流的主动控制和全局任务感知的需求。针对这一挑战,本文提出“执行记忆”(executive memory)概念,强调记忆不仅是辅助性效率工具,而是维持长时序、目标导向推理的核心组件。通过将记忆机制从被动的上下文管理转变为主动的推理轨迹控制,本文旨在实现智能体在有限上下文预算下的持续一致性和任务对齐。

研究方法与创新

本文提出MemoBrain,一种独立于推理智能体的执行记忆模型,作为“副驾驶”协同工作,主动构建和管理推理轨迹的记忆结构。其核心创新包括:

依赖感知的记忆构建:将每个推理步骤抽象为“思考单元”(thought),捕获其语义贡献及逻辑依赖关系,形成结构化的推理轨迹图,超越传统的时间序列堆叠,保留推理的因果和语义骨架。

主动的记忆管理机制:在固定上下文预算内,MemoBrain通过两类操作——“折叠”(folding)和“刷新”(flushing)——动态调整记忆结构。折叠将已解决子任务的推理步骤压缩为摘要,减少无效冗余;刷新则针对失效或过时的推理节点进行信息压缩,保留高层结构信息,避免认知负担。

双阶段优化策略:先通过监督微调提升记忆构建的抽象质量,再利用直接偏好优化(Direct Preference Optimization)强化记忆管理的决策能力,使得记忆操作兼具语义充分性和上下文压缩效率。

模块化设计与普适性:MemoBrain作为外部插件,可无缝集成多种基于工具的智能体框架,支持多模型规模,且不依赖特定推理架构,增强了系统的泛化和复用性。

这一方法将记忆从被动的上下文缓存转变为主动的认知控制机制,实现了对推理过程的全局感知和动态调节,显著提升了长时序推理的连贯性和效率。

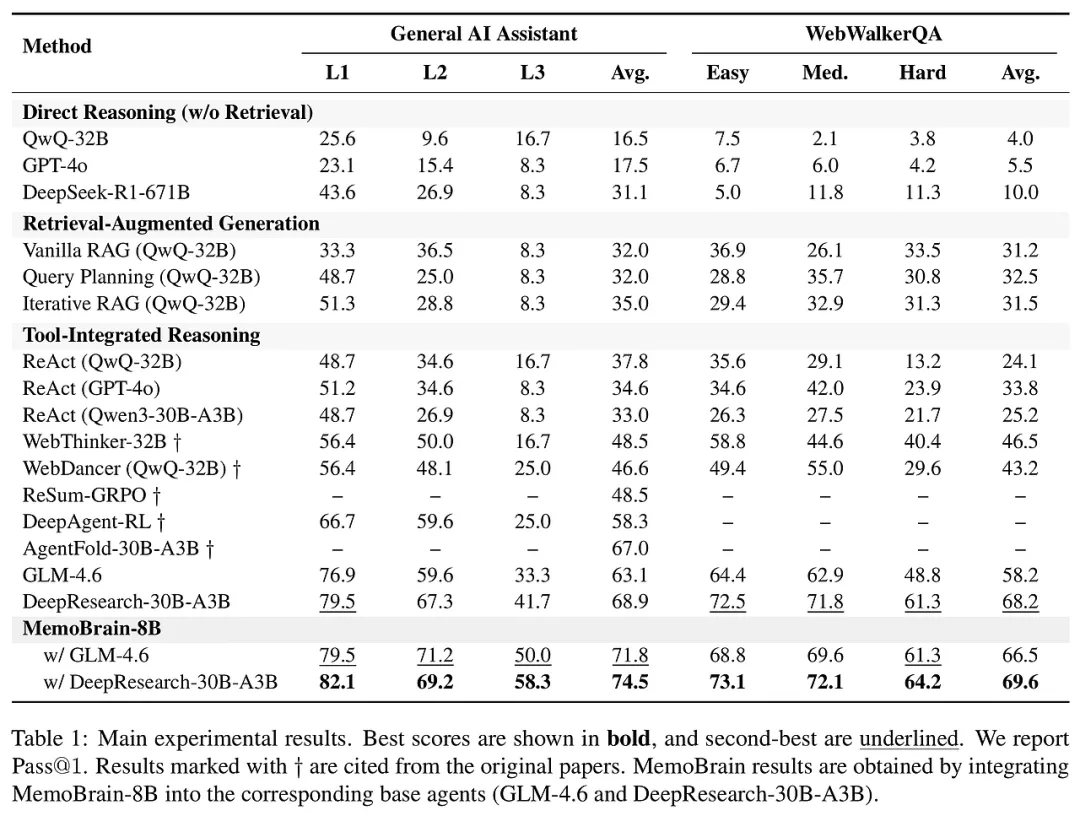

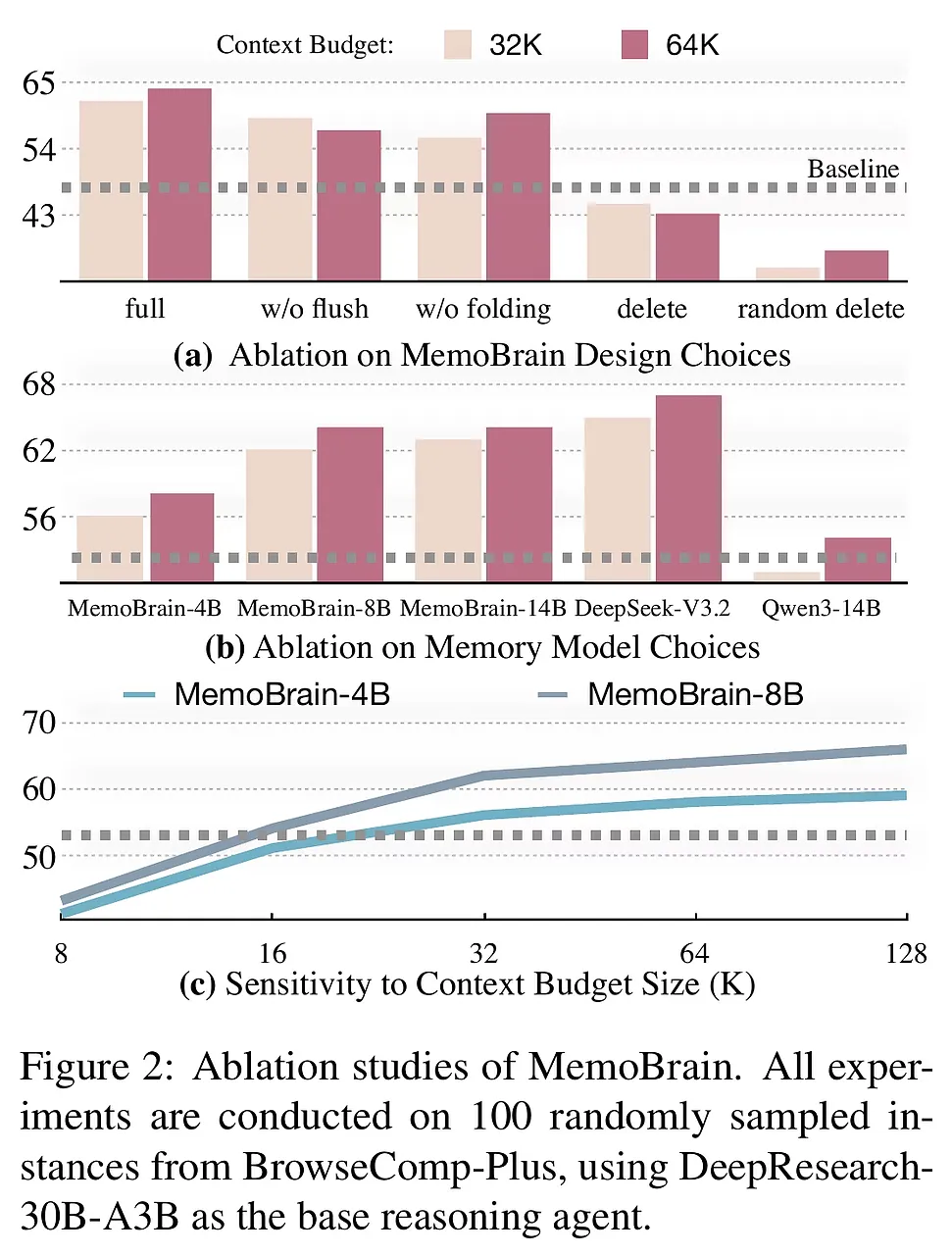

实验设计与结果分析

实验在三个复杂长时序推理基准(GAIA、WebWalker、BrowseComp-Plus)上进行,涵盖多领域、多任务的工具调用和信息整合需求。基线涵盖:

检索增强生成方法(如VanillaRAG及其变体)

工具集成推理系统(如ReAct、WebThinker、DeepAgent)

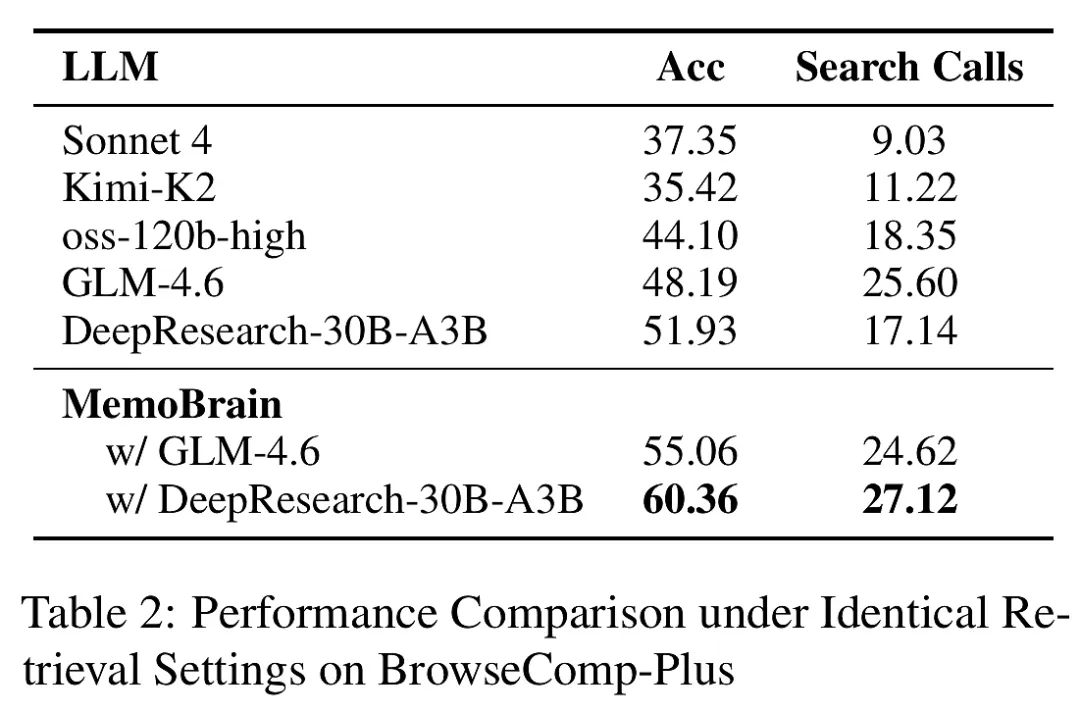

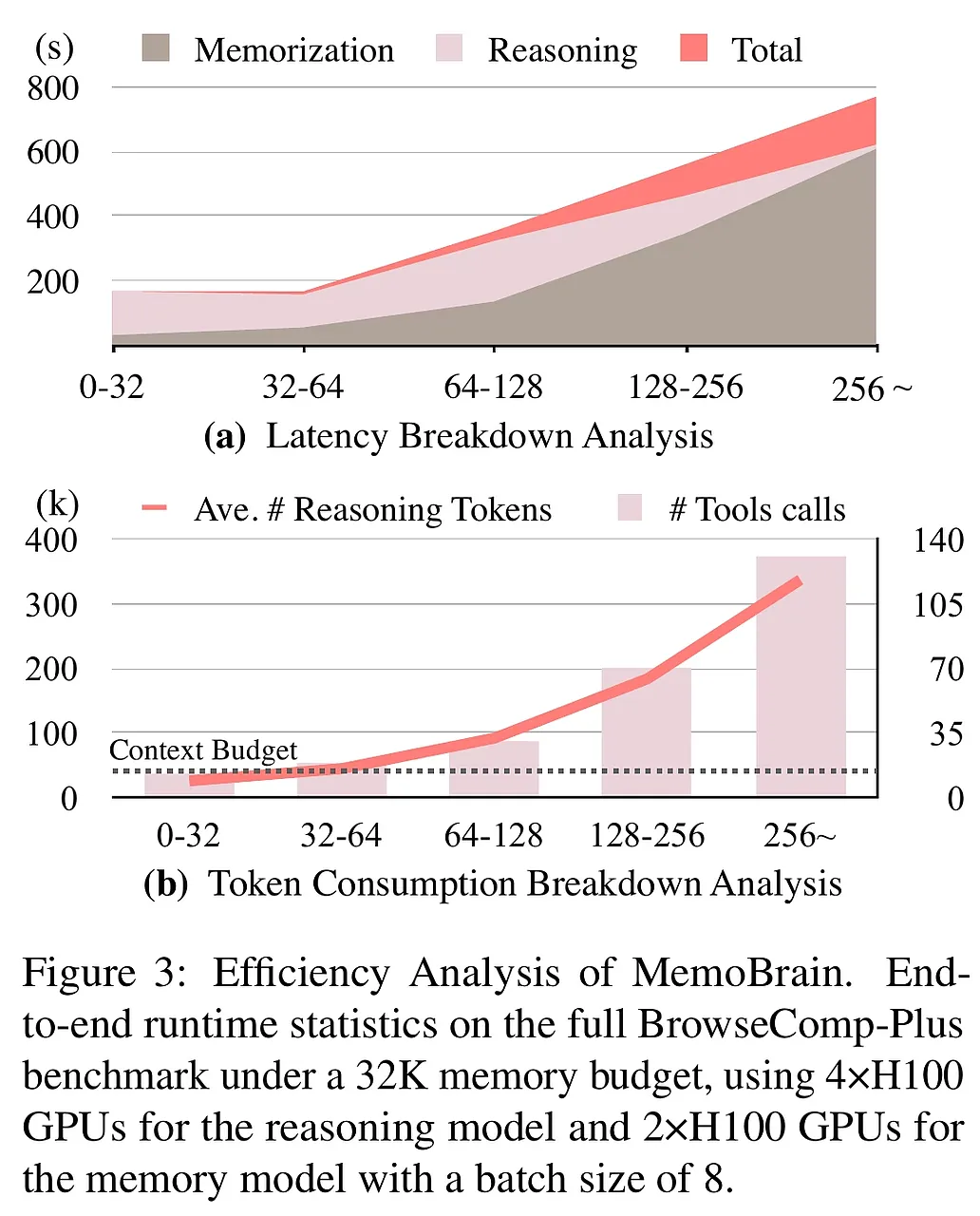

MemoBrain集成于强基线GLM-4.6和DeepResearch-30B-A3B上,结果表现出:

稳定且显著提升:所有测试集上均优于基线,尤其在长上下文和复杂推理场景中表现突出,最高提升幅度达数个百分点,验证了执行记忆的有效性。

设计选择验证:消融实验显示,依赖感知的记忆结构和双重记忆管理操作(折叠与刷新)均为性能提升的关键,随机删除或简单删除记忆节点效果显著下降。

上下文预算敏感性:在不同上下文预算下,MemoBrain均能有效利用资源,提升推理的上下文利用率和工具调用效率,显示出良好的扩展性。

效率分析:记忆构建异步进行,基本不增加端到端推理延迟。即使在超过256K token的超长轨迹中,记忆管理开销仍保持低水平,支持大规模长时序推理。

整体来看,MemoBrain不仅提升了推理性能,还有效缓解了认知过载,增强了工具调用的有效性和推理连贯性。

结论与展望

本文提出的执行记忆范式及其实现MemoBrain,为复杂工具增强智能体的长时序推理提供了全新的认知控制视角。通过主动构建依赖感知的推理轨迹记忆,并动态管理信息流,MemoBrain显著提升了智能体在有限上下文预算下的任务对齐和推理能力。实验验证了其在多模型、多任务、多场景下的普适性和有效性,展示了执行记忆作为认知机制的重要价值。

未来工作可从以下方向展开:

更细粒度的认知建模:引入更丰富的推理状态表示和推理策略调整,进一步提升记忆的认知适应性。

跨任务长期记忆融合:结合执行记忆与跨任务长期记忆,实现知识积累与推理控制的有机统一。

多模态与交互扩展:将执行记忆应用于多模态推理和人机交互场景,提升智能体的综合认知能力。

轻量化与实时性优化:进一步优化记忆模型的计算开销,支持更大规模和更低延迟的在线推理应用。

综上,执行记忆为智能体推理提供了坚实的认知基础,推动了长时序复杂任务的智能化进程,具有广阔的研究和应用前景。

The Confidence Dichotomy: Analyzing and Mitigating Miscalibration in Tool-Use Agents

2026-01-12|UTokyo, RIKEN AIP, NWU(USA), Waseda U, CMU|🔺20

http://arxiv.org/abs/2601.07264v1

https://huggingface.co/papers/2601.07264

研究背景与意义

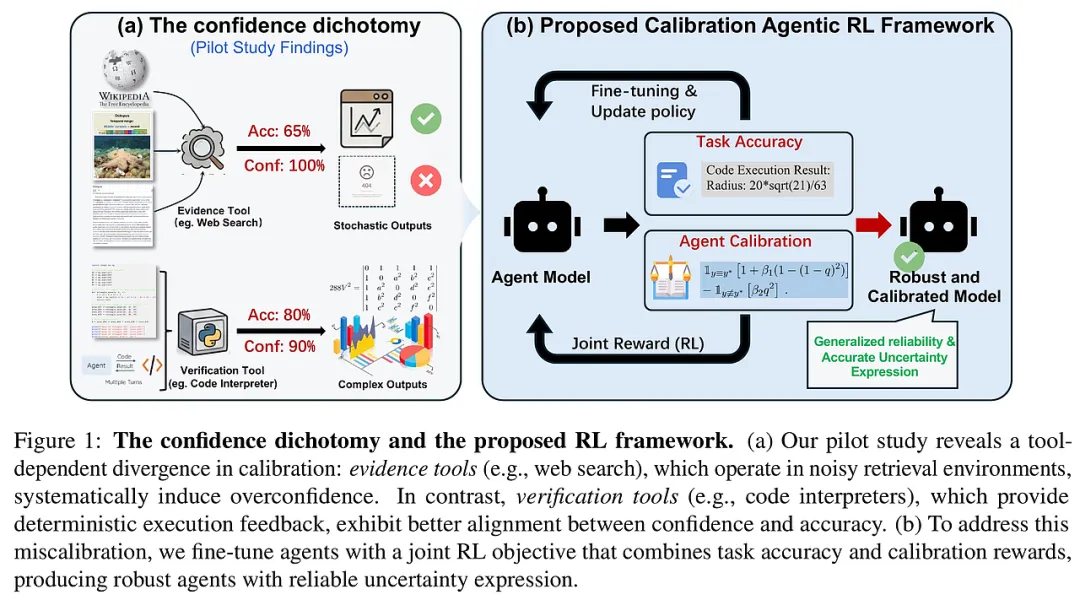

- 背景概述:随着大型语言模型(LLMs)从静态文本处理向具备工具使用能力的自主智能体转变,这些智能体能够在动态、复杂的现实环境中执行多轮任务,极大扩展了应用潜力。然而,确保这些工具使用智能体的可信度,尤其是其置信度的校准,成为亟待解决的核心挑战。

- 问题定义:置信度校准指智能体表达的置信度能够真实反映其实际表现的能力。尽管静态模型的校准已被广泛研究,但工具集成智能体中的置信度动态尚未深入探讨,尤其是不同类型工具对校准的影响存在显著差异。

- 挑战与目标:现有研究表明,基于证据检索的工具(如网络搜索)往往引入噪声,导致智能体过度自信;而基于验证的工具(如代码解释器)通过确定性反馈,有助于缓解误校准问题。本文旨在系统分析不同工具类型对智能体置信度的影响,揭示“置信度二分法”,并提出针对性校准优化方法,提升智能体在多领域任务中的可靠性。

研究方法与创新

- 方法框架:本文提出“校准智能体强化学习框架”(Calibration Agentic RL,CAR),通过联合优化任务准确率与置信度校准,克服工具使用引发的过度自信问题。该框架基于强化学习,设计了多样化的奖励结构,特别是创新性的“边际分离校准奖励”(Margin-Separated Calibration Reward,MSCR),确保正确与错误预测的奖励严格分离,避免奖励重叠导致的学习不稳定。

- 置信度表达结构扩展:在智能体输出中强制包含数值化置信度标签,保证置信度的结构完整性和可解析性。

- 联合奖励设计:结合格式完整性奖励与校准激励,促进智能体在保持准确性的同时,实现置信度的真实反映。

- MSCR奖励机制:通过对正确与错误预测分别设定不同的奖励边界,消除“安全失败”现象,提升训练过程的稳定性和效果。

- 多模型与多任务适用性:方法在不同规模的Qwen模型(3B至7B参数)及多种任务(包括开放域问答和数学推理)中均表现出良好的适应性和泛化能力。

- 理论基础:基于强化学习中的策略优化理论,结合置信度校准领域的误差度量(如ECE、Brier分数),实现置信度与任务表现的协同优化,推动工具集成智能体的自我认知能力发展。

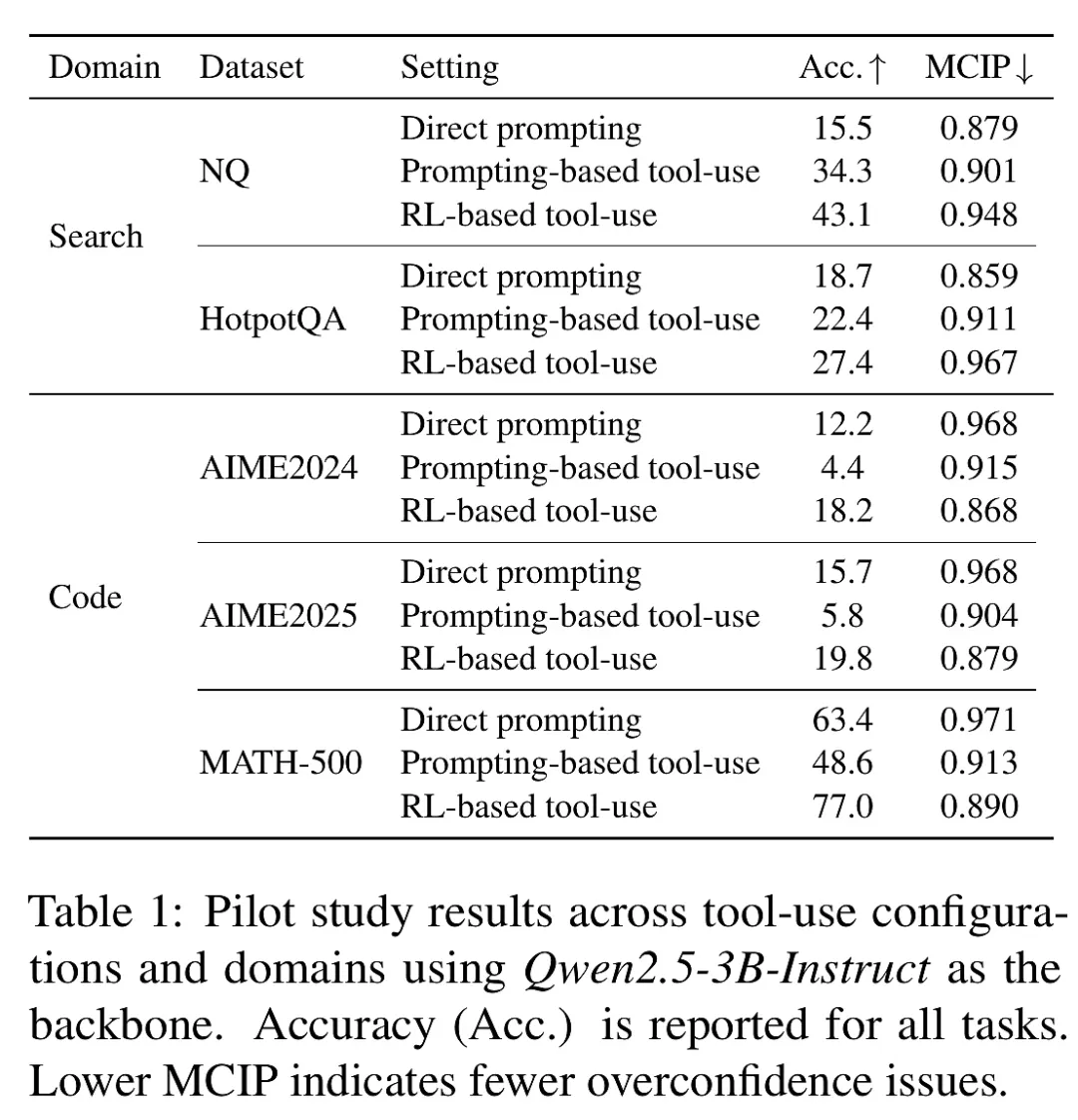

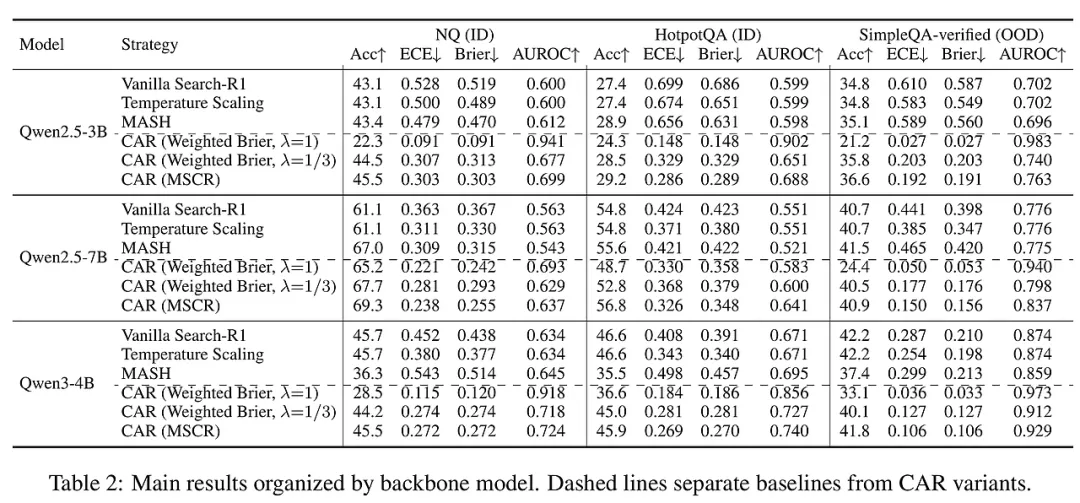

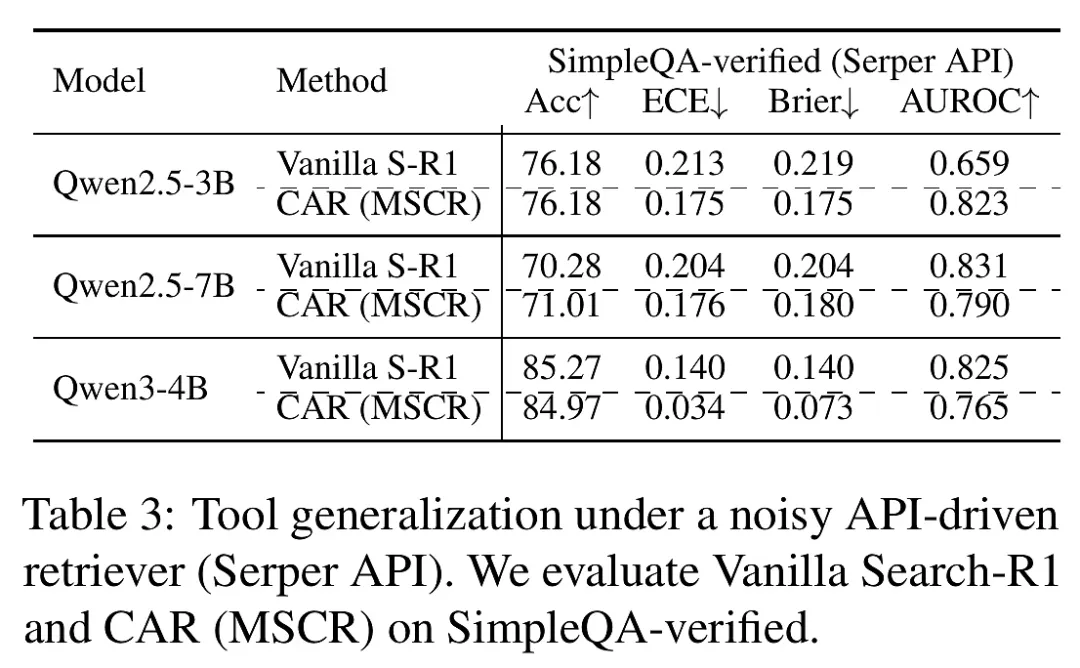

实验设计与结果分析

- 工具类型对比:选取典型的证据工具(Web搜索)与验证工具(代码解释器)作为代表,分别在开放域问答和数学推理任务中进行评估。

- 训练配置:采用三种策略——直接提示、基于提示的工具使用、强化学习优化的工具使用,确保结果的全面性。

- 评估指标:准确率(Accuracy)、期望校准误差(ECE)、Brier分数、AUROC等多维度指标综合衡量性能和校准效果。

- 置信度二分法验证:证据工具普遍导致智能体出现严重的过度自信,验证工具则通过确定性反馈有效缓解了这一问题。

- CAR框架效果显著:相较于基线方法(如温度缩放、MASH等),CAR在保持甚至提升任务准确率的同时,显著降低了ECE和Brier分数,提升了置信度的可靠性。

- 泛化能力强:在从本地静态知识库到真实噪声较大的API检索环境的迁移测试中,CAR训练的智能体表现出稳健的校准能力,验证了方法的实用性和适用范围。

- 工具集成推理表现:在数学推理任务中,CAR同样带来校准与性能的双重提升,表明该方法不仅适用于信息检索场景,也适合执行复杂逻辑推理的工具集成智能体。

- 统计显著性:通过t检验等统计方法确认了不同配置间校准性能的显著差异,保证结论的科学严谨。

结论与展望

- 研究贡献总结:本文系统揭示了工具使用智能体中置信度校准的根本性二分现象,提出了创新的强化学习校准框架CAR及其核心奖励设计MSCR,显著提升了智能体的置信度表达能力和任务表现,促进了自主智能体的可信部署。

- 局限性:当前研究模型规模限制在3B至7B参数,尚未探究更大模型的校准动态;实验主要聚焦于短答案及数学推理任务,未来需扩展至更开放、复杂的生成场景。此外,长期反馈和多步规划中的置信度校准仍需深入研究。

- 模型规模扩展:探索更大规模模型及其校准机制,验证方法的普适性和可扩展性。

- 多模态与多任务融合:将校准策略推广至视觉语言模型及跨任务智能体,提升多模态交互的可信度。

- 动态反馈机制:引入更丰富的反馈信号和延迟奖励,优化长期规划和多轮交互中的置信度表达。

- 实际应用部署:结合工业场景,推动校准智能体在金融、医疗、自动驾驶等高风险领域的安全可靠应用。

- 总体意义:本研究为构建具备自我认知与不确定性表达能力的智能体奠定了理论与方法基础,推动人工智能向更安全、透明和可信的方向发展。