AI 进化策:2026 AI 编程智能体(Coding Agent)全景评估报告:从辅助插件到自主生产力的跃迁

- 2026-02-05 01:06:58

第一章 评估概述

1.1 研究背景:智能体时代的黎明

2025年至2026年初,全球软件工程领域经历了一场更为深刻的代际更迭。如果说2023年是生成式AI的“补全时代(Autocomplete Era)”,那么2026年则正式确立了“智能体协作时代(Agentic Collaboration Era)”。随着大语言模型(LLM)推理能力的指数级跃升——特别是Claude 3.5/3.7系列、GPT-4o及Gemini 1.5 Pro在代码逻辑理解上的突破——开发工具的形态已从单纯的文本预测器,演化为具备环境感知、多步规划与自主执行能力的智能实体。

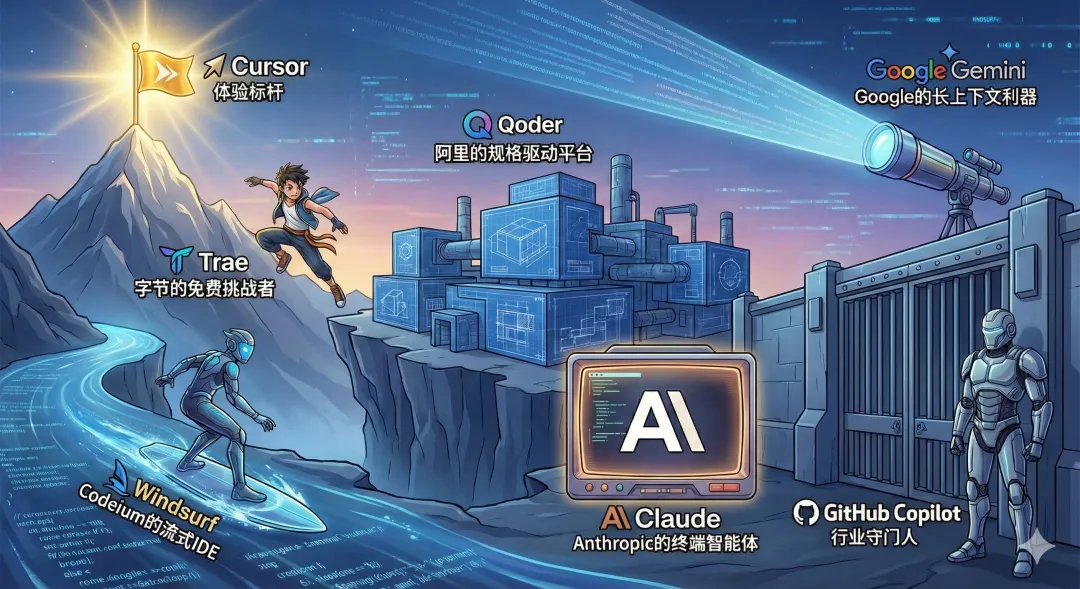

本评估报告基于八大核心维度(交互形态、上下文感知、模型能力、智能体能力、安全合规、开发者体验、成本与生态维度),对当前市场上的七款主流工具进行了深度解构:Cursor(体验标杆)、Trae(字节的免费挑战者)、Windsurf(Codeium的流式IDE)、Qoder(阿里的规格驱动平台)、Claude Code(Anthropic的终端智能体)、Gemini CLI(Google的长上下文利器)以及GitHub Copilot(行业守门人),旨在为企业CTO、技术团队负责人及高级软件工程师提供一份详尽的决策参考。

1.2 核心发现概览

本研究通过对技术架构、用户反馈及实测数据的综合分析,得出以下核心结论:

交互范式的分化:市场呈现出“IDE重构派”与“终端复兴派”两极分化。Cursor通过Composer确立了“多文件并发编辑”的行业标准,Trae和Windsurf在此基础上进行了微创新;而Claude Code和Gemini CLI则试图绕过GUI,直接在终端层通过自然语言接管DevOps流程,体现了“Unix哲学”在AI时代的回归。

上下文感知的质变:单纯的RAG(检索增强生成)已成过去式。Cursor的本地索引、Qoder的知识图谱(Repo Wiki)以及Gemini的1M+ Token暴力上下文正在形成三种异构的技术路线。MCP(Model Context Protocol)协议的出现,使得IDE开始具备连接外部世界(如Linear工单、Sentry日志)的能力,成为真正的研发操作系统。

规格驱动开发(SDD)的兴起:Qoder的“Quest Mode”和Claude Code的“Think”模式标志着开发模式的根本转变——开发者的时间将更多投入在定义规格(Spec)与验收测试(Review),而非编写具体实现(Implementation)。

1.3 声明

本文内容基于公开资料整理及笔者个人体验,限于视野与调研渠道,文中难免有挂一漏万或解读偏颇之处,内容仅供参考与交流。如有谬误,敬请方家指正。

第二章 行业演进与评估框架重构

2.1 技术演进路径:从 Copilot 到 Agent

回顾过去五年,AI编程工具经历了三个显著阶段,这一历史视角对于理解当前工具的定位至关重要。

阶段一:单行补全(2021-2022)

以早期的GitHub Copilot为代表,利用OpenAI Codex模型,基于光标前后的有限Token(Look-behind/Look-ahead)进行概率预测。这一阶段的工具本质上是“更聪明的自动补全”,无法理解项目结构,也无法处理跨文件逻辑。

阶段二:对话式辅助(2023-2024)

随着ChatGPT的爆发,IDE侧边栏(Side Chat)成为标配。开发者开始通过对话来生成代码块、解释逻辑或生成单元测试。然而,这种模式存在严重的“上下文切换(Context Switching)”成本——开发者需要在编辑器和聊天窗口之间频繁复制粘贴,打断了心流。

阶段三:智能体原生(2025-2026)

这是当前的现状。工具开始获得“手脚”(Tools/MCP)和“记忆”(Indexing/Repo Context)。Cursor的Composer允许AI直接修改文件;Claude Code可以直接运行终端命令;Qoder可以异步执行长任务。AI不再是旁观的建议者,而是拥有文件系统读写权和编译器调用权的“副驾驶”。

2.2 八维评估模型

为了全面覆盖“智能体原生”时代的特性,笔者基于如下八维评估模型进行评估:

交互形态 (Interaction Morphology):考察人机协作的界面粒度。是基于对话框、行内编辑,还是全屏接管?是否支持“自然语言转终端命令”?

上下文感知 (Context Awareness):考察AI对“世界”的理解。不仅是代码库索引(Codebase Indexing),还包括运行态信息(Terminal Output)、外部文档(Docs)及项目元数据。是否支持RAG?是否支持超长上下文窗口?

模型能力 (Model Capabilities):考察底层智力。支持哪些SOTA模型(Claude 3.5 Sonnet, GPT-4o, o1)?是否具备多模态能力(视觉转代码)?是否支持模型路由(Router)以平衡成本与智力?

智能体能力 (Agentic Capabilities):考察自主性。能否进行多步推理(Chain of Thought)?能否自我修正(Self-Correction)?是否具备异步任务执行能力?

安全合规 (Security & Compliance):考察信任基础。数据驻留(Data Residency)、零留存政策(Zero Retention)、SOC2合规性、以及是否存在隐性的遥测(Telemetry)风险。

开发者体验 (Developer Experience - DX):考察使用摩擦力。延迟(Latency)、内存占用、UI/UX的细腻程度、快捷键的合理性。

成本结构 (Cost Structure):考察TCO。订阅费、按量付费(Token-based)、免费额度的真实价值、企业版溢价。

生态系统 (Ecosystem):考察连接性。插件支持、跨IDE兼容性(VS Code vs JetBrains)、MCP协议支持度。

第三章 交互形态:人机协作界面的重塑

在智能体时代,IDE的界面不再是静态的代码编辑器,而是动态的“对话-生成”画布。

3.1 Cursor:Composer 确立的行业标准

Cursor 之所以能在 2024-2025 年间异军突起,核心在于它通过Composer (Ctrl+I)彻底重构了代码编辑体验。Composer 不再是一个辅佐性的聊天窗口,而是一个浮动的、可拖拽的指令中心,它具备了“上帝视角”的编辑权限。

多文件并发修改:这是 Composer 的杀手锏。开发者输入“将整个项目的日志库从 Log4j 迁移到 SLF4J”,Cursor 能够识别出项目中所有受影响的 Java 文件,并在后台并发生成 Diff(差异)。用户界面上会实时展示多个文件的修改预览,开发者只需通过Tab键一路确认即可。这种体验将大规模重构的效率提升了数倍。

Shadow Workspace:Cursor 的修改并非直接写入磁盘,而是在内存中的“影子工作区”进行。这意味着即使 AI 生成了错误代码,也不会立即污染本地文件,直到用户显式接受。

预测性编辑:Cursor 引入了“Next Action Prediction”,它甚至能预测用户光标的下一次跳转位置,这种细节上的优化极大地增强了流畅感。

3.2 Trae:字节跳动的像素级致敬与微创新

Trae(全称 "The Real AI Engineer")在界面设计上明显致敬了 Cursor,但融入了字节跳动擅长的 C 端产品交互逻辑。

Builder Mode:对标 Composer,Trae 的 Builder 界面更加强调过程的可视化。它会在侧边栏展示一个动态生成的“任务树(Task Tree)”,将用户的模糊指令拆解为“读取文件 -> 分析依赖 -> 生成代码 -> 运行检查”的步骤。这种可视化的思维链(Chain of Thought)在一定程度上缓解了用户等待 AI 生成时的焦虑感。

自适应 Inline Chat:Trae 的行内对话(Cmd+I)设计得更加轻量。不同于 Cursor 需要用户显式通过@引用文件,Trae 宣称具备“自适应上下文”能力,能根据光标所在的函数或类,自动推断需要引用的相关文件。对于不熟悉复杂提示词工程(Prompt Engineering)的初级开发者,这种“傻瓜式”体验更为友好。

3.3 Windsurf:Cascade 流与心流体验

Windsurf 由 Codeium 团队打造,它提出了"Cascade"(级联/瀑布)的交互概念。

流式协作:Windsurf 认为 AI 不应只是“一问一答”,而应是“持续伴随”。Cascade 界面将对话历史、代码 Diff、终端输出和工具调用记录融合在一个线性时间轴中。这种设计模拟了人类结对编程(Pair Programming)的体验——你不仅看到结果,还能看到 AI 的思考过程和尝试路径。

状态感知:Windsurf 在交互中深度集成了“状态感知”。例如,当你在终端运行测试失败时,Cascade 会自动读取报错信息,并在随后的对话中主动建议修复方案,而无需用户复制粘贴报错日志。这种对 IDE 运行态的感知,是 Windsurf 区别于普通插件的核心。

3.4 终端派的复兴:Claude Code 与 Gemini CLI

当图形化 IDE 在做加法时,Claude Code 和 Gemini CLI 选择了做减法,回归终端。

Claude Code 的 Unix 哲学:它没有 GUI,是一个纯粹的 CLI 工具。它将 AI 视为一个 Unix 命令,可以与其他工具组合。例如git status | claude "为这些变更生成 commit message"。它的交互完全基于文本流,输出带有彩色高亮的 Diff,并支持交互式确认。对于习惯 Vim/Emacs 或长期工作在 SSH 远程环境下的后端工程师,这种无干扰的体验极具吸引力。

Gemini CLI 的混合形态:Gemini CLI 既可以独立运行,也作为 VS Code 中 Agent Mode 的后端引擎。它允许用户在 IDE 的终端面板中直接输入自然语言指令(如/yolo fix this bug),工具会自动执行一系列文件读写和测试操作。

第四章 上下文感知:认知的边界

如果说模型智力决定了 AI 能飞多高,那么上下文感知决定了 AI 能走多远。2026年的竞争焦点已从单纯的 Token 数量转向了上下文的质量与结构。

4.1 Cursor:本地索引与显式引用的平衡

Cursor 的上下文机制是目前工程化最成熟的方案。

本地 RAG(Retrieval-Augmented Generation):Cursor 在安装后会对项目进行全量索引,计算 Embeddings 并存储在本地。当用户提问时,它使用 RAG 技术检索最相关的代码块。这种机制在处理中型项目(<10万行代码)时效率极高。

显式引用系统:Cursor 发明了@符号引用系统(@Files,@Folders,@Code,@Docs,@Web)。这种设计承认了现阶段 AI 检索的不完美,赋予开发者手动纠偏的权利。例如,用户可以明确指示“只参考@Utils文件夹下的逻辑”,从而避免 RAG 检索到无关的测试代码。

4.2 Qoder:知识图谱与 Repo Wiki

阿里的 Qoder 走了一条更重的技术路线——结构化知识图谱。

Repo Wiki:Qoder 不仅仅做向量检索,它会尝试理解代码的语义结构(类继承关系、函数调用图、API 依赖链),并生成一份结构化的Repo Wiki(存储在.qoder目录下)。

深层理解:当用户要求“修改订单状态流转逻辑”时,Cursor 可能会检索到含有“Order”关键字的文件,而 Qoder 能通过图谱找到所有继承了OrderState接口的类以及调用了updateStatus方法的服务。这种能力在处理**大型遗留系统(Legacy Systems)**时具有决定性优势,因为这类系统的命名往往不规范,单纯依赖关键字匹配的 RAG 效果很差。

4.3 Gemini CLI:1M Token 的暴力美学

Google 凭借其 TPU 算力优势,推行了Long Context路线。

无限上下文:Gemini 1.5 Pro 提供了 1M 甚至 2M 的 Token 窗口。这意味着对于绝大多数项目,开发者可以将整个代码库(Full Codebase)直接塞入 Prompt,而无需任何 RAG 检索。

优势与代价:这种方法的优势是“全知全能”,彻底消除了 RAG 的漏召回问题。AI 能看到每一个角落的细节,发现极其隐蔽的跨文件 Bug。劣势是延迟(Latency)和成本。处理 1M Token 的首字延迟(TTFT)通常在数秒甚至十秒级别,且如果是 API 计费,单次调用的成本极其高昂。但在 Agent Mode 下,这种“不惜代价求准确”的模式对于解决疑难杂症非常有价值。

4.4 MCP:连接外部世界的桥梁

2025 年下半年,Model Context Protocol (MCP)成为行业标准。这是一个由 Anthropic 倡导的协议,旨在标准化 AI 连接外部数据的方式。

Cursor & Claude Code:作为首批支持者,它们可以通过 MCP 连接到 PostgreSQL 数据库、Linear 工单系统、Sentry 监控平台甚至本地的 Chrome 浏览器历史。

场景革命:这意味着上下文不再局限于代码。开发者可以发出指令:“查看 Sentry ID#12345的报错日志,结合 Linear 上的 PRD 文档,在代码中修复这个问题。”这是 Copilot 时代无法想象的工作流。

第五章 智能体能力:从辅助到自治

我们根据自主性将工具分为三个等级:

L1 (Copilot):基于光标补全,人为主导。

L2 (Co-Executor):人下达指令,AI 执行多步操作,人验收(Cursor Composer)。

L3 (Autonomous Agent):人设定目标,AI 自主规划、执行、验证、修正(Claude Code, Qoder Quest)。

5.1 Qoder Quest Mode:异步开发的先行者

Qoder 是目前L3 级别能力的代表。其Quest Mode引入了异步任务的概念。

Spec-Driven 流程:用户输入模糊需求 -> Qoder 生成详细的 Spec 文档 -> 用户确认 Spec -> Qoder 后台执行。

自我修正:在 Quest 执行过程中,Qoder 会自动运行单元测试。如果测试失败,它会读取报错,修改代码,再次运行测试,直到通过或达到最大重试次数。

Task Report:任务完成后,Qoder 会生成一份详尽的报告,列出修改的文件、通过的测试用例以及遗留的风险点。这种模式非常适合非核心路径的模块开发或繁琐的重构任务(如从 Python 2 迁移到 3)。

5.2 Claude Code:终端里的思考者

Claude Code 引入了"Think"机制,这是其智能体能力的核心。

思维链外显:在执行rm -rf或修改关键配置前,Claude Code 会输出一段“Thinking”日志,解释它为什么要这么做,以及它评估的风险。

权限分级:Claude Code 将操作分为“安全”(读取文件)和“危险”(修改文件、执行命令)。对于危险操作,它可以配置为“请求批准”或“自动执行”。其“Ultrathink”模式会分配更多的算力预算进行深度规划,适合处理架构级问题。

5.3 Windsurf Cascade:人机协同的流

Windsurf 的 Cascade 处于L2.5的位置。它具备多步执行能力,但设计上更倾向于让开发者保持在循环中(Human-in-the-loop)。

工具调用:Cascade 可以熟练调用grep、find等工具探索代码库。

状态感知:它能感知用户的焦点变化。如果用户在 AI 生成代码时打开了一个新文件,Cascade 会自动将这个新文件纳入上下文,并调整生成逻辑。这种“随动”的智能体体验比 Qoder 的“撒手不管”更适合复杂的、需要频繁人工判断的核心业务开发。

第六章 安全合规:信任的危机与重构

随着 AI 深入代码核心,安全与隐私成为企业选型的“一票否决项”。

6.1 Trae:免费背后的隐私风暴

尽管Trae提供了免费的 GPT-4o 服务,但多项独立技术分析揭示了其背后的数据风险:

隐形遥测:网络抓包分析显示,即使在 Trae 设置中关闭了“Telemetry”选项,其后台进程依然会向字节跳动关联的域名(如byteoversea.com)发送加密数据包。这些数据包包含设备指纹(Machine ID)、使用时长及操作频率等元数据。

代码上传:其隐私政策明确指出,为了实现“智能补全”和“自适应上下文”,代码文件会被上传至云端进行 Embeddings 计算。尽管声称会删除明文,但在地缘政治紧张的背景下,代码特征向量的离境传输本身就是巨大的合规漏洞。

长效留存:隐私条款中提到数据可能保留长达 5 年,且可能与关联公司共享用于“研发”。这意味着用户的代码逻辑可能被用于训练字节跳动的下一代模型。

6.2 训练豁免权 (Opt-out) 与数据主权

Cursor:提供了清晰的Privacy Mode。开启后,数据仅在传输过程中存在(用于推理),不落盘,不训练。Cursor 拥有 SOC 2 Type II 认证,这是企业采购的基准线。

GitHub Copilot:作为微软系产品,其Copilot Enterprise版本提供了最完善的 IP 赔偿条款(Indemnification)。如果 AI 生成的代码侵犯了第三方版权,微软承诺承担法律责任。这对于世界 500 强企业是极重要的法律保障。

Qoder:其服务条款(ToS)引发了开源社区的争议。部分条款暗示平台可能对生成的 Output 拥有某种形式的权利,或要求用户放弃某些道德权利。在用于开源项目时需额外谨慎。

第七章 开发者体验 (DX) 与性能基准

7.1 延迟 (Latency) 与性能

Cursor:在代码补全速度上表现最优,平均延迟约187ms。其自研的cursor-small模型在本地进行初筛,极大降低了对云端大模型的依赖,保证了跟手感。

Trae:虽然模型强大,但延迟较高(约243ms)。此外,Trae 的内存占用显著高于竞品(空闲时 920MB vs Cursor 680MB),这可能与其后台运行的重型索引及遥测进程有关。

Windsurf:基准测试显示其 Cascade 响应速度在 1.8s 左右,优于 Cursor 的 2.1s(针对复杂任务),但在单行补全上略逊。

Claude Code:由于是 CLI 工具且依赖 API,其响应速度完全取决于 Anthropic API 的状态,且缺乏流式输出的视觉平滑感。

7.2 UI/UX 的细腻度

Windsurf:UI 设计被誉为“最现代化的”。其 Cascade 界面不仅美观,还通过不同颜色的高亮区分了“思考”、“执行”、“输出”和“错误”,信息密度高而不乱。

Cursor:虽然功能强大,但其Ctrl+K快捷键默认劫持了终端的清屏命令,这一细节经常激怒习惯 Linux 终端的资深开发者。

Trae:界面动效华丽,但有些过度设计(Over-engineered),例如 Builder 模式的动画在长任务中显得拖沓。

第八章 成本结构与生态系统

8.1 成本模型:从订阅制到积分制

2026年的计费模式变得更加多元和复杂。

| 工具 | 计费模式 | 价格 | 隐形限制/备注 |

| Cursor | 订阅制 (Subscription) | $20/月 (Pro) | 清晰透明。包含 500 次快速 GPT-4o 请求,无限次慢速请求。是目前的行业基准。 |

| Trae | 免费 (当前) | $0 -> $10/月 | 当前完全免费是其最大诱惑,但未来 Pro 版定价 $10/月。现在的免费是以隐私为代价的“数据换算力”。 |

| Windsurf | 积分制 (Flows) | $15/月 | 引入了 "Flows" 概念。Pro 版包含有限的 Flows,对于重度 Agent 用户,可能比 Cursor 更贵,但入门门槛低。 |

| Qoder | 积分制 (Credits) | $20-$200/月 | 最复杂的计费。Quest 模式消耗 Credits 极快。企业可能需要购买额外的算力包。 |

| Claude Code | 混合 (Sub/API) | Pro订阅含CLI | 推荐通过 Claude Pro ($20/月) 使用。若通过 API Key 直连,重度使用的日成本可达 $5+,月成本易超 $150。 |

| Gemini CLI | Pay-as-you-go | 免费额度高 | Google 提供每日 1000 次免费请求(包含 1M 上下文),对于学生和独立开发者是性价比之王。 |

8.2 生态系统:插件与 OS 兼容性

VS Code 派系:Cursor, Trae, Windsurf 均为 VS Code 分支。它们天然兼容 VS Code 市场数万个插件,这使得迁移成本极低。

JetBrains 派系:GitHub Copilot 和 Qoder 提供了 JetBrains 插件。对于 Java/Kotlin 重度用户,这是唯二的选择。Cursor 目前无法支持 IntelliJ。

OS 支持:Trae 目前对 Windows/Mac 支持较好,Linux 支持滞后。Claude Code 和 Gemini CLI 作为命令行工具,天然支持全平台,包括无头服务器(Headless Servers)。

第九章 综合对比与决策矩阵

9.1 全维对比表

| 评估维度 | Cursor | Trae | Windsurf | Qoder | Claude Code | Gemini CLI | GitHub Copilot |

| 交互形态 | Composer (标杆) | Builder (仿效) | Cascade (流式) | Quest (异步) | CLI / Chat | CLI / Agent | Inline / Chat |

| 上下文感知 | Indexing + RAG | Auto-Adaptive | Deep Context | Repo Wiki | File-based | 1M+ Token | Standard |

| 模型能力 | Claude 3.5 / o1 | GPT-4o / Claude | Cascade Models | Multi-Model | Sonnet 3.7 | Gemini 1.5 | GPT-4o / Claude |

| 智能体能力 | Agent Mode (L2) | Builder (L2) | Cascade (L2.5) | Quest (L3) | Think (L3) | Agent Mode (L2) | Workspace (L1.5) |

| 安全合规 | SOC2 / Privacy | 合规风险 | SOC2 | ToS 争议 | Enterprise | Google Cloud | 企业级标杆 |

| 开发者体验 | 极低延迟 | 动效佳/高内存 | 心流体验佳 | 学习曲线陡 | 极客首选 | 功能导向 | 稳定集成 |

| 生态支持 | VS Code Fork | VS Code Fork | VS Code Fork | JetBrains | Terminal / MCP | Terminal / GCP | 全 IDE 支持 |

| 成本 | $20/月 | 免费 (短期) | $15/月 | 积分制 | 含在 Pro 中 | 高免费额度 | $10/月 |

9.2 场景化选型指南

场景 A:初创公司全栈开发 (Greenfield Startup)

推荐:Cursor。 理由:Composer 的多文件编辑能力能极大加速原型开发(Prototyping)。初创公司通常没有复杂的历史包袱,Cursor 的 RAG 索引足以应对。$20 的成本相对于人力成本可忽略不计。

场景 B:大型企业遗留系统维护 (Legacy Enterprise Monorepo)

推荐:Windsurf或Gemini CLI。 理由:Windsurf 的深度状态感知能更好理解复杂的上下文;如果项目超大,Gemini 的 1M 上下文是唯一能“一次性读懂”整个模块的工具。需配合 Copilot Enterprise 解决合规问题。

场景 C:DevOps 与 运维自动化

推荐:Claude Code。 理由:直接在服务器终端运行,结合 MCP 连接云资源,能够半自动地处理部署脚本、排查日志。其“Think”模式在执行高危命令时提供了必要的安全阀。

场景 D:学生/个人学习/非敏感项目

推荐:Trae+Gemini CLI。 理由:Trae 提供免费的顶级模型(GPT-4o)用于生成代码,Gemini CLI 提供免费的长上下文用于阅读源码。零成本组合,但需注意不要上传个人隐私数据。

场景 E:Java/IntelliJ 重度用户

推荐:Qoder(Plugin) 或GitHub Copilot。 理由:无法脱离 JetBrains 环境。Qoder 的 Quest 模式可以作为 IDE 的有力补充,处理繁琐的样板代码生成。

结论与展望:从 Vibe Coding 到 Spec Engineering

2026年,AI 编程工具的竞争已经超越了“谁的模型更聪明”,进入了“谁更懂工作流”的深水区。

OpenAI 的 Andrej Karpathy 提出的"Vibe Coding"(氛围编程)正在成为现实——开发者不再关注具体的语法细节(Syntax),而是关注代码的功能流向和整体感觉。Cursor 赢在让修改变得像“魔法”一样快;Qoder 和 Claude Code 则试图将这种“感觉”标准化为Spec(规格)。

未来的开发者,将越来越像产品经理和QA(质量保证)的结合体。我们负责定义目标(Spec),AI 负责实现(Implementation),我们负责验收(Review)。在这个范式转移中,工具的选择不仅仅是购买一个软件,而是选择一种未来的工作方式。

对于企业而言,合规与安全将始终是悬在头顶的达摩克里斯之剑。在享受 AI 带来的 10 倍效率提升时,必须清醒地认识到数据主权的重要性。

注:本报告基于截至 2026 年 1 月的公开数据、技术文档及社区反馈整理。工具特性及定价可能随版本迭代发生变化。

《AI 巨头录》看局,《AI 先锋志》看人,《AI 进化策》看招。

扫码关注,构建属于你的 AI 认知闭环。