“氛围编程(Vibe Coding)”没有杀死开源,但它会先一步杀死程序员的学习能力.

- 2026-02-05 00:43:22

前几天聊到 Vibe Coding 正在掏空开源社区(氛围编程“杀死”开源)。

有人不服,觉得这是危言耸听:

代码反正是 AI 写的,效率高就行了。

就在刚刚,Anthropic 最新发布的研究给这句话补上了残酷的后半句:

AI 用得越顺,开发者对技术的理解反而越浅,甚至产生幻觉:代码能跑=我学会了。

这份研究的主题为“How AI assistance impacts the formation of coding skills”,旨在深入评估 AI 编程工具(例如 Claude)对开发者技能形成的影响。研究利用随机对照试验,对比了使用 AI 与手动编码两类开发者在学习新技术时的表现差异。

此次研究邀请了 52 名软件工程师(大部分是初级),要求他们学习一个 Python 异步库(Trio),并完成编码任务。参与者被随机分配到:

- AI 辅助组:可随时调用 AI 生成代码。

- 手动组:只能自己编写代码。

之后所有人参加一份覆盖调试、代码阅读、代码编写与概念理解的测验。

研究主要发现如下:

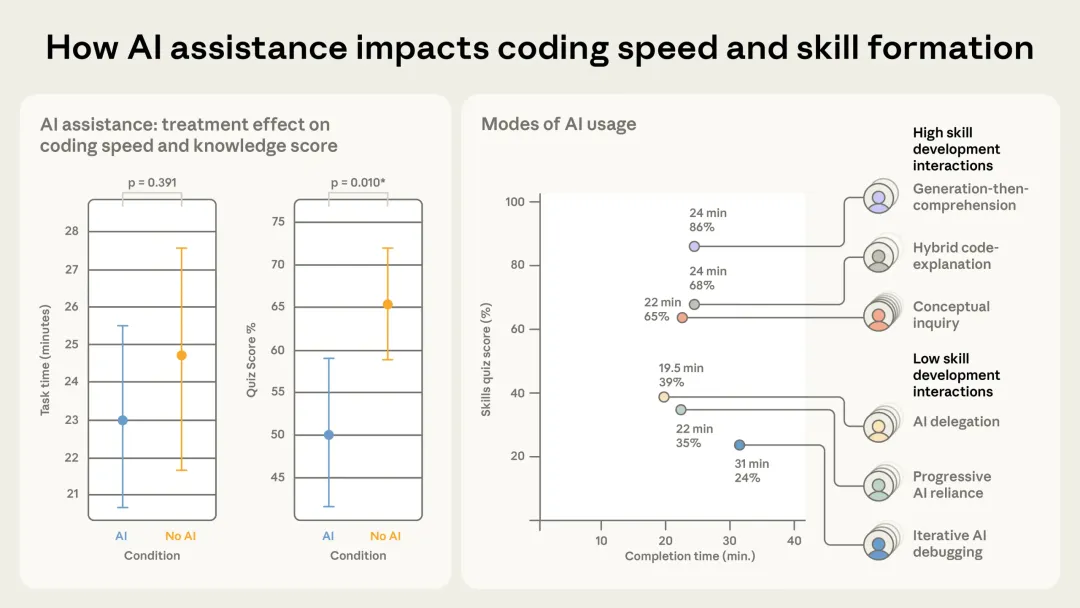

技能掌握显著下降。使用 AI 的开发者平均测验成绩比手动编码者低约 17%(近两级字母成绩差),尤其是在调试和概念理解部分差距最大。

AI 编程工具的效率提升有限。虽然 AI 组完成任务略快,但并未达到统计学上的显著效率提升。

AI 互动方式影响学习成果。与单纯让 AI 写代码相比,那些在生成后请求解释、主动提问概念的开发者成绩更高,说明“与 AI 合作的方式”决定了是否能真正学习。

简而言之,主动要求 AI 解释代码、反复追问原理的人,成绩明显更好;把 AI 当“外包程序员”的人,学得最差。

研究最后对 AI 辅助编程的普及提出了重要反思:AI 并非自动等同于技能提升。

研究指出:

认知卸载(cognitive offloading)是核心问题 —— 当开发者依赖 AI 自动生成代码时,会减少自身对错误原因、代码结构和概念逻辑的思考。

即便 AI 能减少重复劳动,但在学习新工具和构建深入理解方面可能适得其反。

Anthropic 认为,随着企业逐渐增加 AI 生成代码的比例,初级开发者可能面临技能发育不良的风险,进而失去审查和验证 AI 代码的能力;建议管理者应审慎规划大规模部署 AI 工具,并考虑如何通过系统或有意为之的制度设计,确保工程师在工作中持续学习,从而能够对他们构建的系统进行有效的监督。

Anthropic 强调,此研究并非否定 AI 的价值,而是提示业界需关注人机协作中的长期人才培养问题,未来的 AI 工具设计也应更多考量如何兼顾效率与教育功能。

论文:https://arxiv.org/abs/2601.20245v1