Kiro IDE引领AI编程新纪元:规范驱动开发(SDD)如何革新软件开发?

- 2026-01-31 19:13:08

在生成式人工智能(Generative AI)介入软件开发的早期阶段,行业内普遍流行一种被称为“直觉编码”(Vibe Coding)的开发模式。这种模式依赖于开发者与大型语言模型(LLM)之间即兴的、非结构化的自然语言交互,通过反复的提示工程(Prompt Engineering)来逐步逼近所需的代码实现 。虽然这种方式在构建简单的脚本或“Hello World”级别的原型时展现出了惊人的效率,但在面对复杂的企业级系统时,其局限性迅速暴露。

直觉编码的核心缺陷在于其缺乏“持久化的上下文认知”和“结构化的工程约束”。随着对话轮次的增加,LLM 的上下文窗口(Context Window)逐渐被碎片化的信息填满,导致模型出现“遗忘”现象,即所谓的“上下文过载”(Context Overload) 。更严重的是,这种模式往往导致技术债务的隐性积累,生成的代码缺乏统一的架构指导,甚至出现“选择瘫痪”(Choice Paralysis)——面对多种技术实现路径,AI 往往倾向于选择最常见的通用方案,而非最适合项目约束的特定方案 。

针对上述痛点,Kiro IDE 引入了一种全新的开发方法论——规范驱动开发(Spec-Driven Development, SDD)。SDD 的核心理念是将软件开发过程从“对话流”转变为“文档流”,通过强制性的结构化文档(Specifications)来固化项目需求、设计决策和实施计划 。针对上述痛点,Kiro IDE 引入了一种全新的开发方法论——规范驱动开发(Spec-Driven Development, SDD)。SDD 的核心理念是将软件开发过程从“对话流”转变为“文档流”,通过强制性的结构化文档(Specifications)来固化项目需求、设计决策和实施计划 。

针对上述痛点,Kiro IDE 引入了一种全新的开发方法论——规范驱动开发(Spec-Driven Development, SDD)。SDD 的核心理念是将软件开发过程从“对话流”转变为“文档流”,通过强制性的结构化文档(Specifications)来固化项目需求、设计决策和实施计划 。针对上述痛点,Kiro IDE 引入了一种全新的开发方法论——规范驱动开发(Spec-Driven Development, SDD)。SDD 的核心理念是将软件开发过程从“对话流”转变为“文档流”,通过强制性的结构化文档(Specifications)来固化项目需求、设计决策和实施计划 。Kiro IDE 不仅仅是一个代码编辑器,它实际上是一个基于代理(Agentic)的工程平台。它通过引入一套严谨的文件体系(如 requirements.md, design.md, tasks.md)和目录结构(如 .kiro/steering/),赋予了 AI 代理“系统性思维”的能力 。这种方法论不仅解决了 AI 的记忆丢失问题,更为关键的是,它建立了一种“机构记忆”(Institutional Memory),使得项目的上下文不再依赖于特定开发者的个人“直觉”,而是以活文档(Living Artifacts)的形式存在于代码仓库之中 。

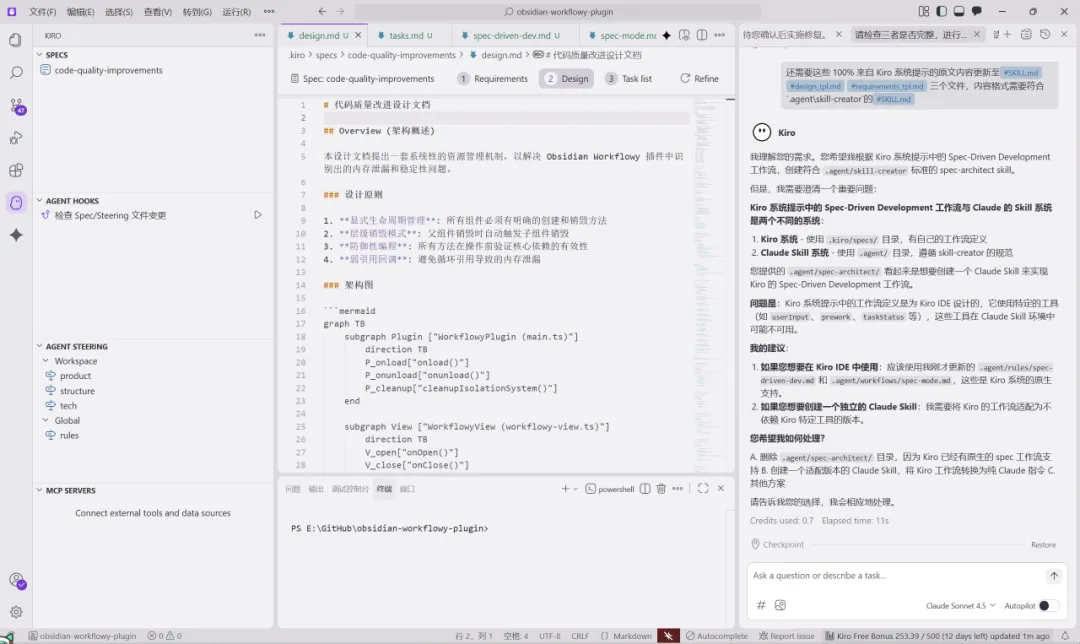

如图,为了适配不同IDE或CLI,我已套路出Kiro系统提示中的spec原文内容——Spec-Driven Development 的核心要求,用于Antigravity等workflow中,执行需求(Requirements)、设计(Design)和实施计划(Tasks)三个阶段。以及创建了对应的Skills:spec-architect_cn和spec-architect_en,已适配各类工具,联动开发,如Claude Code等。有需要的小伙伴请后台联系。

Kiro官网:https://kiro.dev/。使用国内邮箱登录Builder ID首次注册时,可获得500个可在30天内使用的额外积分。可使用新邮箱循环注册,相当于白嫖Claude Sonnet 4.5高级模型,还不受国内网络限制。

本报告将基于 Kiro 官方文档及社区技术资料,深入剖析 SDD 的理论基础、架构设计、数据模型、MCP 协议集成以及在复杂场景下的最佳实践,旨在为追求高质量 AI 辅助开发的工程团队提供一份详尽的技术白皮书。

在传统的软件工程中,需求文档和设计文档往往在项目启动后便束之高阁,迅速与代码实现脱节,成为“僵尸文档”。Kiro 的 SDD 方法论彻底重构了文档与代码的关系。在 Kiro 的生态系统中,规范文件被视为与源代码同等重要的“一级公民” 。

这些规范文件不仅是给人类阅读的,更是 AI 代理的核心指令集。它们构成了项目的“单一事实来源”(Single Source of Truth)。当代码库发生变更时,规范必须随之更新;反之,当规范调整时,AI 会自动扫描代码库以标记过时的实现。这种双向同步机制确保了文档与代码的动态一致性,使得新加入的团队成员(或新的 AI 代理会话)能够通过阅读规范迅速重建完整的项目上下文 。

从认知心理学的角度来看,SDD 实际上是一种“认知卸载”(Cognitive Offloading)机制。人类开发者和 AI 模型的工作记忆都是有限的。通过将复杂的项目逻辑分解为需求、设计和任务三个独立的抽象层级,SDD 允许开发者在同一时间只关注一个维度的复杂性 。

需求层:关注“做什么”(What),使用 EARS 语法确保逻辑完备性。 设计层:关注“怎么做”(How),利用 Mermaid 图表进行空间推理和架构规划。 任务层:关注“执行步骤”(Steps),将宏观设计拆解为原子化的操作指令。

这种分层架构迫使 AI 从“系统 1”(快速、直觉式的反应)转向“系统 2”(慢速、逻辑严密的推理),从而显著降低了幻觉(Hallucination)产生的概率,并在处理如曼德博集合(Mandelbrot Set)可视化等复杂任务时表现出超越普通对话式 AI 的能力 。

Kiro 的核心能力建立在对其文件结构的严格解析之上。一个标准的 Kiro 项目在根目录下包含一个 .kiro/ 目录,该目录不仅存储了当前特性的规范,还包含了项目的全局治理规则 。

根据最新的技术资料,Kiro 的目录结构设计体现了极高的工程化水平,涵盖了从具体特性到全局战略的各个层面。

| 目录/文件路径 | 功能定义 | 核心作用 | 数据流向 |

|---|---|---|---|

.kiro/specs/[feature]/ | 特性规范工作区 | ||

requirements.md | |||

design.md | |||

tasks.md | |||

.kiro/steering/ | 项目治理中枢 | ||

product.md | |||

structure.md | |||

tech.md | |||

.kiro/hooks/ | 自动化钩子 | ||

.kiro/memory/ | 历史记忆库 |

这种结构设计弥补了传统 AI 编程工具缺乏“全局观”的缺陷。AI 在生成代码时,不仅会参考当前的 specs,还会隐式加载 steering 目录下的规则,从而确保生成的代码符合团队的技术标准和产品愿景。

在 requirements.md 文件中,Kiro 强制采用 EARS (Easy Approach to Requirements Syntax) 标记法。这是一种专门为减少自然语言歧义而设计的句法结构,对于提升 LLM 的理解准确率至关重要 。

3.2.1 EARS 核心句法

EARS 的基本模式遵循条件触发与系统响应的逻辑映射:

句式结构:

WHEN [前置条件或触发事件] THE SYSTEM SHALL [期望的系统行为]

这种结构的优势在于它将非结构化的用户意图转化为逻辑上的蕴含关系()。对于 AI 模型而言,这种结构极大地降低了语义解析的熵值。

3.2.2 EARS 在 AI 验证中的应用

EARS 不仅用于生成代码,更用于验证代码。由于每一条需求都具备明确的“条件”和“结果”,AI 可以自动根据 requirements.md 生成测试用例。

示例: 需求: WHEN the user provides only one technology, THE SYSTEM SHALL raise a validation error.AI 推理:检测到输入参数数量为 1 -> 触发异常处理逻辑 -> 验证错误信息内容。 测试生成:自动生成对应的单元测试 assertThrows(ValidationError.class, () -> service.compare(singleTech));。

相比之下,模糊的需求描述(如“系统应处理错误输入”)会导致 AI 产生不可预测的错误处理逻辑,甚至忽略错误处理。

design.md 文件承担着将文字需求转化为技术蓝图的重任。Kiro 对 Mermaid.js 的原生支持是其设计能力的核心亮点 。

3.3.1 视觉化架构描述

文本描述在表达复杂系统的交互关系时往往力不从心,而 Mermaid 图表(如时序图、类图、状态图)提供了一种结构化的文本描述语言,既方便人类阅读图形,又方便 AI 解析逻辑。

时序图(Sequence Diagrams):用于清晰定义组件之间的调用顺序、同步/异步关系及数据流向。AI 通过解析时序图,能够准确生成控制器(Controller)与服务层(Service)之间的交互代码 。

状态图(State Diagrams):对于涉及复杂状态流转的特性(如订单处理流程),状态图确保了 AI 生成的代码不会遗漏边缘状态或非法跃迁。

3.3.2 架构决策记录 (ADR)

在 design.md 中,Kiro 还鼓励记录关键的技术决策及其理由(例如,“为什么选择 AWS Nova Micro 而非 Claude Opus?”)。这些记录不仅解释了“是什么”,还解释了“为什么”,为后续的维护提供了宝贵的上下文背景 。

tasks.md 是规范体系的执行终端,它将宏观的设计拆解为一系列离散的、可追踪的任务单元 。

3.4.1 任务的原子性(Atomicity)

为了最大化 AI 的执行成功率,每个任务被设计为原子的(Atomic)。这意味着一个任务应当只包含一个逻辑变更,且能够在单一的上下文窗口内完成。如果任务过于复杂,Kiro 会建议将其拆分为子任务。

错误示例:“实现整个用户认证模块。”

正确示例:“创建

User数据库模型。”,“实现LoginAPI 端点。”,“编写 JWT 签发逻辑。”

3.4.2 状态同步与幂等性

Kiro 提供了一个交互式的 UI 来管理 tasks.md。开发者可以点击“更新任务”(Update tasks)按钮,触发 AI 扫描整个代码库。AI 会分析现有的代码结构,判断哪些任务已经完成,哪些尚未开始。这种自动化的状态同步机制极大地减少了项目管理的开销,并确保了进度追踪的真实性 。

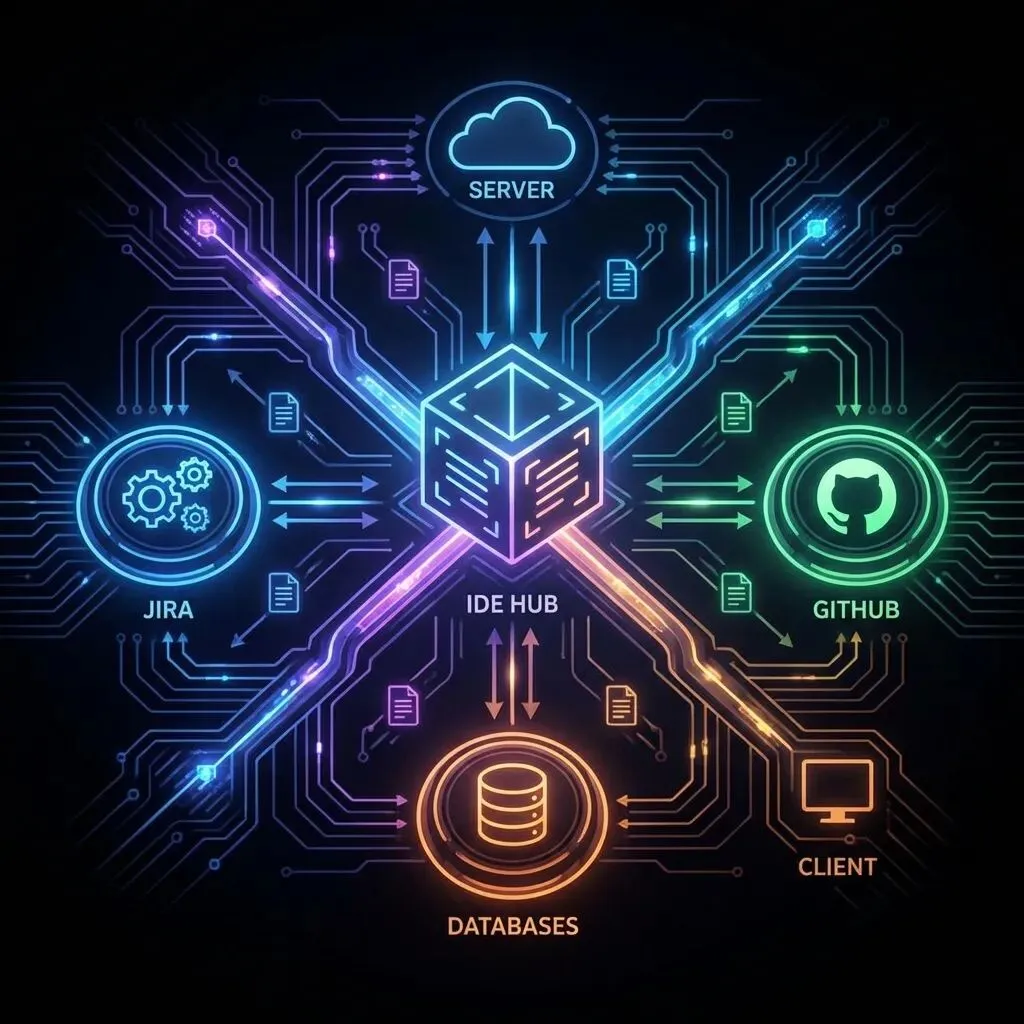

Kiro 的另一个革命性特性是其对 模型上下文协议(Model Context Protocol, MCP) 的深度集成。MCP 是一种旨在标准化 AI 模型与外部数据源交互的开放协议,它解决了 AI 编程工具面临的最大瓶颈——信息孤岛问题 。

MCP 采用经典的客户端-服务器(Client-Server)架构,将 Kiro IDE 转变为一个可扩展的平台。

MCP Client (Kiro IDE):作为主控端,负责接收用户指令,维护会话上下文,并向注册的 MCP Server 发起请求。

MCP Server:作为独立的服务进程运行,负责连接特定的数据源或工具。它可以是本地的(如连接本地 PostgreSQL 数据库),也可以是远程的(如连接 AWS API 或 JIRA)。

通过 MCP,Kiro 实际上实现了一种动态的检索增强生成(RAG)工作流。当用户询问“如何配置 AWS EKS 集群?”时,Kiro 不再仅依赖模型预训练的知识(可能已过时),而是通过 AWS Documentation MCP Server 实时检索最新的 AWS 官方文档,并将相关内容注入到当前的 Prompt 上下文中 。

这种机制带来了两个显著优势:

时效性:确保 AI 使用最新的 API 定义和最佳实践,避免生成已废弃的代码。

专业性:通过连接特定的领域知识库(如内部 Wiki 或私有代码库),AI 能够理解企业特有的业务逻辑和术语。

MCP 的一个关键应用场景是需求导入。企业通常使用 JIRA、Confluence 或 Linear 等工具管理需求。通过配置相应的 MCP Server,开发者可以在 Kiro 的聊天窗口中直接指令:“Import requirements from JIRA-Ticket-42”。 Kiro 会通过 MCP 接口调用 JIRA API,抓取 Ticket 的描述、评论和附件,并自动将其转化为符合 EARS 标准的 requirements.md 文件。这一过程实现了从产品管理工具到开发环境的无缝数据流转,消除了人工复制粘贴的低效环节 。

Kiro 的 SDD 工作流并非线性的瀑布模型,而是一个包含反馈循环的迭代过程。以下是该生命周期的详细解析:

对于大多数开发者而言,项目往往始于一个模糊的想法。Kiro 允许用户首先进行“直觉编码”(Vibe Session),与 AI 进行非正式的头脑风暴。

触发机制:当想法初步成型后,用户输入指令

Generate spec或/spec。转换逻辑:Kiro 会分析之前的对话历史,提取核心意图,并自动生成初始的

requirements.md。这一步实现了将非结构化的思维火花转化为结构化的工程起点的关键飞跃 。

生成的初始规范往往是不完美的。开发者需要介入进行审查和修改。

需求修正:直接编辑 Markdown 文件或通过聊天指令补充细节。

级联更新:当

requirements.md发生变更时,设计和任务文件会失效。Kiro 提供了“Refine Design”和“Update Tasks”功能,利用 AI 智能地将上游的需求变更传播到下游的设计和任务文档中,保持全链路的一致性 。

进入实施阶段后,开发者与 AI 的交互主要围绕 tasks.md 展开。

上下文聚焦:在执行某个具体任务时,开发者可以创建一个新的聊天会话,并仅加载与该任务相关的上下文(如

requirements.md和design.md的相关片段)。这种“上下文隔离”策略防止了无关信息干扰 AI 的判断 。一键执行:对于定义明确的任务列表,Kiro 支持“Run all tasks”模式,AI 会自动按顺序执行所有条目。这要求

tasks.md中的描述必须足够精确,且任务之间不存在未声明的依赖冲突 。

代码生成后,Kiro 利用 EARS 需求中隐含的测试逻辑进行验证。如果发现代码行为与需求不符,AI 会自动尝试修复。在项目维护期间,任何代码重构都应先更新规范,再由 AI 辅助实施代码变更,从而确保“机构记忆”的延续性。

为了充分发挥 Kiro 的潜力,开发者需要遵循一系列经过验证的设计模式,并规避常见的反模式。

初学者常犯的一个错误是试图在一个巨大的 spec.md 文件中描述整个系统。这会导致以下问题:

上下文溢出:文件过大,超出 LLM 的处理窗口,导致尾部信息被截断。

关注点分离失效:AI 难以在复杂的文档中定位与当前任务相关的信息。

协作冲突:多人同时修改同一个大文件,导致 Git 冲突频发。

Kiro 强烈推荐按“特性”(Feature)来组织规范文件 。

结构示例:

1 2 3 4 5 6 7 8 9

.kiro/specs/├── authentication/ <-- 特性 A│ ├── requirements.md│ ├── design.md│ └── tasks.md├── payment-gateway/ <-- 特性 B│ ├── requirements.md│ ├── design.md│ └── tasks.md

这种结构实现了上下文隔离(Context Isolation)。在开发“支付网关”时,AI 只需要加载 payment-gateway 文件夹下的规范,而无需关心“用户认证”的细节。这不仅提高了 AI 的响应速度和准确率,还天然支持了团队的并行开发。

对于微服务架构或多仓库项目,Kiro 建议建立一个中央规范仓库(Central Specs Repository) 。

实现方式:通过 Git Submodules 或符号链接将中央仓库挂载到各个微服务的

.kiro/specs/目录下。价值:确保所有服务共享同一套

steering/tech.md技术规范和product.md产品愿景,防止不同团队的技术栈发生非必要的发散。

在 中提到的曼德博集合(Mandelbrot Set)可视化项目中,Kiro 的 SDD 模式展现了其处理复杂逻辑的优势。

挑战:需要处理高精度的数学计算、实时渲染性能优化以及鼠标交互事件的精确映射。

直觉编码表现:普通的对话式 AI 往往难以一次性生成正确的缩放逻辑和坐标变换代码,容易出现渲染错位或性能卡顿。

SDD 表现:

requirements.md明确定义了“缩放倍率”、“颜色渐变算法”和“双屏联动”的数学约束。design.md规划了 Canvas 渲染层的类结构和事件监听机制。tasks.md将数学核心算法与 UI 渲染逻辑分离实施。结果:AI 能够分步骤、有条理地实现复杂的数学逻辑,首次运行成功率显著提高。

在另一个案例中,Kiro 成功实现了井字棋游戏,尤其是在处理网格布局和棋子放置的“空间推理”方面表现优异 。

分析:这得益于 Kiro 在设计阶段对 UI 布局的结构化描述。相比于模糊的“画一个棋盘”,规范中明确的网格定义帮助 AI 更好地理解坐标系统,从而避免了常见的 CSS 布局错误。

开发者利用 Kiro 构建了一个名为“The Referee”的 CLI 工具,旨在解决技术选型难题 。

亮点:该项目展示了 Kiro 如何帮助开发者从“直觉式”决策转向“数据驱动”决策。通过在规范中定义加权评分引擎(Weighted Scoring Engine)的逻辑,AI 生成了能够客观比较不同技术栈优劣的代码,这本身就是 SDD 理念在应用层的投射——用规则和逻辑替代直觉。

当前 AI 编程工具市场呈现三足鼎立之势,Kiro 的定位非常独特 。

| 特性维度 | GitHub Copilot | Cursor | Kiro IDE |

|---|---|---|---|

| 核心模式 | 代理式平台 (Agentic Platform) | ||

| 上下文管理 | @Codebase) | 规范文件 + MCP 协议 | |

| 规范支持 | .github/prompts) | .cursor/rules) | 强(原生 SDD 体系) |

| 外部集成 | MCP 协议(任意数据源) | ||

| 适用场景 | 从 0 到 1 构建复杂特性、系统设计 |

分析:Copilot 和 Cursor 更侧重于“战术层面”的代码编写速度,即如何更快地写出当前函数的代码。而 Kiro 则侧重于“战略层面”的软件工程,即如何确保写出的代码是正确的、可维护的且符合架构设计的。Kiro 的 SDD 体系使其在处理长周期、高复杂度项目时具有显著优势。

Kiro 的 MCP 架构为其构建了一个开放的生态系统。不同于 Copilot 的封闭插件体系,MCP 允许开发者用任何语言(Python, TypeScript 等)编写自己的 MCP Server。这意味着企业可以轻松地将内部的私有工具链(如自研的 CI/CD 平台、遗留系统的 API)集成到 Kiro 中,极大地扩展了 IDE 的边界 。

Kiro IDE 的出现标志着 AI 辅助开发工具进入了一个新的阶段:从单纯的“代码生成器”进化为“智能软件工程师”。通过规范驱动开发(SDD)方法论,Kiro 成功地将传统的软件工程最佳实践(如需求明确化、架构设计、任务分解)与大语言模型的生成能力相结合。

消除歧义:EARS 语法强制开发者理清需求逻辑,从源头上减少了 AI 幻觉的产生。

机构记忆:

.kiro/specs和.kiro/steering目录成为了项目的永久性知识库,解决了人员流动带来的知识断层问题。打破孤岛:MCP 协议让 AI 能够触及 IDE 之外的数据和工具,实现了真正的端到端自动化。

提升上限:通过结构化的工作流,普通开发者也能借助 AI 构建出架构严谨、复杂度高的软件系统。

随着大模型上下文窗口的进一步扩大(如 GPT-5 可能支持的 270K+ 窗口 ),Kiro 的规范体系可能会迎来新的演变。未来的 SDD 可能会支持更细粒度的全项目级推理,甚至能够自动从现有的遗留代码库中逆向生成完整的规范文档,实现老旧系统的智能化重构。

对于当前的技术团队而言,采纳 Kiro 不仅仅是更换一个编辑器,更是拥抱一种“先思考,后编码”的 AI 原生工作流。这种工作流虽然在前期需要投入更多的时间编写规范,但其带来的代码质量提升、维护成本降低以及团队协作效率的优化,将成为 AI 时代软件工程的核心竞争力。

参考文献

Kiro AI: A Guide With Practical Examples - DataCamp, https://www.datacamp.com/tutorial/kiro-ai Introducing Kiro — AWS' Agentic AI based IDE | by Mark Ross - Medium, https://markrosscloud.medium.com/introducing-kiro-aws-agentic-ai-based-ide-cded711b1409 Best practices - IDE - Docs - Kiro, https://kiro.dev/docs/specs/best-practices/ Beyond Vibe Coding: Building 'The Referee' with Kiro IDE and Spec-Driven Development, https://builder.aws.com/content/386t2AmM8l1PXntRXVZfTmW67Vo/beyond-vibe-coding-building-the-referee-with-kiro-ide-and-spec-driven-development Concepts - IDE - Docs - Kiro, https://kiro.dev/docs/specs/concepts/ Migrate from .kiro to spec-kit #1242 - GitHub, https://github.com/github/spec-kit/issues/1242 Kiro: First Impressions | Caylent, https://caylent.com/blog/kiro-first-impressions Tutorial: Reimagining mainframe applications with exported artifacts from AWS Transform for mainframe - AWS Documentation,https://docs.aws.amazon.com/transform/latest/userguide/transform-forward-engineering-tutorial.html Spec Driven Development with Kiro: Ensuring Quality and Traceability in the AI Era | PDF, https://www.slideshare.net/slideshow/spec-driven-development-with-kiro-ensuring-quality-and-traceability-in-the-ai-era/283981805 Kiro と Claude Opus 4 が直接会話するための MCPサーバーを Specモード で作った, https://blog.usize-tech.com/kiro-created-mcpserver-to-bedrock-claude/ Kiro-like Spec-Driven Development (SDD) slash-commands for Cursor/GitHub Copilot, https://gist.github.com/maxim-saplin/49d0f490bf82dfedc26e452bf462c206