【微软开源】12.6K star,零代码改造,别再死磕提示词了:用强化学习点亮你的 Agent

- 2026-02-05 00:38:43

Optimize ANY agent with ANY framework.

💡 为什么需要 Agent Lightning?

1. 现状:能干活,但不“长本事”

绝大多数 Agent,都是“静态”的。

2. 强化学习:理论上很香,工程上很难

状态 (State):当前上下文、历史对话、工具返回结果等。 动作 (Action):LLM 生成的回复、调用的工具、选择的策略等。 奖励 (Reward):任务是否成功、答案是否正确、用户是否满意等。

现有的 RL 框架,大多是给“单轮任务”设计的(比如数学题、文本对齐),而 Agent 是多轮、多工具、多智能体协作的复杂系统。

3. Agent Lightning 的诞生:把“训练”和“执行”拆开

既然 Agent 框架和 RL 框架互相看不顺眼,那干脆把它们拆开,中间加一层“翻译官”。

训练和执行完全解耦:Agent 还是用你熟悉的 LangChain、AutoGen 等框架写,照常跑业务。训练部分交给 Lightning Server,通过标准接口拉取任务、回传数据,完全不影响 Agent 的运行逻辑。 统一数据接口:把 Agent 的一次执行抽象成标准的 (State, Action, Reward) 轨迹,不管你内部是多复杂的编排,对 RL 来说都是一样的输入。 分层强化学习算法 (LightningRL):先给整条轨迹打个分,再合理分配到每一步,最后用成熟的单轮 RL 算法(如 GRPO)更新模型。这样既支持复杂场景,又不用自己造轮子。 自动中间奖励 (AIR):除了最终结果,还会根据工具调用是否成功、是否陷入死循环等“中间信号”给小分,缓解奖励稀疏问题,让 Agent 学得更快。

让 Agent 开发者只关心“怎么把事干成”,而把“怎么从干成的事里学得更聪明”这件事,交给一个专门的学习系统。

🚀 Agent Lightning 是怎么工作的?

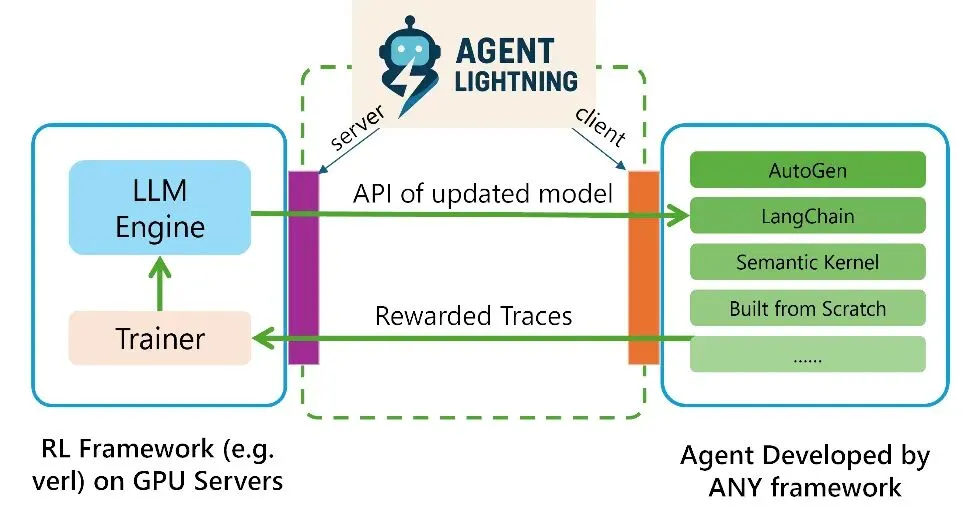

1. 训练–Agent 解耦架构

Lightning Server:训练大脑,负责拉取任务、运行 RL 算法、更新模型,并提供类似 OpenAI 的接口给 Agent 调用。 Lightning Client:运行你的 Agent,负责执行任务、采集轨迹(State、Action、Reward 等),并上报给 Server。

2. 统一数据接口:把 Agent 执行抽象成 MDP

State:当前执行快照,比如用户输入、历史对话、工具返回结果、内存中的变量等。 Action:LLM 的输出,比如生成的 SQL、调用的工具、选择的策略等。 Reward:任务完成情况的标量信号,比如 SQL 是否正确、答案是否匹配、用户是否满意等。

对 RL 算法来说,它看到的不是“这个 Agent 有多复杂”,而是“一堆 (State, Action, Reward) 序列”,这就大大降低了算法适配的难度。

3. LightningRL:分层强化学习算法

最终任务成功了,到底该归功于哪一步 Action?

轨迹层:先给整条轨迹一个总体奖励(比如任务成功 +1,失败 -1)。 Token/Step 层:通过信用分配模块,把总体奖励合理地分配到每一步,让每一步都知道“自己对最终结果的贡献有多大”。 策略更新:对每一步,用分配到的奖励和单轮 RL 算法(如 GRPO、PPO)更新模型。

4. 自动中间奖励 (AIR):让 Agent 学得更快

5. 实验验证:Text-to-SQL、RAG、数学 QA 全面提升

Text-to-SQL:用 LangChain 实现的 Agent,在 Spider 数据集上,经过训练后,SQL 生成和修正的准确率持续提升。 RAG:用 OpenAI Agents SDK 实现的 Agent,在 MuSiQue 数据集上,学会了生成更有效的检索查询,F1 分数稳步上升。 数学 QA:用 AutoGen 实现的 Agent,在 Calc-X 数据集上,调用计算器的准确性和时机把握明显变好。

如果说算法层的设计是 Agent Lightning 的“灵魂”,那么系统架构设计就是其“骨架”,是确保理念落地的关键。Agent Lightning 开创性地提出了训练-智能体分离式架构。这一架构将计算密集的 RL 训练框架(部署于 GPU 服务器)与多样化、轻量级的智能体应用(可部署于任何普通机器)完全解耦。

该架构由两部分组成:

Lightning Server:部署在云端或 GPU 服务器,与 RL 训练框架(如 verl 等)集成。它负责管理训练流程、维护更新后的 LLMs 模型,并向外暴露一个类似 OpenAI 的 API 接口。 Lightning Client:一个轻量级的客户端,部署在用户侧。它负责执行用户的智能体代码,通过内置观测和数据捕获机制(如利用 OpenTelemetry)自动收集轨迹数据,并将这些数据回报给服务器。

这种分离式设计带来了前所未有的灵活性:

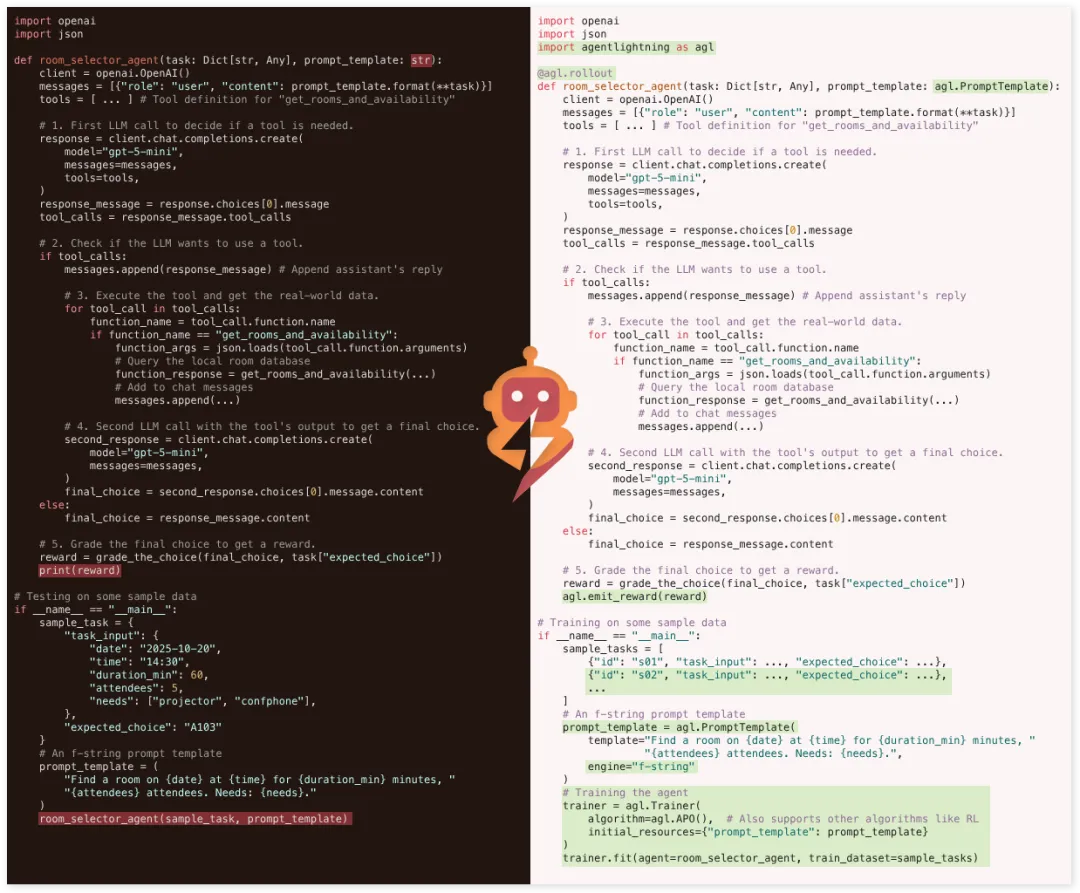

开发者友好:智能体开发者无需关心底层 RL 训练的复杂性,可以继续使用自己熟悉的框架(LangChain、AutoGen 等)进行开发,只需将原来调用 OpenAI API 的接口替换为 Agent Lightning Server 提供的 API。 零代码侵入:得益于巧妙的数据捕获机制,整个优化过程几乎不需要对现有的智能体业务逻辑进行任何修改。 资源高效利用:智能体的执行(通常是 I/O 密集型)和模型的训练(计算密集型)可以部署在最适合它们的硬件上,实现了资源的最优配置和高度的可扩展性。

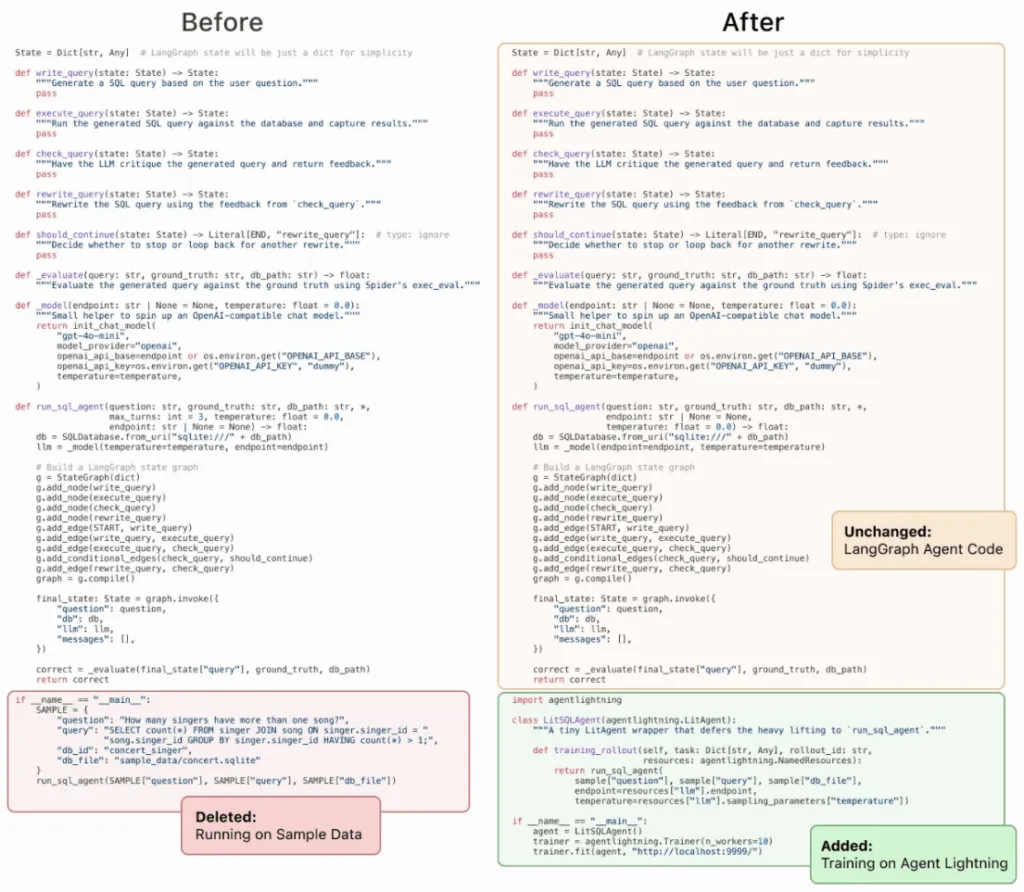

左侧为使用 LangGraph 实现的 Agent 的代码,右侧绿色部分是 Agent Lightning 需要加的代码,黄色部分(Agent 主体代码)为保持不变的代码。

左侧为使用 LangGraph 实现的 Agent 的代码,右侧绿色部分是 Agent Lightning 需要加的代码,黄色部分(Agent 主体代码)为保持不变的代码。👍 Agent Lightning 的优点

1. 零代码侵入,框架无关

对很多团队来说,这意味着“不用推翻重来”,就能把 Agent 从“能用”升级到“越用越强”。

2. 专注业务,解放精力

3. 支持多 Agent 协作

这对复杂的业务流程(比如软件开发、数据分析)特别有用,因为你可以逐步优化系统的瓶颈环节,而不是一次性重构整个系统。

4. 生产就绪,可扩展

分布式训练:支持多 Runner 并行执行 Agent,提高数据收集效率。 错误监控:能跟踪 Agent 的执行状态,检测失败模式,给 RL 算法提供更好的信号。 灵活扩展:支持不同的 RL 算法、不同的模型、不同的 Agent 框架,未来还会支持更多优化方法(比如自动提示词优化、模型选择等)。

🆚 和其他类似平台的对比

工具/平台 | 定位 | 核心特点 | 适用场景 |

|---|---|---|---|

Agent Lightning | 通用 Agent 强化学习框架 | 训练–执行解耦、框架无关、支持多 Agent、生产就绪 | 需要在真实业务场景中,用 RL 优化现有 Agent 的团队 |

ART (Agent Reinforcement Trainer) | 动态环境 Agent 优化框架 | 以 POMDP 建模、支持 GRPO/RLVR 等算法、可插拔环境 | 需要在动态环境(比如 Web 浏览、代码调试)中优化 Agent 行为的团队 |

DSPy | 提示词优化与模型编排框架 | 通过声明式编程优化提示词和模型调用、支持多种优化算法 | 希望通过提示词工程和模型选择提升 Agent 性能的团队 |

Coze Loop | Agent 开发与调试平台 | 提供可视化工作流、SDK、追踪功能、与 Coze Studio 深度集成 | 希望快速构建、调试和部署 Agent 的团队,尤其是非技术用户 |

传统 RL 框架 (如 TRL) | 单轮任务强化学习框架 | 支持 PPO、DPO 等算法、与 HuggingFace 生态深度集成 | 主要优化单轮任务(比如数学题、文本对齐)的团队 |

🤔 谁适合用 Agent Lightning?

1. 业务复杂度

2. 数据积累

3. 技术能力

🎯 写在最后

如何让 AI Agent 从“能用”到“越用越聪明”?

把“训练”和“执行”拆开,用强化学习把 Agent 的真实交互数据变成“老师”,让 Agent 在真实任务里学会自我进化。

让 Agent 不再只是一个“工具”,而是一个“能从经验里学习的系统”。

原来让 Agent 变强的,不是某一次 Prompt 的灵光一现,而是它每一次失败、每一次重试、每一次从错误中学习的积累。

开源地址

关注公众号 回复 20260204 获得

猜您喜欢:

【开源】告别重复造轮子:这套AI视频平台,让企业级开发成本直降95%,一套打通芯片、算法与应用的商用AI视频管理平台

【开源】69.5K star的BI 神器!这款数据可视化系统让数据可视化与探索更简单,零代码拖拽 + SQL 实验室玩转数据

【开源】比钉钉/飞书更灵活?这款开源平台:100%自主可控,3步定制企业协同方案

【开源】6.9K Star 实时数字人 :对话更自然、延迟更低,从声音克隆到全身视频拼接一站打通,直播、教育、客服都能用

6元解锁620+优质开源项目!技术会员群上线,包括60+低开平台,50+AI平台

添加微信进相关交流群,

备注“微服务”进群交流

备注“低开”进低开群交流

备注“AI”进AI大数据,数据治理群交流

备注“数字”进物联网和数字孪生群交流

备注“安全”进安全相关群交流

备注“自动”进自动化运维群交流

备注“试用”可以申请产品试用

备注“定制”可以定制项目,全源码交付