Python|【EI复现】基于深度强化学习的微能源网能量管理与优化策略研究

- 2026-02-05 00:51:40

点击上方荔枝科研社关注我们

📋📋📋本文目录如下:🎁🎁🎁

目录

💥1 概述

📚2 运行结果

2.1 有/无策略奖励

2.2 训练结果1

2.3 训练结果2

🎉3 参考文献

🌈4 Python代码、数据、文章

1概述

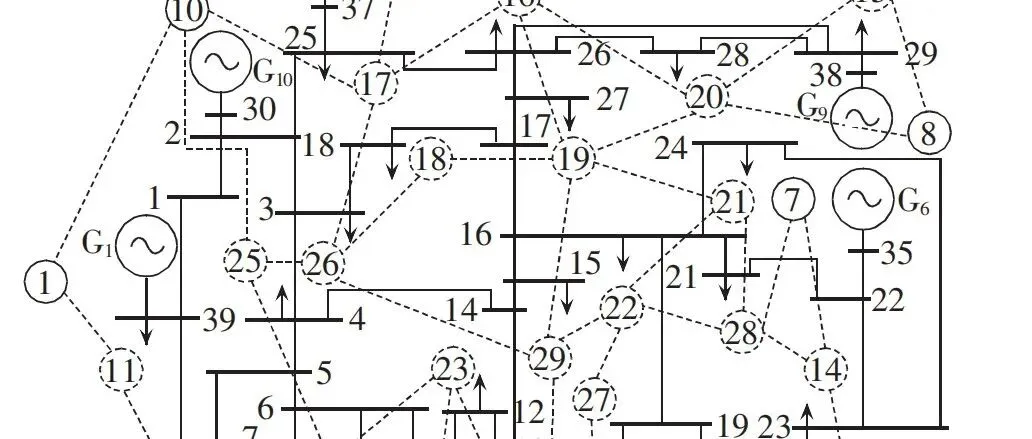

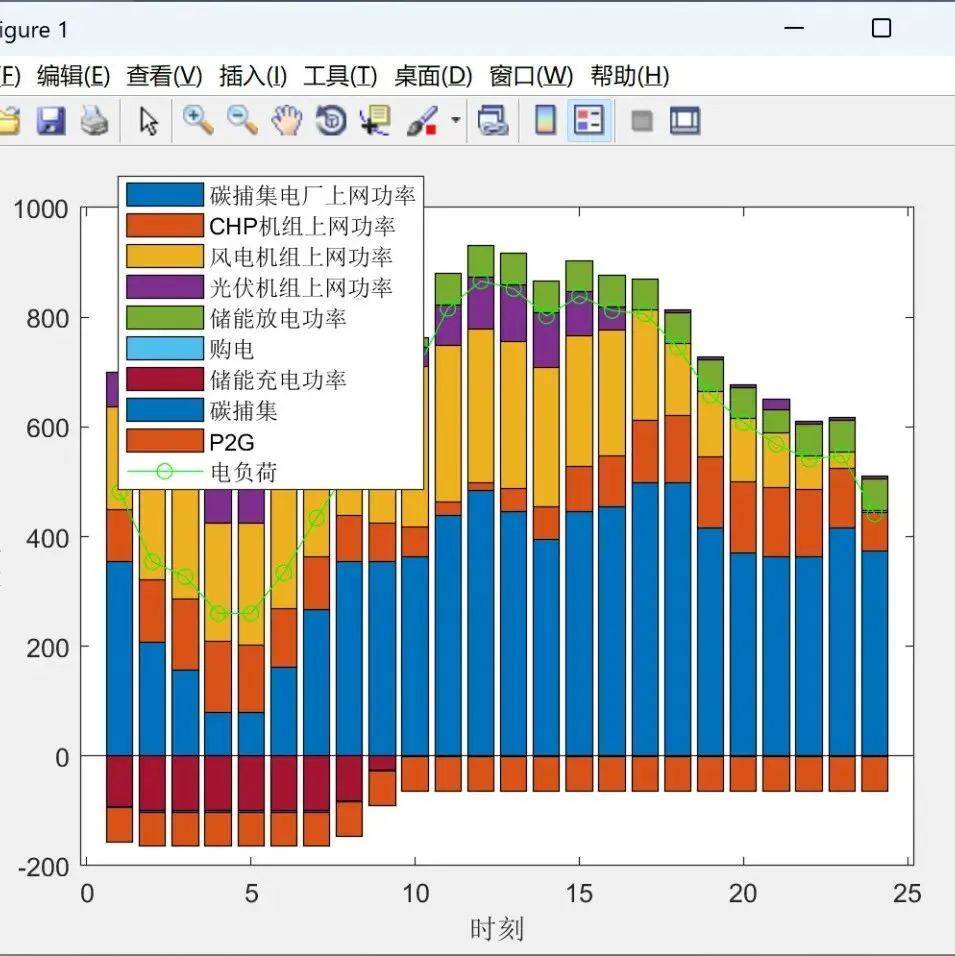

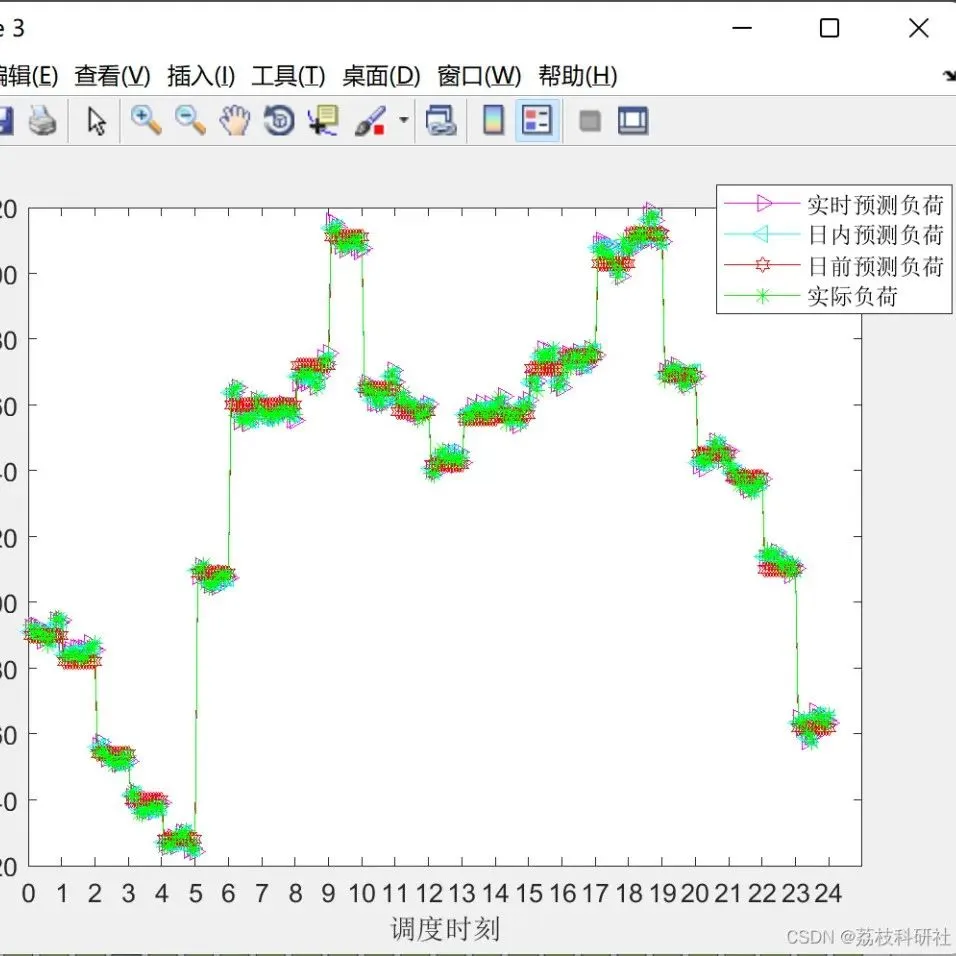

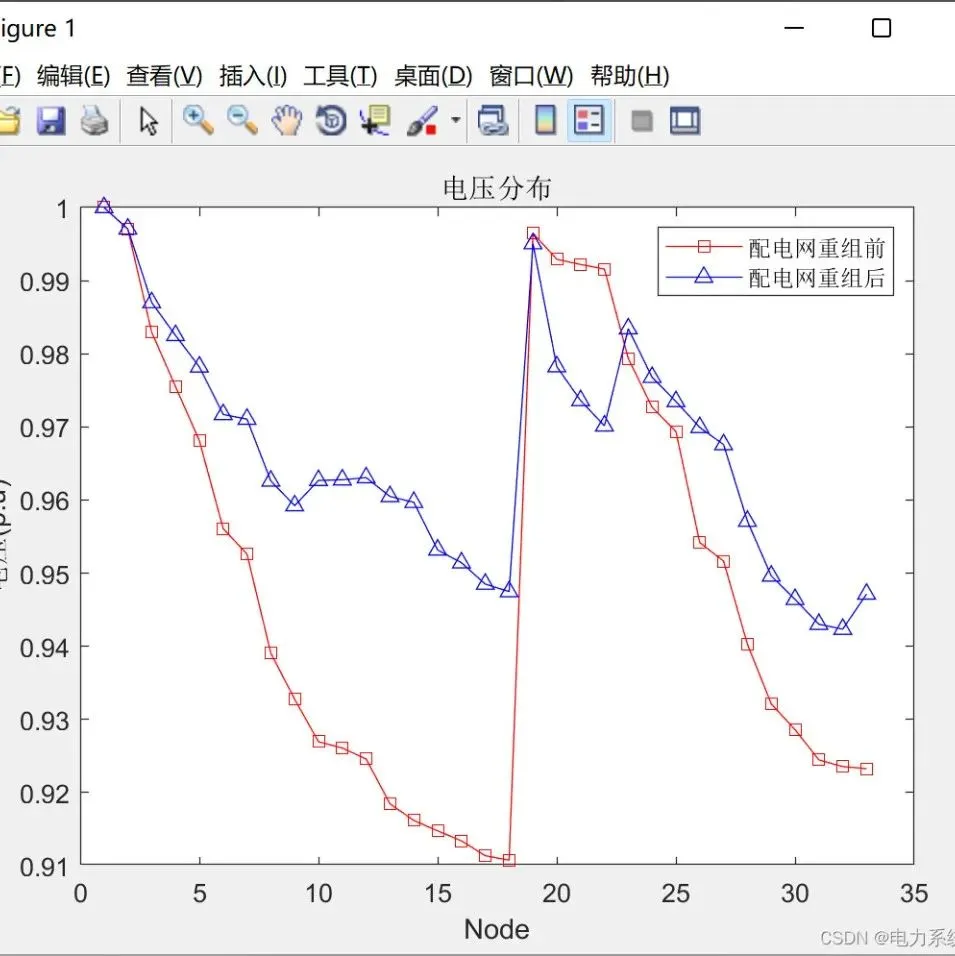

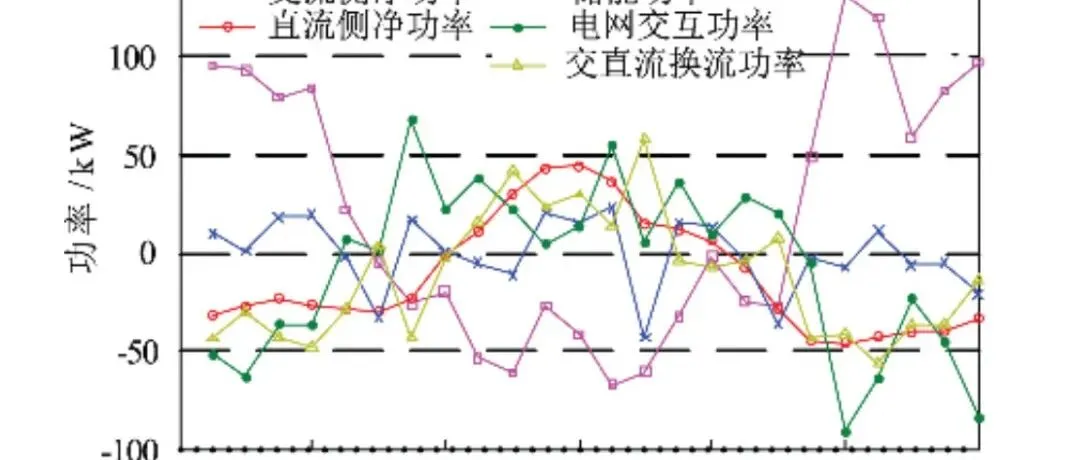

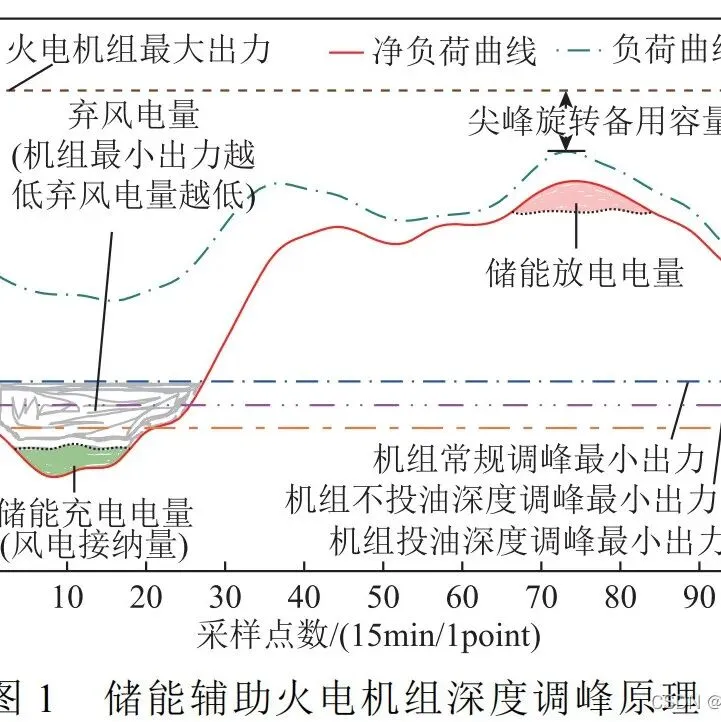

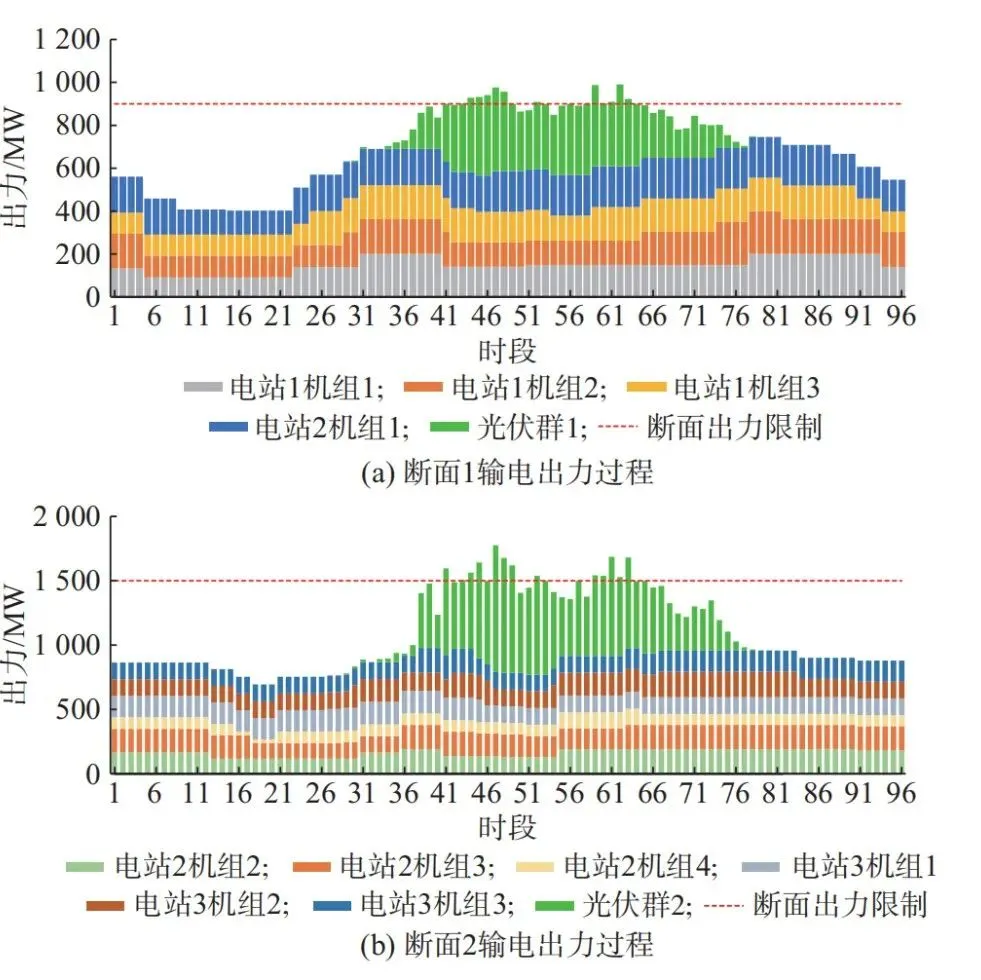

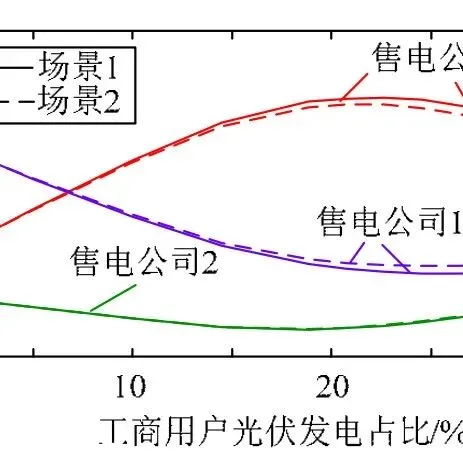

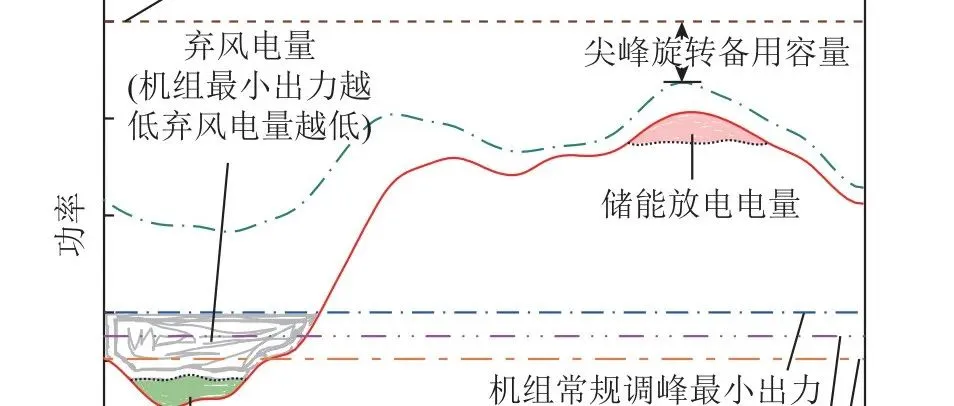

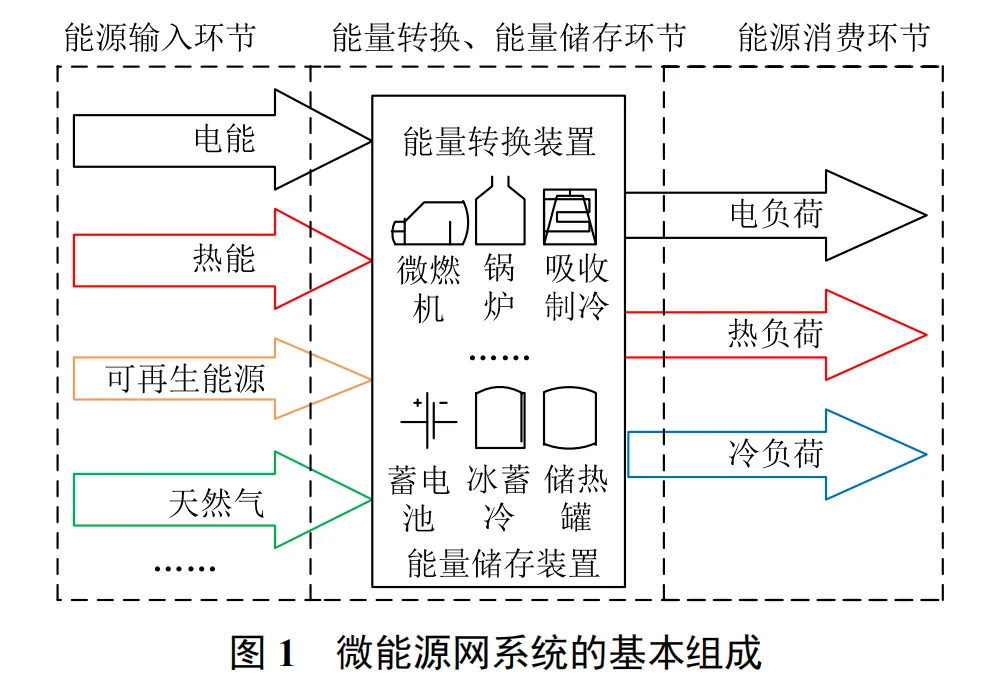

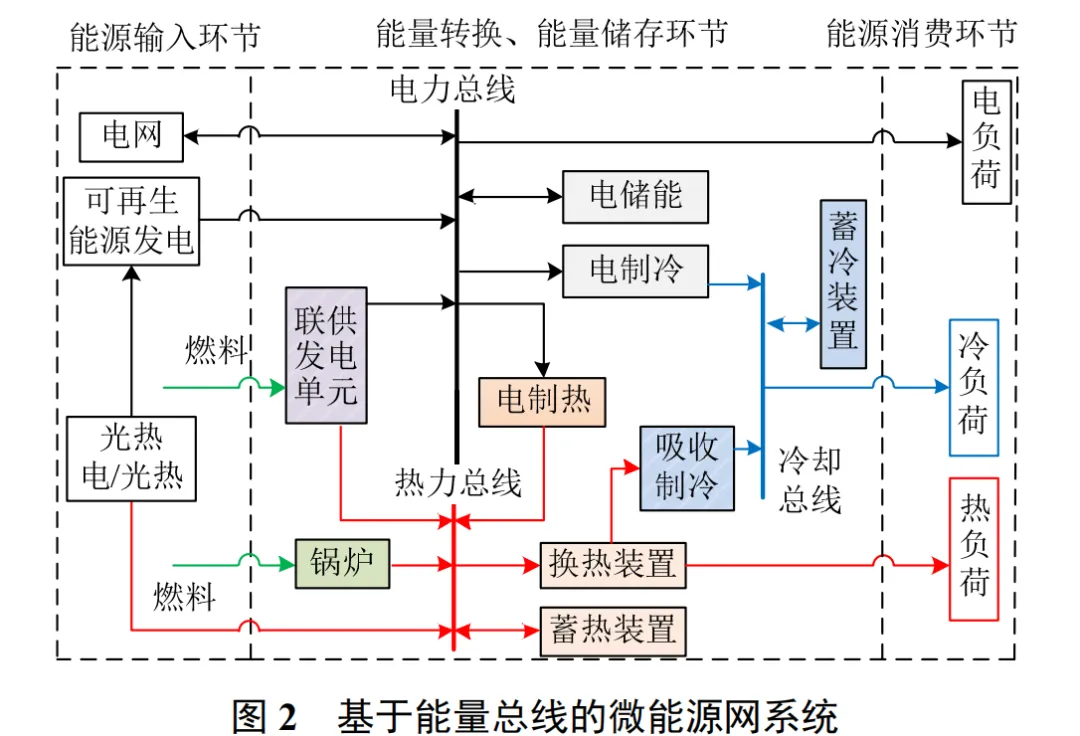

根据微电网或微能源网是否与主电网相连接,可将其分为并网型和独立型 2 种。本文以并网型微 能源网为研究对象,研究其并网运行的能量管理与优化问题。目前,针对微能源网的能量管理,从算法上来讲,多结合最优化算法或者启发式算法进行。文献[3]建立了微网混合整数非线性模型,通过将其分解为组合问题和最优潮流问题,避免直接求解混合整数非线性问题,加快了寻优速度。文献[4]通过概率约束对旋转备用储能的不确定性进行建模,提出了一种使用机会约束规划来最小化微网运营成本的最优调度方法。文献[5]在考虑可再生能源随机性和用户满意度的情况下,热电解耦的同时通过基于概率约束规划法优化,使运行成本最低。文献[6]提出一种基于记忆机制的遗传算法,对微网运行成本最小化问题进行求解。文献[7]提出了一种新的混合粒子群优化算法对含有可再生能源的微电网进行优化。文献[8]在考虑符合满意度的基础上,利用 NSGA-II 算法对微电网运行进行多目标优化。文献[9]基于 Stone-Geary 函数和双向拍卖机制构建了智慧能源系统能量优化模型,给出了通过收敛判定域引导的全局随机寻优与区域定向寻优策略。最优化算法的计算效率较高,但是其在处理非线性、非凸或非连续问题时难以逃出局部最优。启发式算法可以在给定的条件下求得相应的最优解或 Pareto 前沿,但限制多,计算耗时长且算法泛化学习能力不足。关键词:微能源网;能量管理;深度强化学习;Q-learning;DQN这种基于深度强化学习的微能源网能量管理与优化方法,不仅可以有效地预测微能源网的负荷需求和可再生能源的功率输出,还能够根据环境信息和分时电价进行智能化的能量调度。通过深度 Q 网络(DQN)的学习,系统可以不断优化能量管理策略,以最大程度地利用可再生能源并降低能源浪费。这种模型无关的智能算法还可以适应不同类型的微能源网,为各种规模和结构的能源系统提供定制化的能量管理方案。因此,这种创新的解决方案为可再生能源的接入和利用开辟了全新的可能性,有望推动微能源网的智能化发展,促进可再生能源在能源领域的更广泛应用。

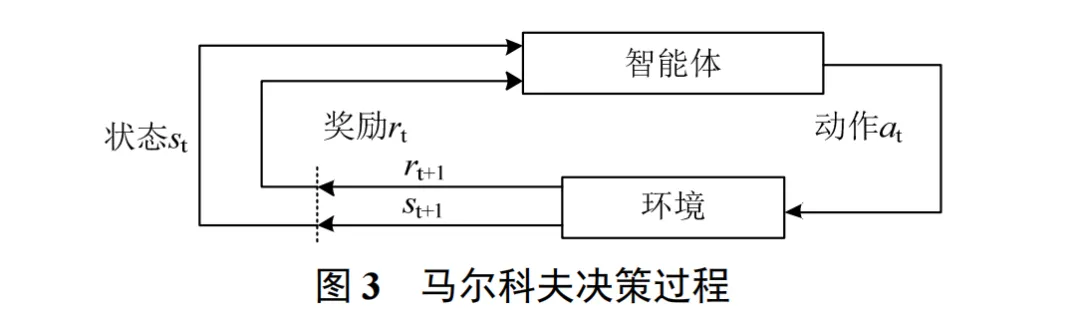

强化学习是指从环境状态到动作策略集的学习,以使得动作从环境中获得的累计奖励最大,学习的过程,如图 3 所示。本质上,智能体与环境的互动是一种马尔科夫决策过程(markov decisionprocess,MDP)。MDP 一般由一个四元组(S, A, R, ) 定义,其中:

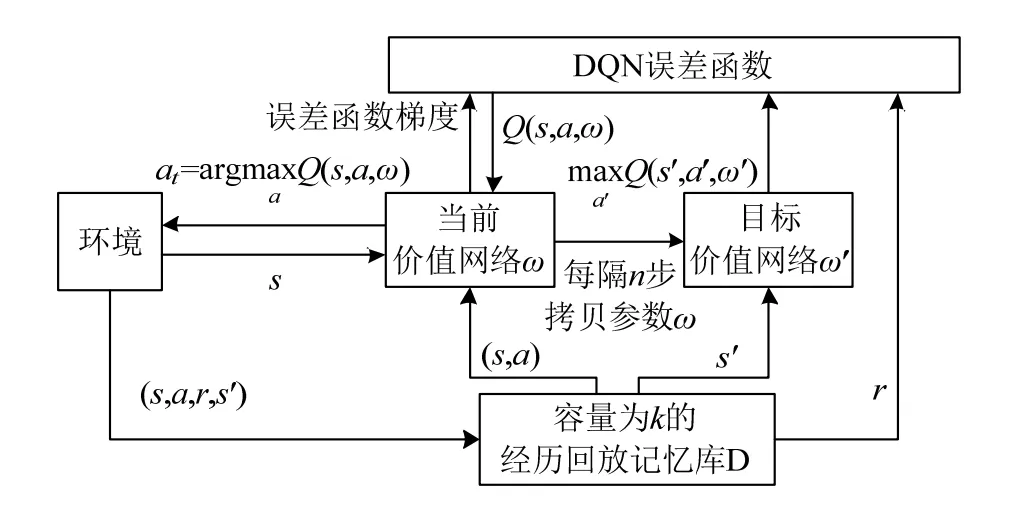

在传统的 Q 学习算法中,由于维数灾难,强化学习难以解决大规模MDP问题或连续空间MDP问题。因此,价值函数近似方法被提出以解决这一问题。

2运行结果

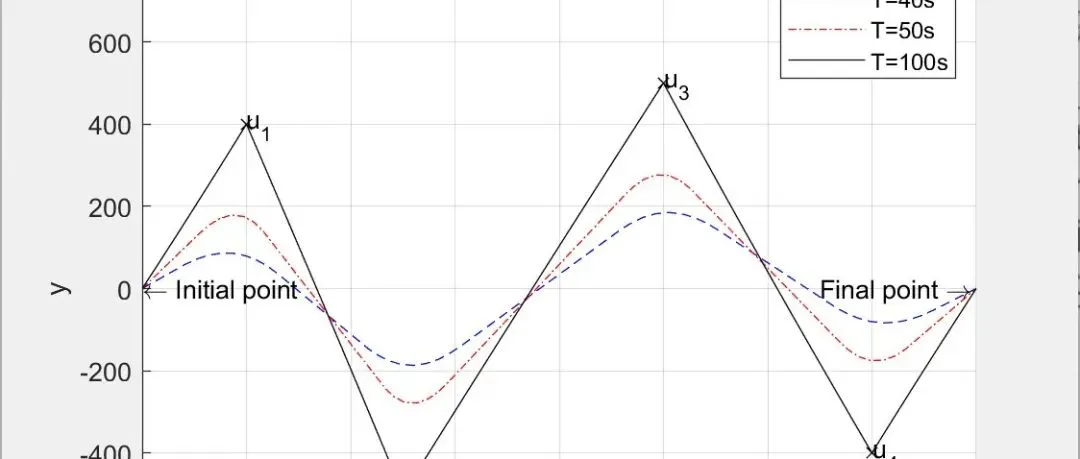

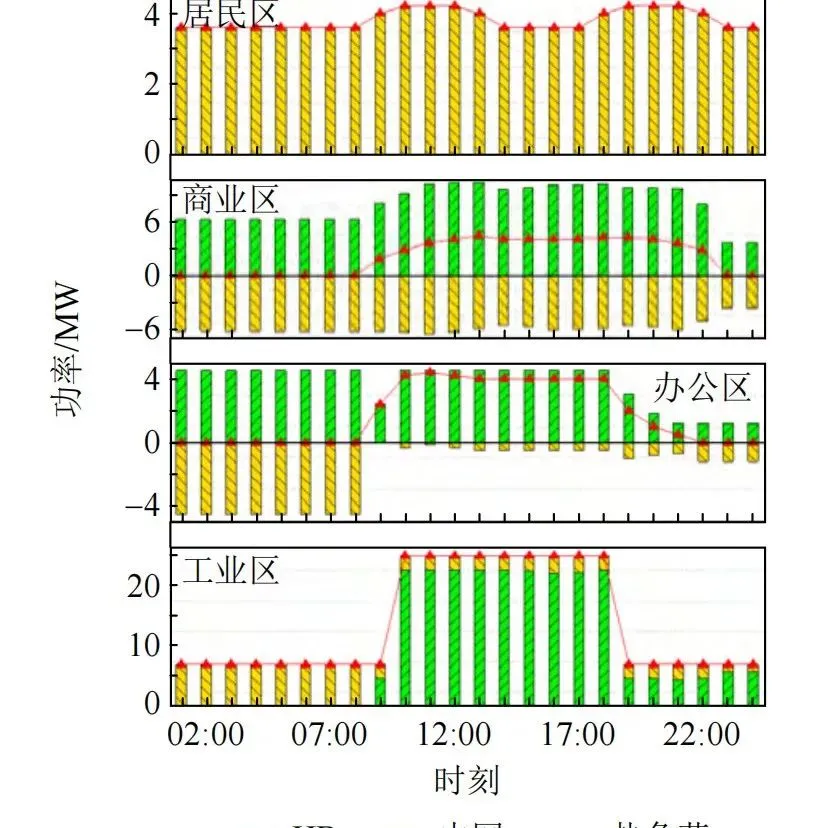

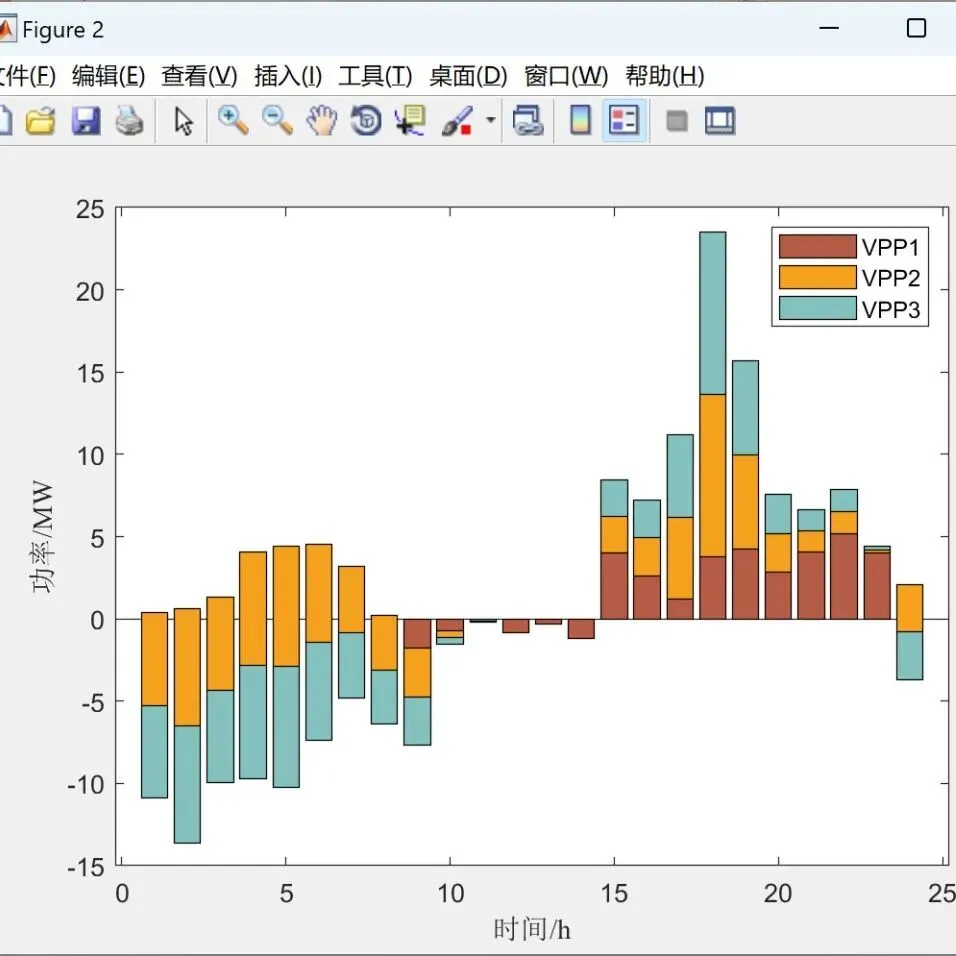

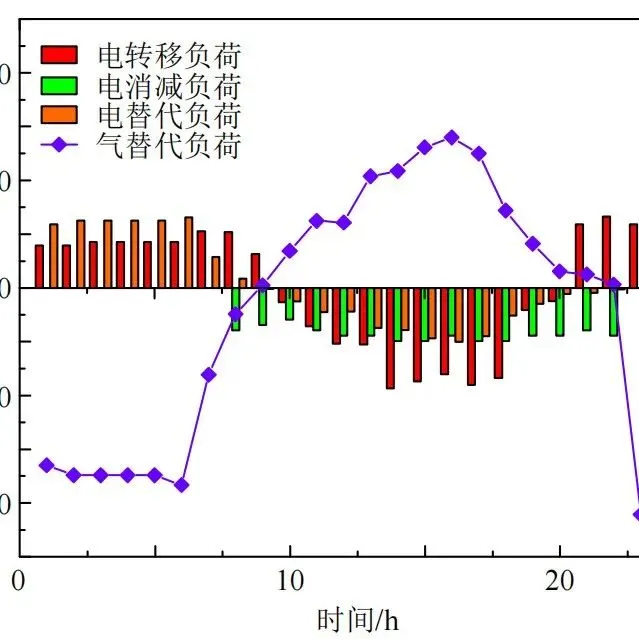

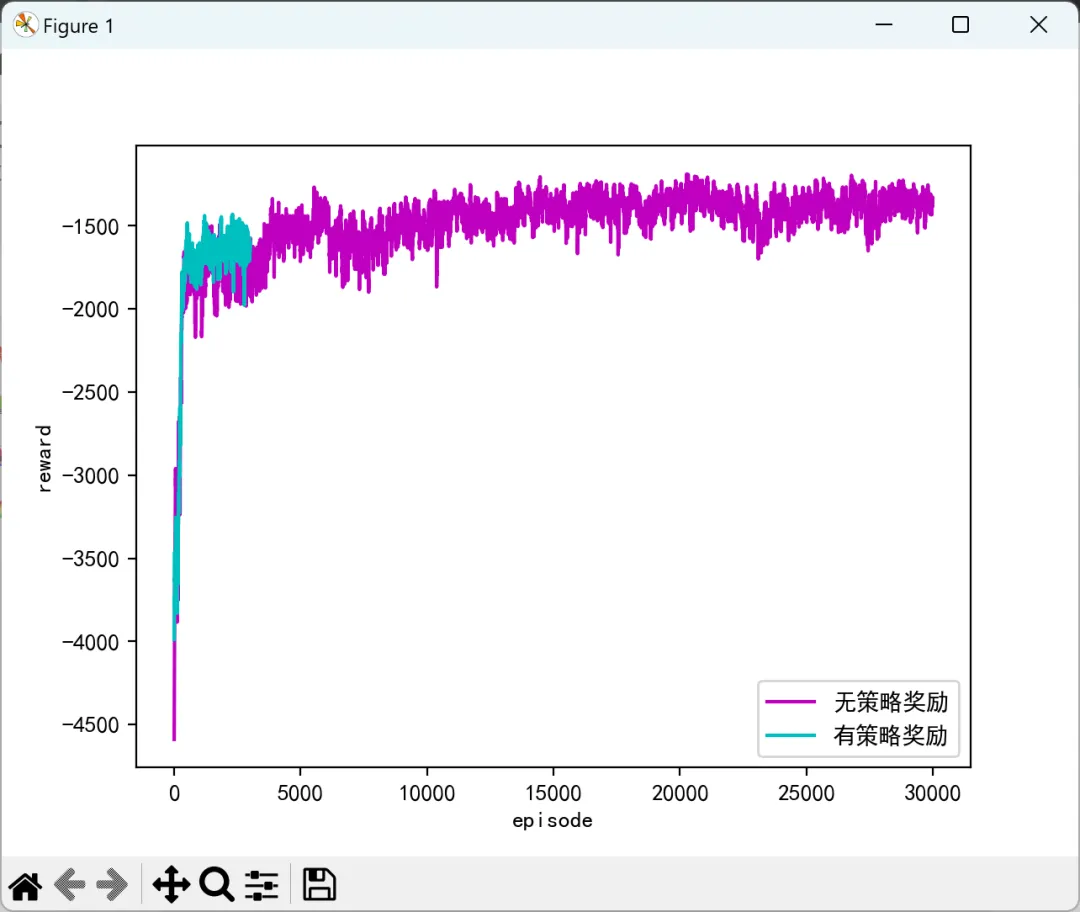

2.1有/无策略奖励

2.1有/无策略奖励

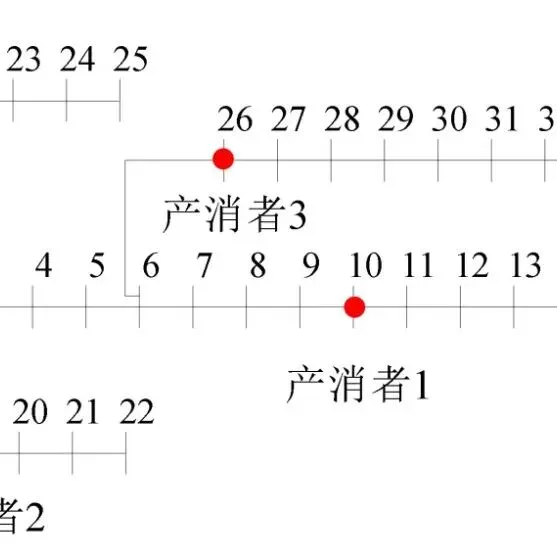

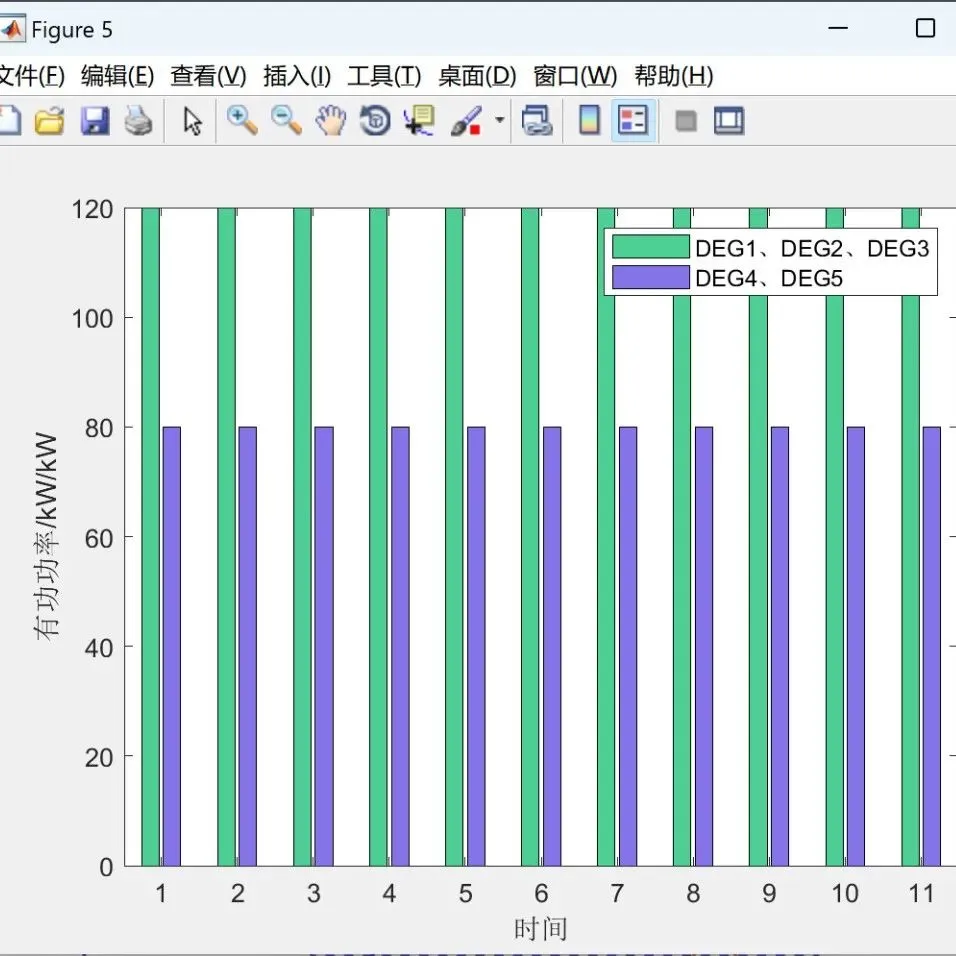

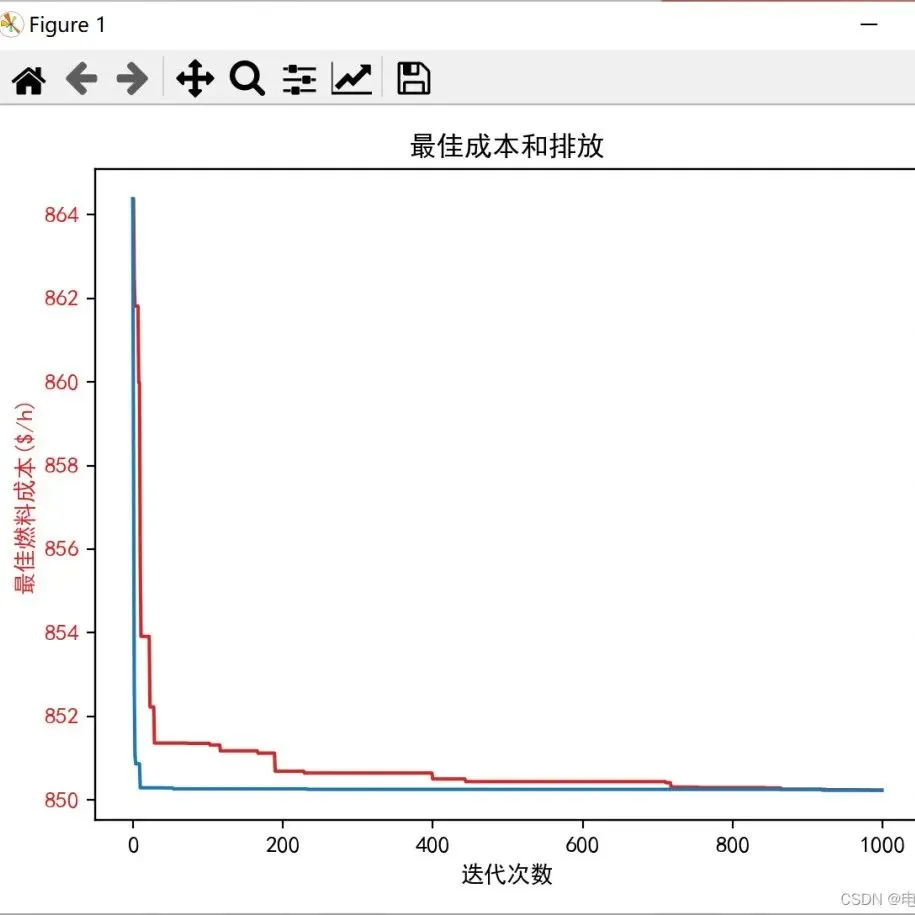

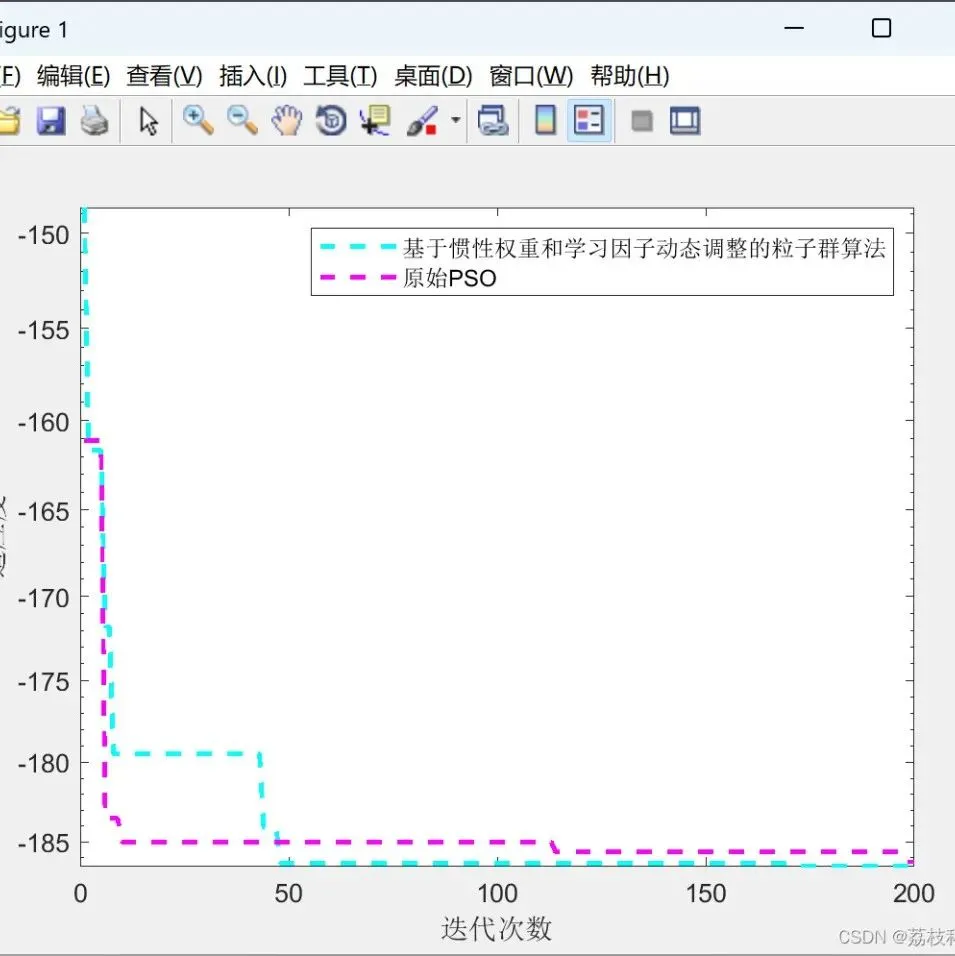

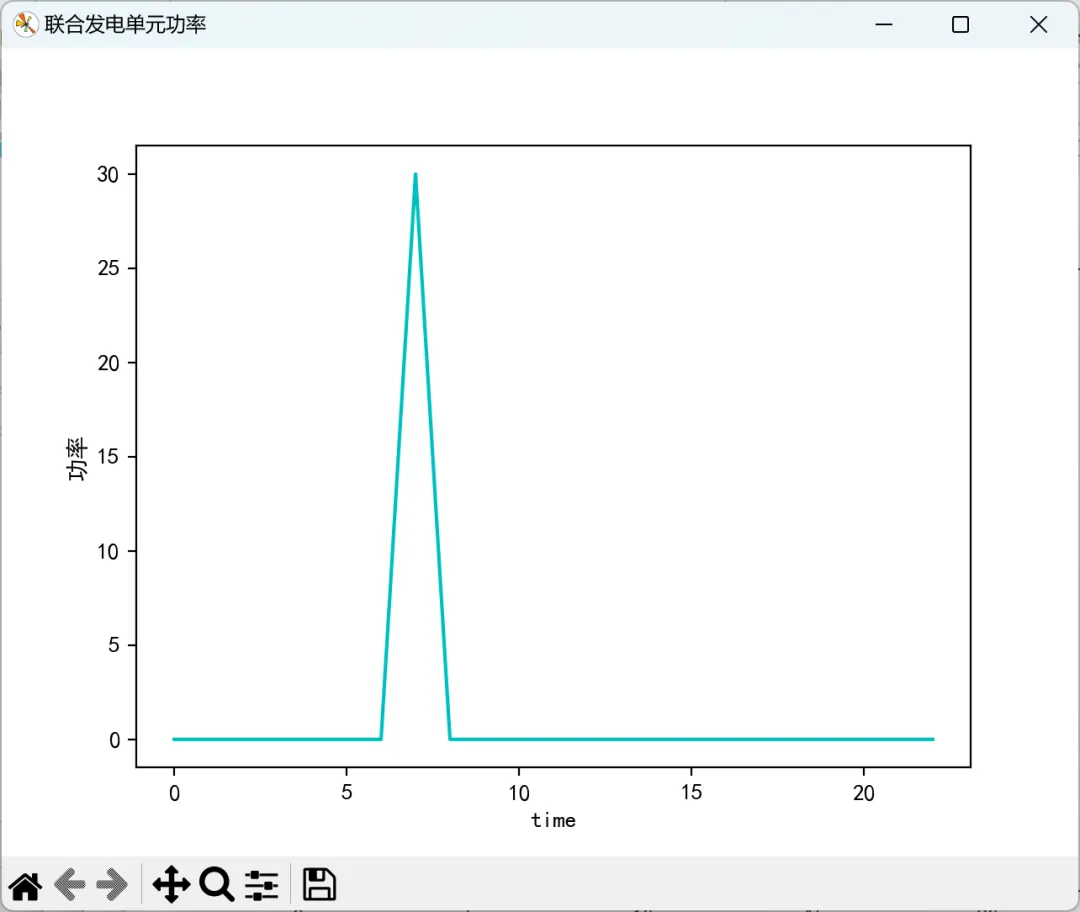

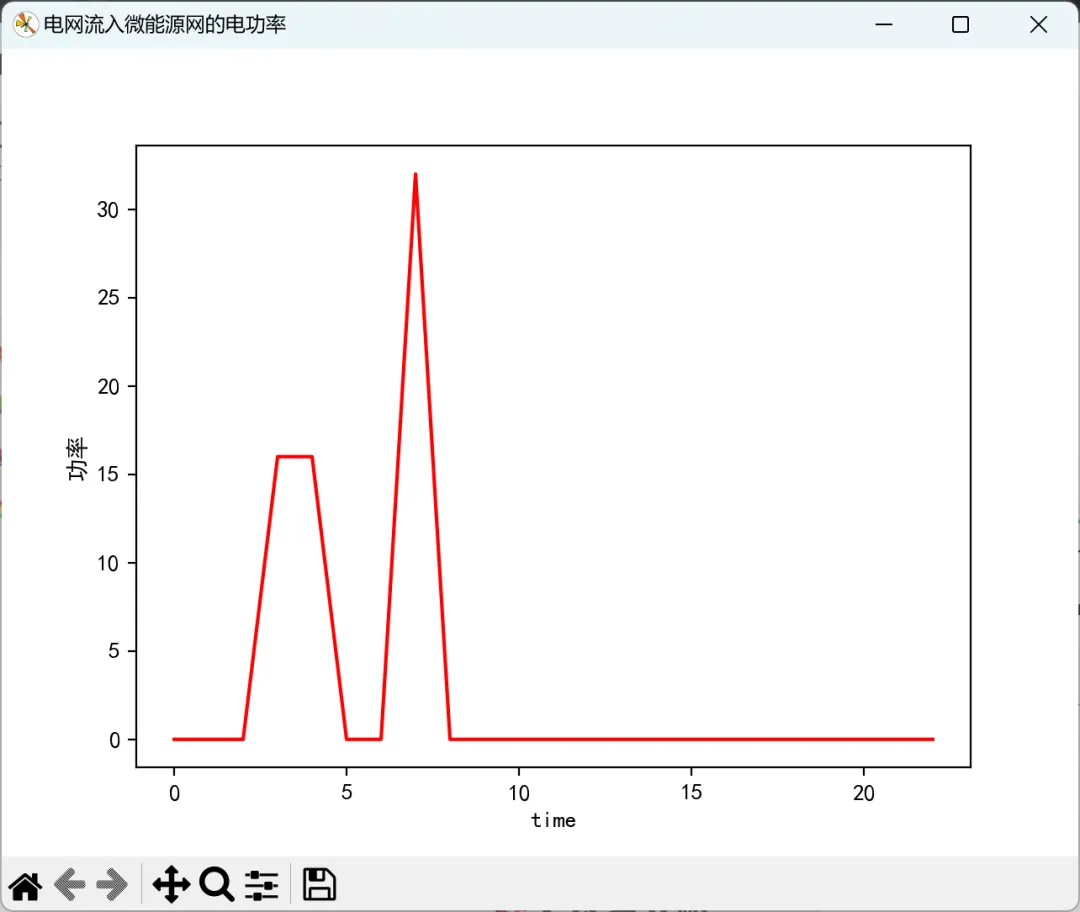

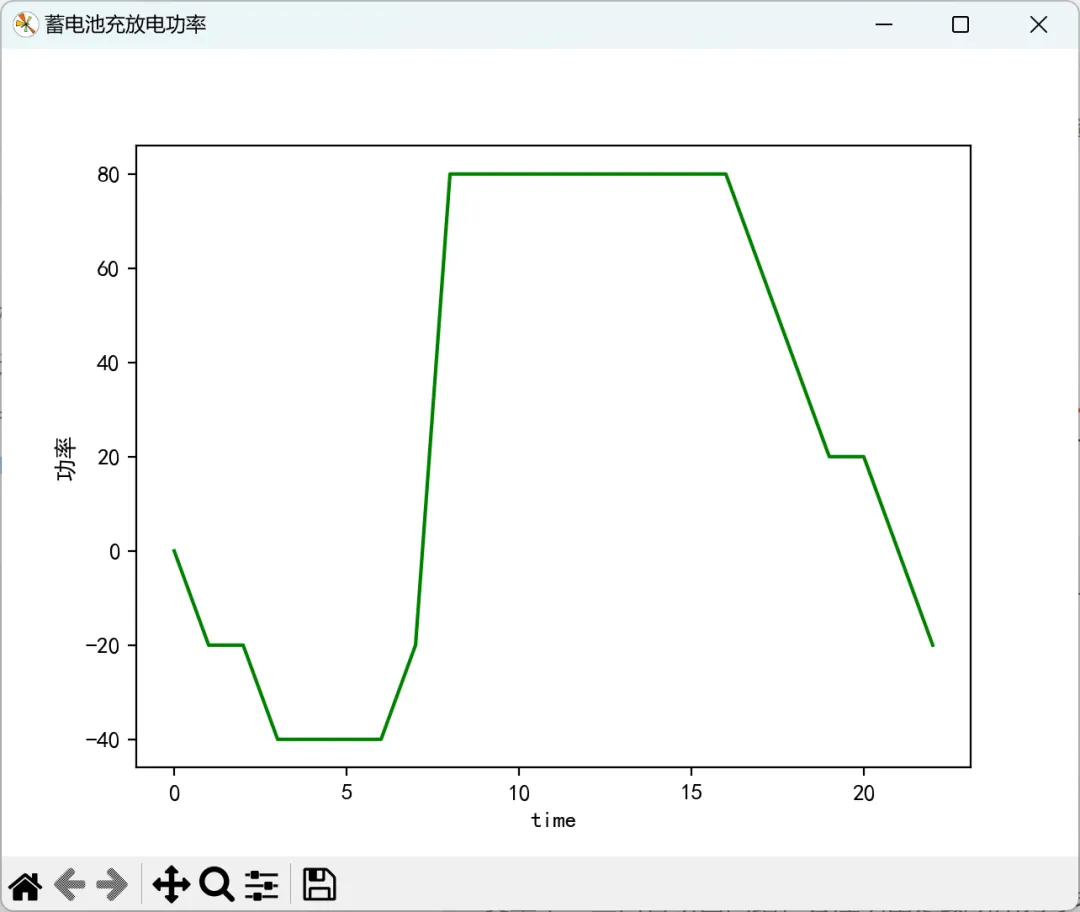

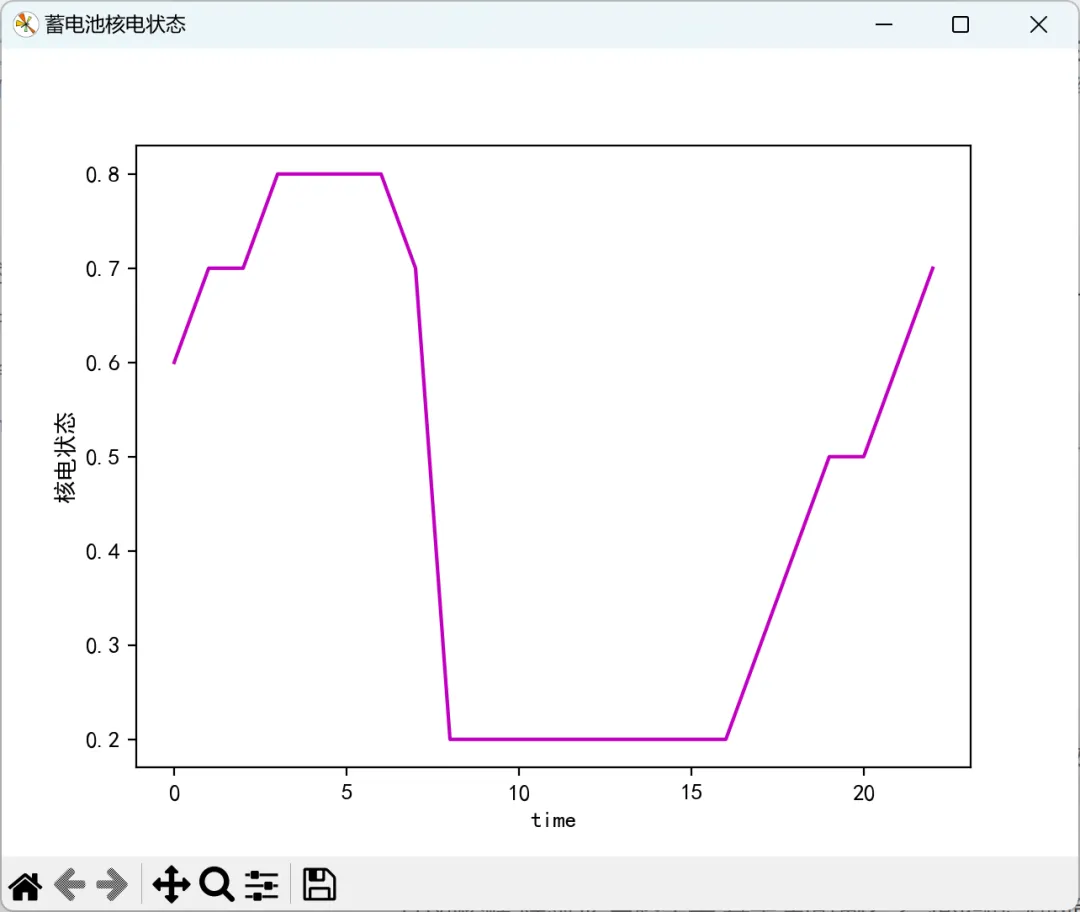

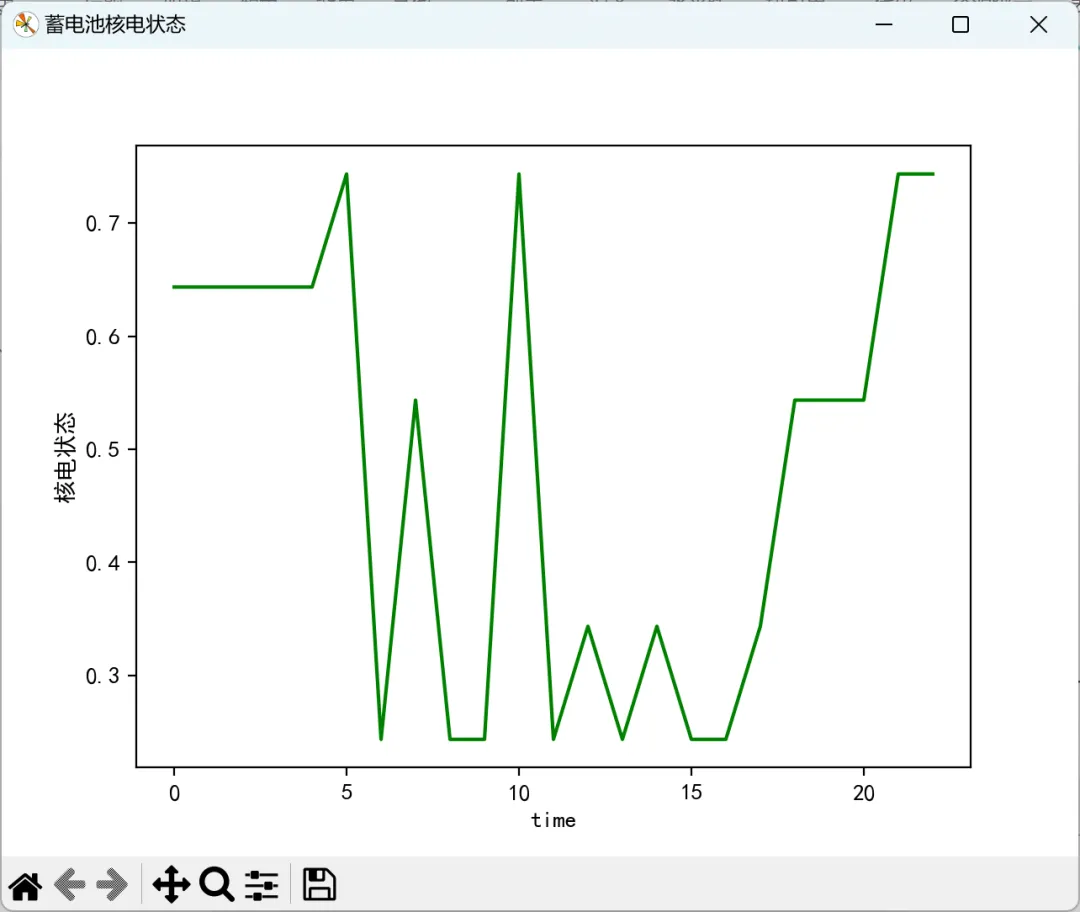

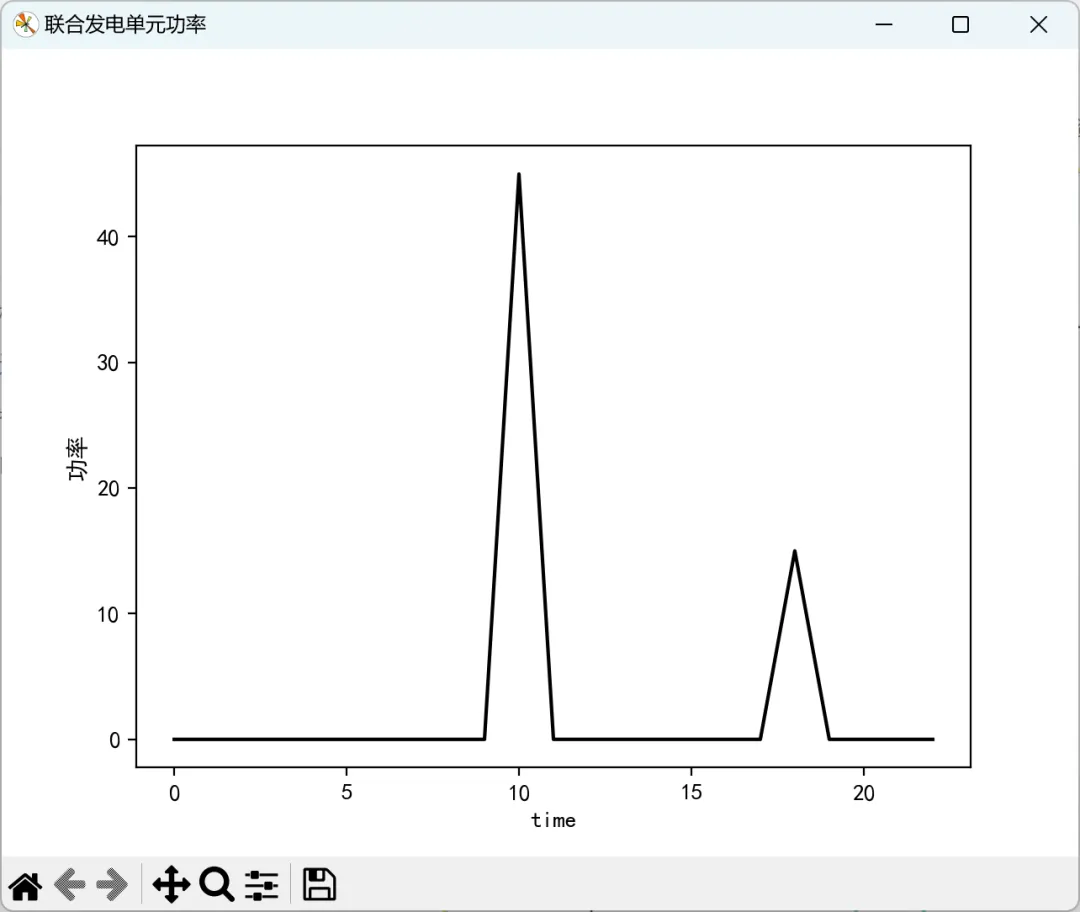

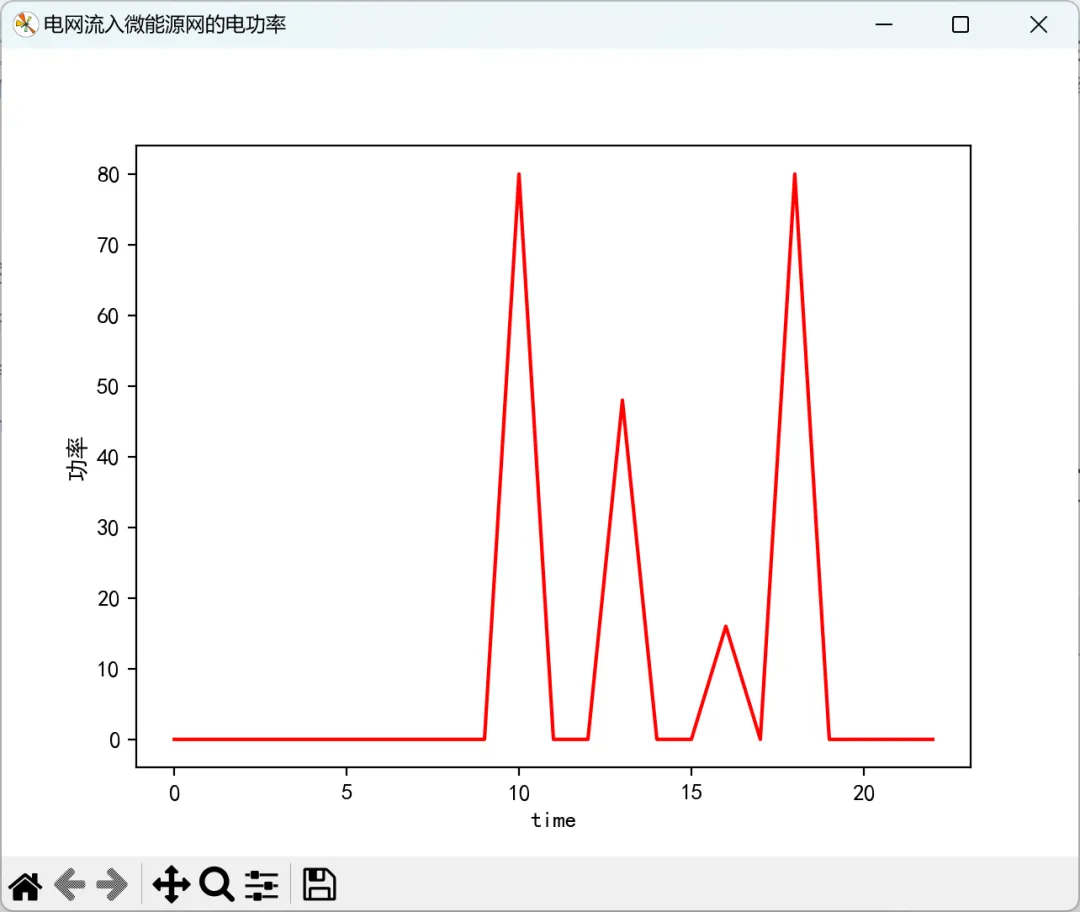

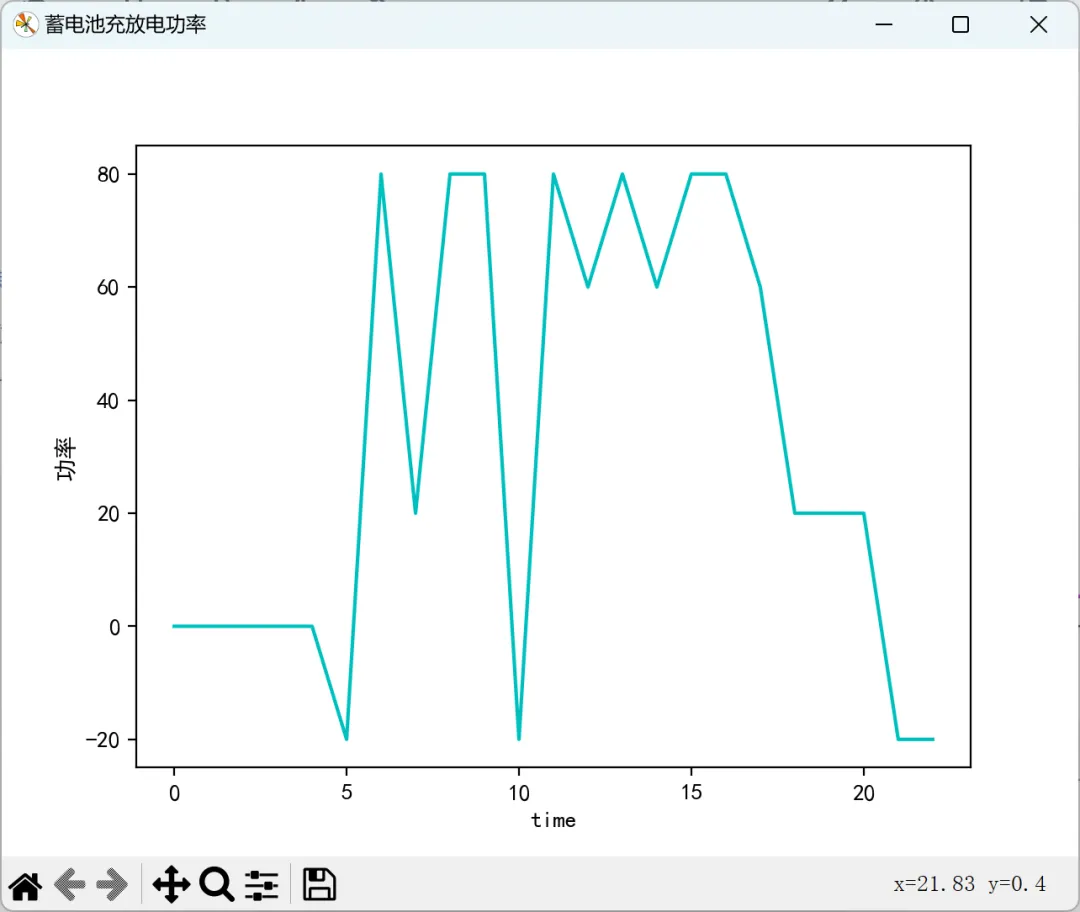

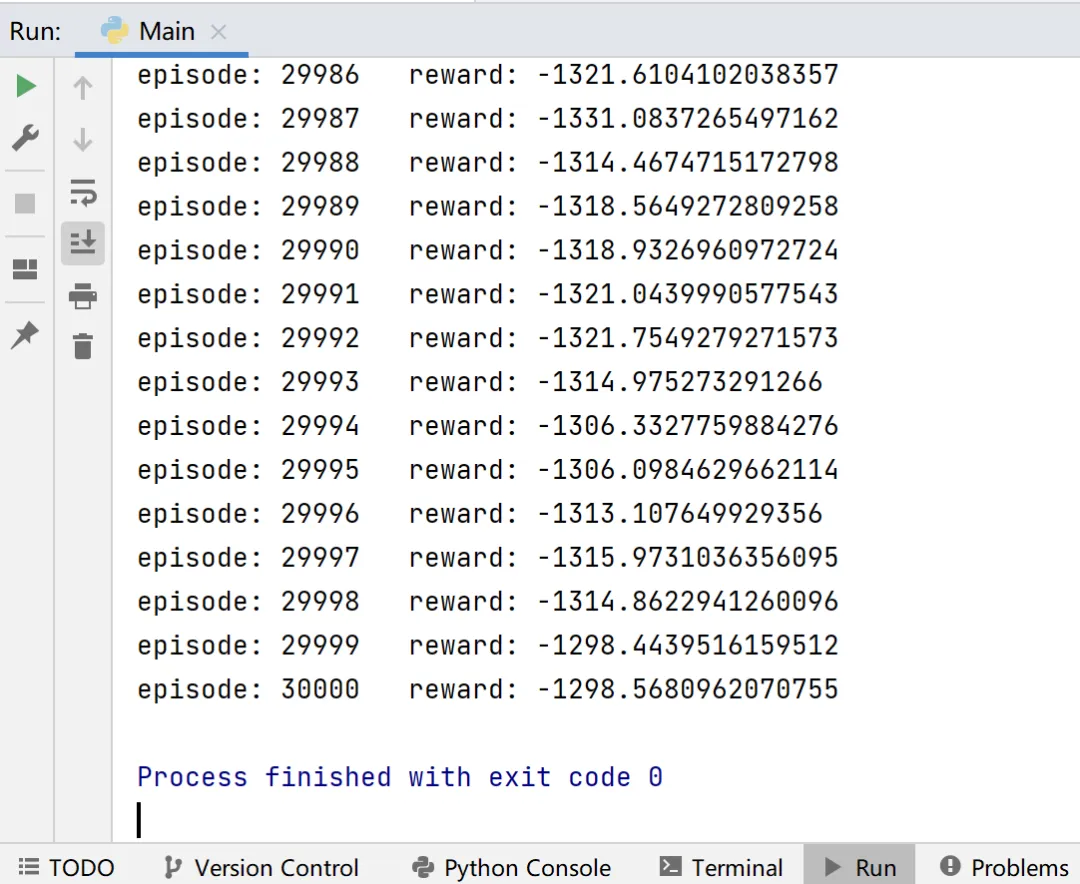

2.2训练结果1

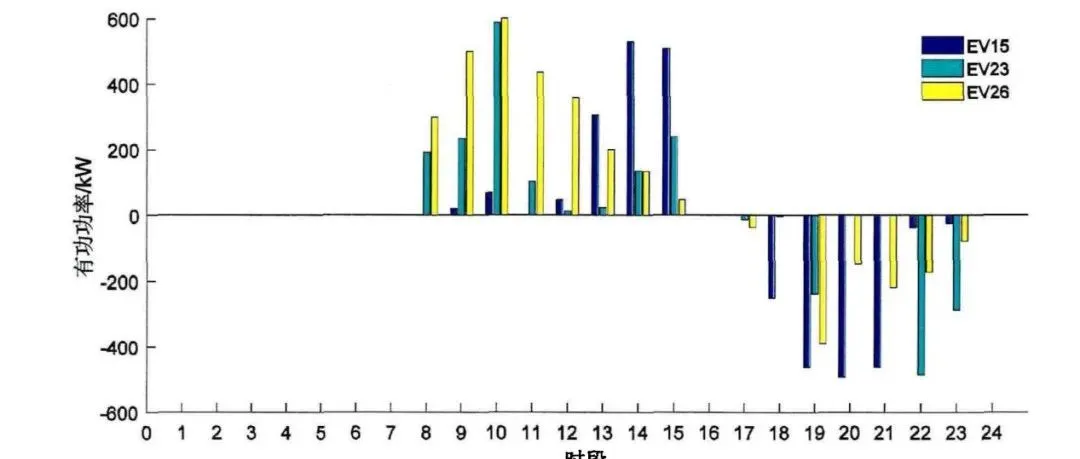

2.3训练结果2

3参考文献

3参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。

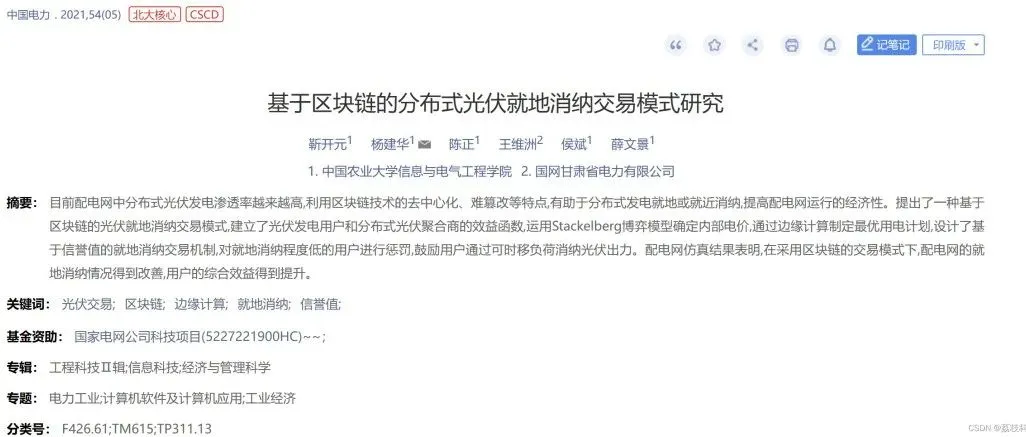

[1]刘俊峰,陈剑龙,王晓生等.基于深度强化学习的微能源网能量管理与优化策略研究[J].电网技术,2020,44(10):3794-3803.DOI:10.13335/j.1000-3673.pst.2020.0144

[2]陈剑龙.基于深度强化学习的微能源网能量管理策略研究[D].华南理工大学,2020.DOI:10.27151/d.cnki.ghnlu.2020.003401

4Python代码、数据、文章